-

随着国家大力提倡人工智能产业的发展,水下机器人被广泛使用在深海勘探等方面。由于悬浮的散射颗粒对光场的吸收和散射作用导致水下图像出现对比度低、颜色偏差和细节模糊等问题[1],使得水下机器人无法获取高质量的水下清晰图像,因此水下图像增强成为一个非常重要的处理步骤。

近年来,一些研究者尝试利用深度学习技术改善图像质量问题,并在图像去雾[2]等方面得到广泛应用。Fabbri等[3]提出水下生成对抗网络(Underwater Generative Adversarial Networks,UGAN),生成器使用了类似于编解码框架,而判别器通过对输出进行L约束,能较好地提升水下图像质量。针对水下图像存在细节模糊和颜色失真问题,Guo等[4]介绍了一种多尺度密集块(Multiscale Dense Block,MSDB)算法进行水下图像增强,即密集生成对抗网络(Dense Generative Adversarial Networks,DensGAN),在MSDB中,输入的特征需通过两个分支,并且特征会在两个分支中间进行串联之后再次反馈到各自支路中,判别器类似于PatchGAN[5](Patch Generative Adversarial Networks)。Ye等[6]提出了一种堆叠条件生成对抗网络的水下图像增强(Underwater Image Enhancement Based On Stacked Generative Adversarial Networks,UIE-sGAN),包括雾度检测子网和色彩校正子网,雾度检测子网的输出是雾度掩膜(Haze mask),并将雾度掩膜和RGB图像作为颜色校正子网的输入,并输出颜色校正的水下图像。

上述算法是单分支或多分支网络进行水下图像增强,能有效地进行水下图像颜色校正,但是都是单输入图像,不能同时对多个退化特征有效地进行增强。而文中针对比度低、颜色偏差和细节模糊等问题,提出基于多输入融合对抗网络的水下图像增强(Underwater Image Enhancement Base On Multi-Input Fusion Adversarial Network, MFGAN),算法主要有以下特点:(1) 以生成对抗网络为基本框架,并利用生成网络学习同一图像的不同特征增强之间的置信度图,还引入了两个纹理提取单元进行纹理特征提取,通过融合操作,获得清晰图像。此外,为提高网络的鲁棒性,构建了多损失函数。(2) 在MFGAN的残差连接中加入一层卷积层,通过对比实验证明其结构更有效地学习细节特征。(3) 构建了从水下退化图像到清晰图像的端到端映射,不依赖于任何水下成像模型和先验知识,适用性更强。通过主观和客观评价两方面表明MFGAN与其他经典及新颖算法相比,处理后的图像色彩鲜明和对比度提升。

-

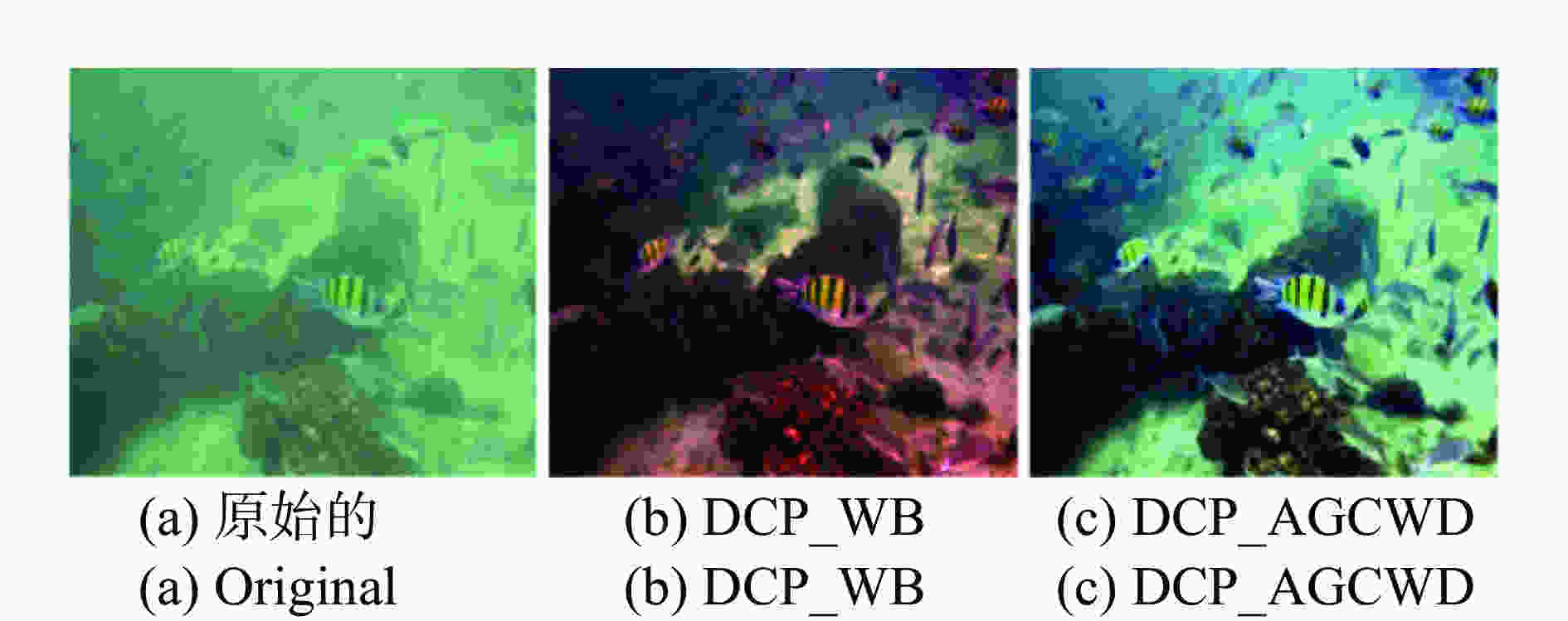

梁天全等[7]通过改进暗通道方法对水下图像进行复原,取得比较好的结果。而文中利用暗通道先验[8](Dark Channel Prior,DCP)进行预处理,初步获取色彩鲜明、对比度高的水下图像,为MFGAN提供不同特征增强的水下图像。首先利用DCP对原始图像进行去雾处理,其次对去雾后的图像分别使用白平衡算法(White Balance,WB)和基于加权分布的自适应伽马校正(Adaptive Gamma Correction With Weighted Distribution,AGCWD),获得颜色鲜明和高对比度的水下图像,上述算法过程分别简称为DCP_WB,DCP_AGCWD。DCP_WB能有效地恢复原始图像的色彩信息,如图1(b)所示。DCP_AGCWD用于水下图像的对比度提升效果良好,如图1(c)所示,图1(a)为原始图像。上述预处理只能进行单个特征增强,不能进行多个特征增强,需把预处理图像输入到MFGAN中进行训练,得到色彩鲜明而且视觉效果得到显著提升的水下图像。

-

卷积层由一系列卷积滤波器组成,在输入的特征图上执行卷积运算,每个卷积层的输出如公式(1)所示:

$${f^{l + 1}} = \operatorname{Re} {\rm{LU(}}{f^l}*{k^{l + 1}}{\rm{ + }}{b^{l + 1}}{\rm{)}}$$ (1) 式中:

$式中:{f^{l + 1}}$ 、${f^l}$ 分别代表第l层和l+1层对应的特征图;${k^{l{\rm{ + 1}}}}$ 为卷积核的大小;${b^{l{\rm{ + 1}}}}$ 为偏差,ReLU()为修正线性单元。卷积层输出的特征图大小计算如公式(2)所示:$$O{\rm{ = }}\frac{{i{\rm{ + }}2{\rm{*}}p{\rm{ + }}k}}{s}{\rm{ + }}1$$ (2) 式中:O为输出特征图的大小;i为输入特征图的大小;k为卷积核大小;p为补零填充;s为步长(图2中i=6,k=3,p=1,s=1)。从图2的Conv可以看出,卷积是特征图多对一的映射关系,通过这种映射关系可以对图像噪声进行过滤。为保持图像大小不变,在卷积操作过程中对特征图进行“补零填充”,如图2中的Conv虚线所示。Conv表示卷积,Deconv表示反卷积,通过级联卷积和激活函数,使原始低质量图像滤除噪声,进而被增强。

-

在图像检测[9]中,利用反卷积从上采样过程中获取密集的特征图,在此,MFGAN利用反卷积运算恢复卷积运算过程中丢失的细节特征。如图2中的Deconv所示,反卷积运算是一对多映射关系,与卷积运算的多对一映射相反,但是一对多映射操作使特征映射图比原特征图更大,因此需要减去特征图的边缘以保持大小一致,如图2中Deconv中的虚线所示。

-

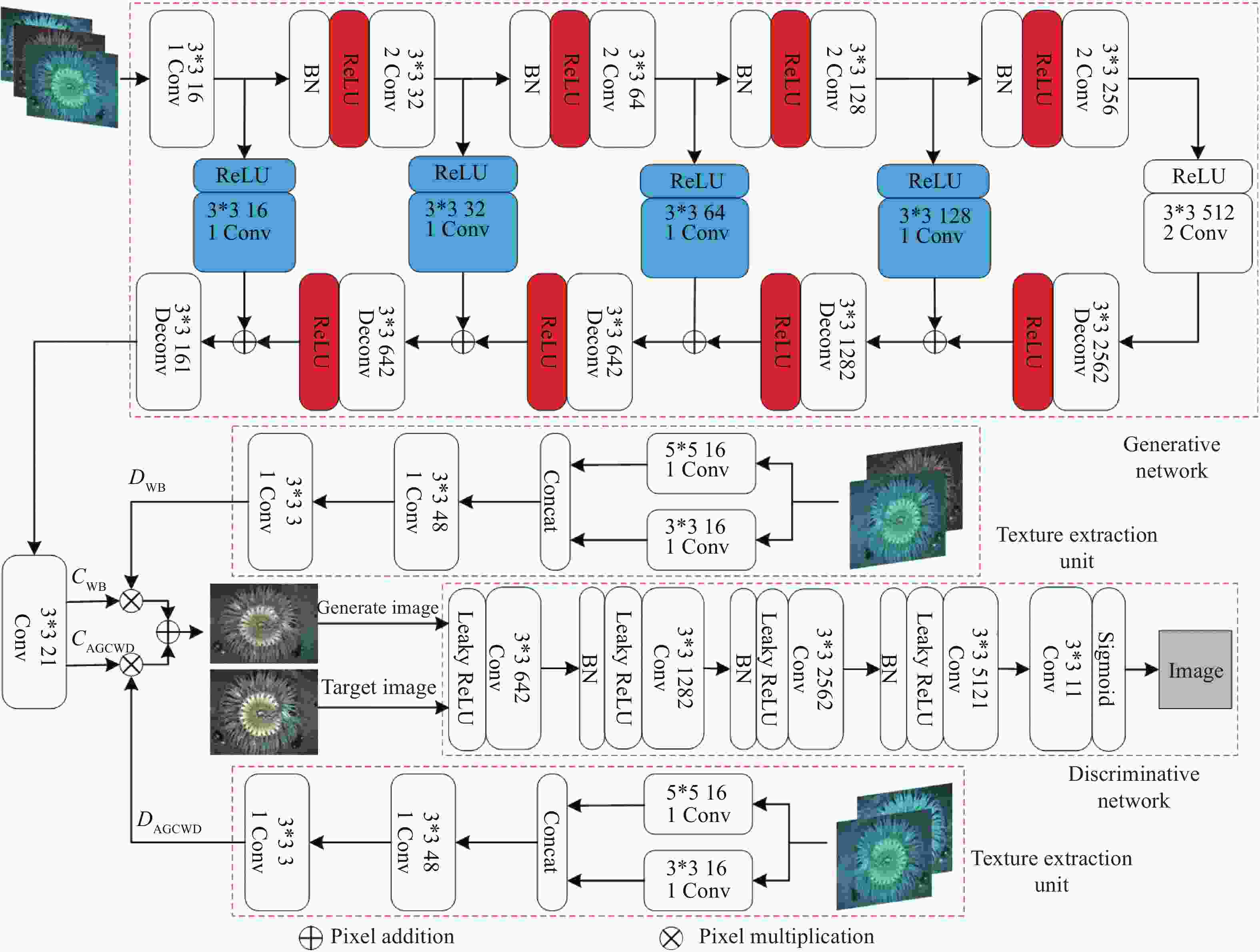

MFGAN的网络结构主要分为两部分,第一部分是生成网络,目的是学习两种增强图像与原始图像之间差异的置信度图,输出分别为CWB,CAGCWD。第二部分是判别网络,用来区分生成网络生成的图像和目标图像,驱使生成图像更接近目标图像。为减少DCP_WB和DCP_AGCWD算法引入的伪影和细节模糊,添加两个纹理提取单元进行纹理特征提取,输出分别为DWB,DAGCWD。其次生成网络输出的置信度图(CWB和CAGCWD)与纹理提取单元输出的纹理特征(DWB和DAGCWD)进行融合,获得生成图像。最后生成图像和目标图像输入到判别网络,计算两者之间的偏差,进而把偏差返回到生成网络的各个卷积层,不断更新网络参数,最终获得色彩鲜明和对比度提升的水下图像。网络结构如图3所示。

在图3中,BN(Batch Normalization)表示批量归一化,3*3、16、1分别表示卷积核大小、卷积核数量、步长。Concat表示在维度上进行连接。生成网络的输入从右到左依次是原始图、DCP_WB和DCP_AGCWD图像。从上到下,第一个纹理提取单元输入是原始图像和DCP_WB图像,第二个纹理提取单元输入是原始图像和DCP_AGCWD图像。

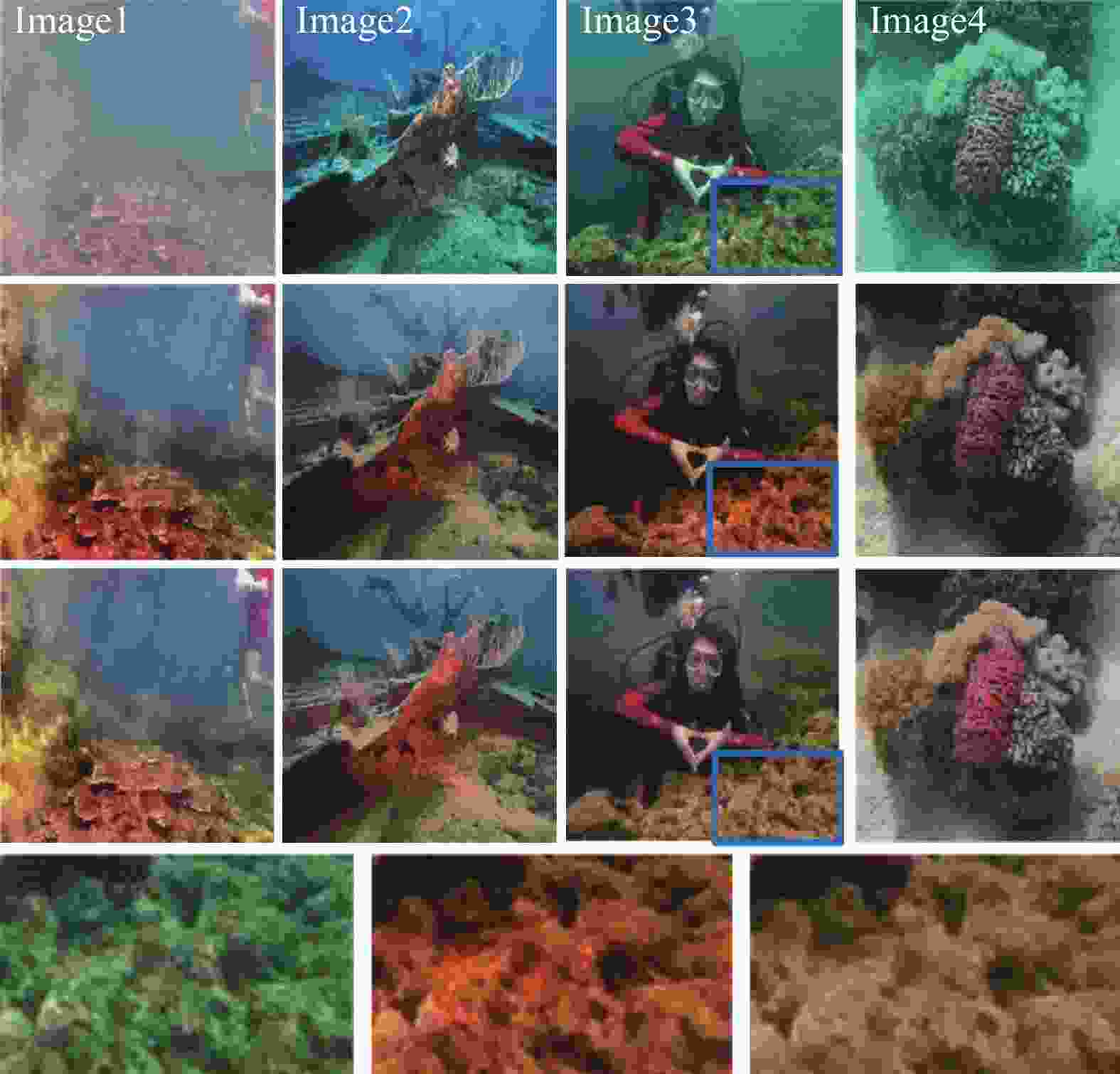

在卷积运算之前应用非线性激活函数可以使像素点更集中于某个区域,减少过拟合现象。MFGAN的生成网络中使用激活函数(ReLU)以添加非线性因子的形式来补偿线性模型,使网络在深度模型中更好地学习其映射关系。将有无ReLU函数(图3中红色标注为ReLU函数)进行对比实验。如图4所示,第一行是原始图像,第二行是无ReLU函数处理之后的图像,第三行是有ReLU函数得到的结果图,第四行为蓝色框的局部放大子图。

从图4中看出无ReLU函数得到的结果图对比度提升,但是出现红色伪影,如图4中Image3的蓝色框区域和局部放大子图。ReLU函数获得的结果图色彩鲜明和对比度提升,则ReLU函数在MFGAN中能有效地恢复水下图像更多的特征信息。

-

残差连接[10](Skip Connection)首次提出是解决梯度消失/梯度爆炸问题,提高了深度网络的速度和准确性。在MFGAN的生成网络中,引入残差连接避免低层次特征丢失,使细节纹理信息在解码过程中得到保护,因为低层次的卷积层可以捕获输入图像的细节信息,并有利于反卷积层的特征恢复。同时,它也加快网络的训练过程。

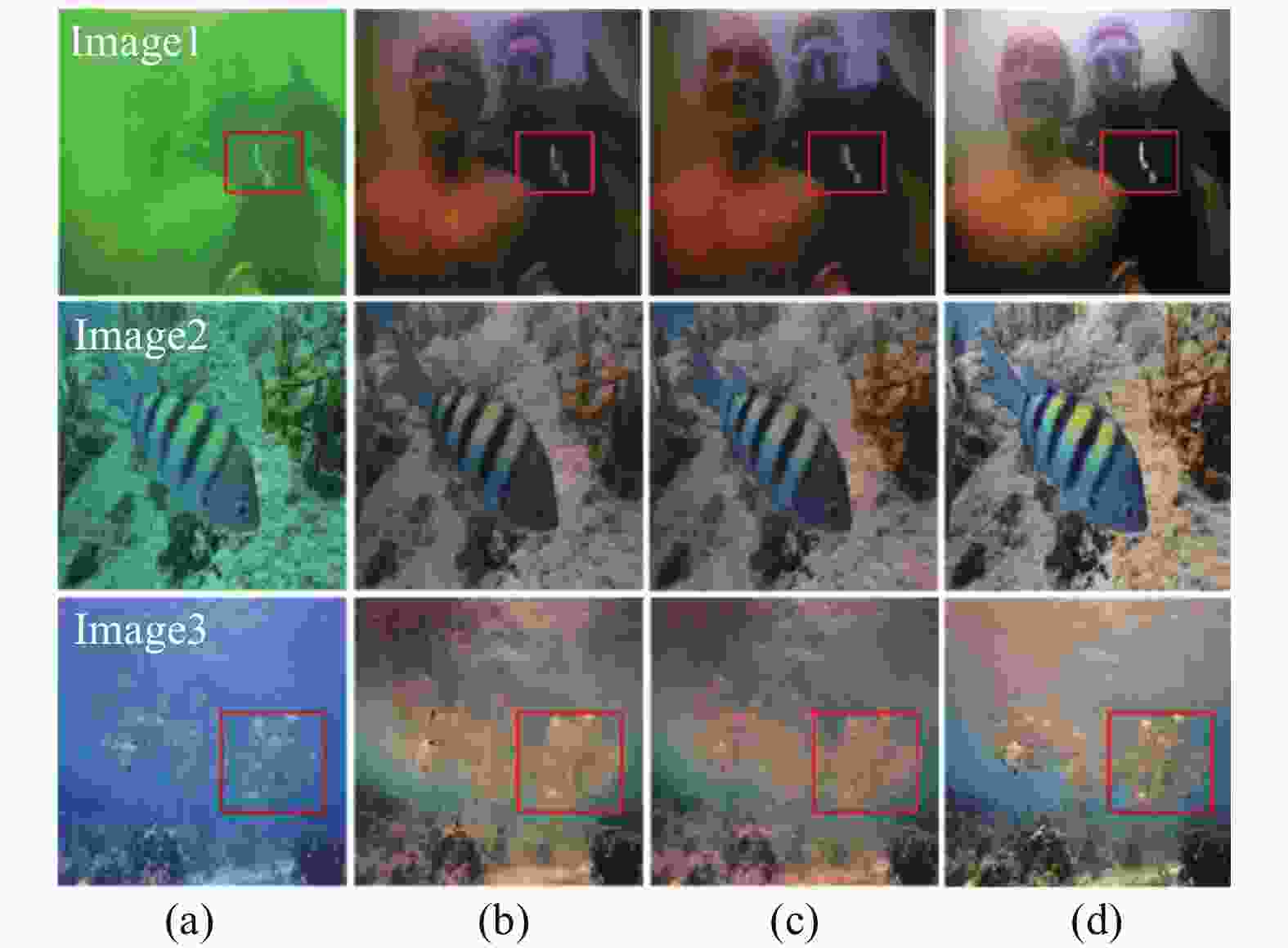

此外,为反卷积层更好地获得输入图像的细节特征,在残差连接中加入了卷积层,连接方式如图3蓝色标注区域所示。为证明其合理性,将不加入残差连接,残差连接中不使用卷积层和使用一层卷积层进行图像对比实验,如图(5)残差连接实验所示。

从图5可以看出无残差连接获得的图像对比度较低和颜色不均衡,如Image2和Image3。加入残差连接获得的图像对比度提升,但是细节特征不突出,如Iamge2。红色框所示,跳跃连接和一层卷积层获得图像的对比度提升和细节特征更加突出,且更符合视觉效果。

-

为了获得色彩鲜明,细节特征突出的图像,利用生成网络学习原始图像与DCP_WB图像,原始图像与DCP_AGCWD图像之间差异的置信度图。由图3的生成网络可见,生成网络中的卷积层和反卷积层是对称的,类似于对称的编解码器结构。卷积层能滤除噪声并保留关键的水下图像细节,但是卷积运算无法恢复低质量的图像,因此在去噪后引入反卷积层对特征进行细化,并在卷积层和反卷积层加入残差连接,使低层次特征在反卷积过程中得到保护。为减少DCP_WB和DCP_AGCWD算法引入的伪影和细节模糊,加入两个纹理提取单元进行纹理特征提取,且网络结构相同。在损失函数之前,使两个子网络的输出(DWB和DAGCWD)与生成网络输出的两个置信度图(CWB和CAGCWD)进行融合,获得细节特征突出、色彩鲜明和对比度提升的融合图像。最终融合图像如公式(3)所示:

$$I = {D_{{\rm{WB}}}} \otimes C{}_{{\rm{WB}}}{\rm{ + }}{D_{{\rm{AGCWD}}}} \otimes {C_{{\rm{AGCWD}}}}$$ (3) $式中:\otimes $ 表示相乘;+表示像素点相加;I为增强图像。 -

MFGAN的判别网络采用五个卷积层,类似于70*70的马尔科夫判别器(PatchGAN)[5]。如图3中判别网络所示,判别网络加入Leaky Relu函数,相对于ReLU函数,避免负值输入的梯度为零,进而解决部分神经元不学习的问题,更充分地学习图像特征,Leaky Relu函数如公式(4)所示:

$$ f(x) = \left\{\!\!\!{\begin{array}{*{20}{c}} x&{x \ge 0}\\ {ax}&{x < 0} \end{array}} \right. $$ (4) 式中:a为0.2。

判别网络输出是长和宽为30的图像,输入为生成网络生成的图像和目标图像,如果两者某个区域差别较小,则输出图像的对应像素点的值接近于1,反之接近于0。其优点是输出图像的每一个像素点对应于输入图像的一个局部感受野,进而判断输入图像局部感受野之间的差别,而不是整幅图像之间的差别,减少了人为干扰因素。最后一层使用Sigmoid函数,将输出每个像素点的范围映射到[0,1],有利于判别网络鉴别生成图像和目标图像在某个区域的真假,Sigmoid函数如公式(5)所示:

$$y(x) = \frac{{{e^{ - x}}}}{{{{\left( {1 + {e^{ - x}}} \right)}^2}}}$$ (5) -

对抗网络的训练过程就是交替优化生成网络和判别网络的过程,对抗网络的损失函数如公式(6)所示:

$${L_{GAN}}{\rm{ = }}E(y)[\log(D(y))] + E(x)[\log(1 - D(G(x)))]$$ (6) 式中:D为判别器;G为生成器;x为水下退化图像;y为水下目标图像;E为数学期望。在训练过程中,为防止梯度消失,对判别网络更新一次再对生成网络更新一次,如此反复进行更新,当判别网络不能鉴别生成图像和目标图像的区别时,则为动态平衡,进而获得了清晰的水下图像。

如参考文献[5]中所述,L1损失函数和对抗损失函数联合使用可以减少输出图像中的人为干扰因素,则目标图像y和生成网络生成的图像G(x)的L1损失函数如公式(7)所示:

$${L_1}{\rm{ = }}E(x,y)[||y - G(x)|{|_1}]$$ (7) 通过感知损失函数进行水下图像的特征重建,感知损失函数定义如公式(8)所示:

$${L_{VGG}} = \frac{1}{{CWH}}\sum\limits_{c = 1}^C {\sum\limits_{w = 1}^W {\sum\limits_{h = 1}^H {{\rm{||}}V(G{{(x)}^{c,w,h}})} } } - V({y^{c,w,h}}){\rm{||}}_2^2$$ (8) 式中:C、W、H分别表示图像的通道、宽度和高度;V表示经过VGG-19网络的Conv4_3层进行的非线性转换。

MFGAN使用多个损失函数进行网络的学习,有利于网络参数更快的收敛,提高网络的鲁棒性。目标函数利用对抗损失(LGAN)、感知损失(LVGG)和L1损失函数进行线性叠加。目标函数如公式(9)所示:

$$L = {\lambda _{\rm{1}}}{\rm{*}}{L_{GAN}} + {\lambda _{\rm{2}}}*{L_{VGG}}{\rm{ + }}{\lambda _{\rm{3}}}{\rm{*}}{L_{\rm{1}}}$$ (9) 式中:λ1,λ2,λ3表示常数,设置为2,5,60。

-

为验证MFGAN的鲁棒性和有效性,将MFGAN与其他典型算法(包括基于深度学习和传统算法)进行实验对比,然后从主观评价和客观评价两方面对处理图进行对比分析,最后证明MFGAN在水下图像增强方面具有很强的实用性。

-

利用水下生成对抗网络(Underwater Generative adversarial network,UGAN)[3]进行训练获得6 128张水下图像,对6 128张图像进行筛选,获得6 000张图像作为MFGAN的数据集。MFGAN中的输入是长和宽为256的RGB图像,优化器为Adam,学习率为0.000 2,批量大小(batchsize)为4,时期(epoch)为60。

-

通过颜色恢复试验来验证MFGAN算法在水下图像颜色校正方面的有效性,该实验基于无失真色卡因水下成像环境复杂而产生色偏,通过对退化的色卡图像进行处理,可有效地验证MFGAN的颜色恢复效果。将MFGAN与基于

$L\alpha \beta $ 颜色空间的水下颜色校正(LAB)、水下图像增强深度网络(Deep Underwater Image Enhancement Network, DUIENet)[11]、暗通道先验(DCP)[8]、去雾网络结合混合小波与方向滤波器组(DehazeNet and HWD)[12]进行对比,实验结果如图6所示。

图 6 颜色恢复试验 。(a) Original;(b) 标准颜色卡;(c) LAB;(d) DUIENet;(e) DCP;(f) DehazeNet and HWD;(g) MFGAN

Figure 6. Experimental of color restoration. (a) Origianl;(b) Standard color card;(c) LAB;(d) DUIENet;(e) DCP;(f) DehazeNet and HWD;(g) MFGAN

从图6中可以看出,LAB算法处理后的色卡图像整体偏暗,颜色信息不明确,而DehazeNet and HWD的对比度明显提高,但是各相同色系颜色区分度降低。DCP处理后的色卡图像颜色块不均匀,整体偏蓝,与真实的色卡颜色不符合。DUIENet的色卡图像整体偏暗和偏红色,且色卡图像中出现红色伪影。MFGAN的色卡图像色彩鲜明,不同色系颜色可清晰区分,且相近色系如蓝色与紫色等颜色对比度增强,增强的色卡图像颜色与真实色卡接近。

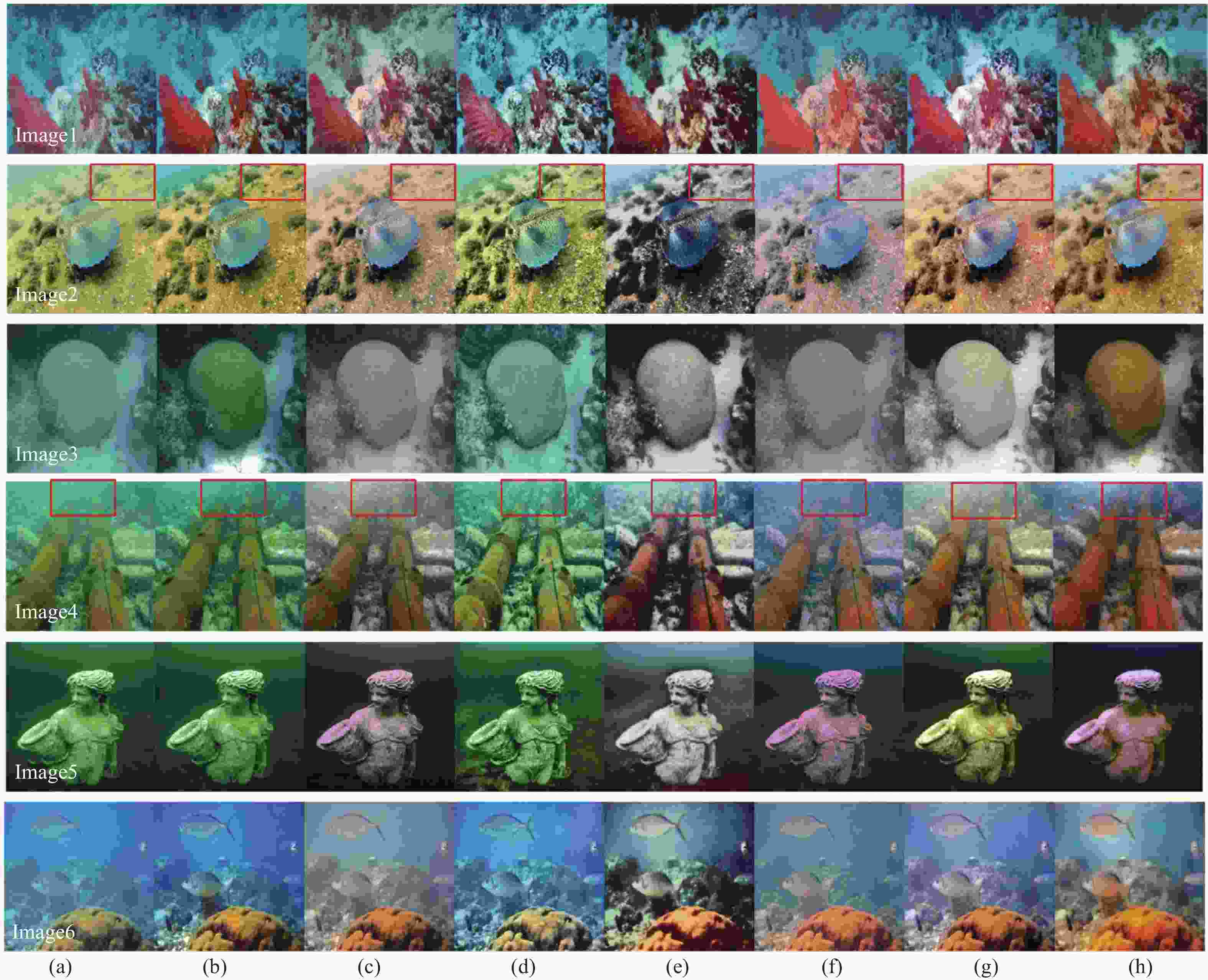

进一步验证水下图像的颜色校正和清晰度恢复效果,对6幅不同环境的水下图像进行实验。将MFGAN与传统的经典算法以及最新的深度学习方法进行分析比较,如图7所示。

图 7 实验结果图 。(a) Original;(b) DCP;(c) LAB;(d) CLAHE;(e) DehazeNet and HWD;(f) DUIENet;(g) UGAN;(h) MFGAN

Figure 7. Experimental result . (a) Original;(b) DCP;(c) LAB;(d) CLAHE;(e) DehazeNet and HWD;(f) DUIENet;(g) UGAN;(h) MFGAN

从图7可以看出,DCP算法对恢复水下退化图像清晰度方面效果很差,如Image4和Image5,由于缺少颜色校正处理,进行颜色校正基本无效。DehazeNet and HWD算法有效地解决色偏问题,但由于过度曝光及颜色补偿,导致处理后的水下图像普遍呈灰白色。在Image3中,限制对比度自适应直方图均衡化(Contrast-limited Adaptive Histogram Equalization, CLAHE)算法处理的之后整体偏绿,细节纹理特征比较清晰,DCP和UGAN算法的去雾效果良好,但是颜色恢复效果比较差,MFGAN算法在颜色校正和去雾两个方面均表现较好,比较符合视觉效果。DUIENet算法在清晰度恢复能力差,如Image4,而该算法在颜色恢复上取得不错效果,如Image5。UGAN与文中算法在提高水下图像对比度及清晰度方面均表现良好,相比之下,文中算法在颜色信息校正(如Image1)和去雾(如Image3)更具有优势。

从图7的Image4中红色框的部分可以看出,针对远景区域的图像去模糊和颜色校正的效果,MFGAN、DUIENet和UGAN对偏绿图像进行颜色校正效果更好更彻底。Image2红框部分,DCP、CLAHE和MFGAN对远距离纹理特征恢复更好。相比之下,MFGAN算法增强后的图像颜色更加自然、对比度更高和细节特征更突出。

-

为了更客观地评价和分析所提出算法的性能,进一步采用加速稳健特征[13]进行特征点匹配测试,水下彩色图像质量评价综合指标(Underwater Color Image Quality Evaluation,UCIQE)[14]和自然图像质量评价指标(Natural Image Quality Evaluator,NIQE)[15]进行质量测评。

采用加速稳健特征进行特征点匹配测试,通过对比处理前后图像的特征点匹配数目,验证算法在后续特征匹配过程中的应用效果,进而评估算法性能。一般情况下,图像清晰度越高,特征点匹配数目越多,在后续特征提取等过程中应用效果越好。DCP[8]、CLAHE、DUIENet[11]和MFGAN进行特征点匹配实验,测试效果如图8所示,每幅图的左上角为特征点匹配数,红色为最优值。在相同特征相似度阈值条件下,MFGAN相比其他算法,处理后的水下图像能匹配出更多的特征点,则MFGAN在后续特征匹配过程应用效果良好。

UCIQE代表水下图像色度、饱和度和对比度的综合指标,UCIQE值越高代表图像具有更好的视觉质量。UCIQE计算如公式(10)所示:

$$UCIQE = {c_1} \times {\sigma _c} + {c_2} \times co{n_l} + {c_3} \times {\mu _s}$$ (10) 式中:

${\sigma _c}$ 为色度的标准差;$co{n_l}$ 代表亮度的对比度;${\mu _s}$ 为饱和度的平均值;${c_1}$ ,${c_{\rm{2}}}$ ,${c_{\rm{3}}}$ 为加权系数。表1对图7的UCIQE评价指标结果,加粗字体为算法的最优值。表 1 UCIQE评价指标结果

Table 1. Quantitative results in terms of UCIQE

Image DCP LAB CLAHE DehazeNet and HWD DUIENet UGAN MFGAN 1 0.676 2 0.600 8 0.645 5 0.669 7 0.630 3 0.690 6 0.676 6 2 0.636 3 0.576 9 0.615 8 0.613 8 0.577 2 0.619 6 0.641 0 3 0.595 1 0.466 6 0.461 6 0.546 9 0.441 2 0.561 6 0.637 7 4 0.598 5 0.569 9 0.605 1 0.653 3 0.566 8 0.601 5 0.624 1 5 0.590 3 0.546 8 0.577 7 0.580 7 0.593 8 0.577 7 0.624 4 6 0.638 8 0.568 5 0.592 6 0.639 1 0.568 1 0.592 6 0.640 3 Average 0.622 5 0.554 9 0.583 1 0.617 2 0.562 9 0.607 3 0.639 9 Image1经UGAN算法处理之后,因水体颜色信息恢复不彻底,导致色度、饱和度指标较高,影响了UCIQE指标的结果。经DehazeNet and HWD算法处理后的Image4,因过度曝光使得处理后的图像色彩过于鲜明,导致其UCIQE值较高,表1数据表明,MFGAN在测试图像中整体表现出较高的UCIQE值,尤其是针对偏蓝和偏绿的图像,如Image5和Image6,相比于对比算法能更好地平衡色度、饱和度和对比度,且颜色信息恢复自然,具有较高的清晰度。

NIQE满足水下图像无参考的特点,利用待评价的图像特征模型参数与预先建立的模型参数之间的距离来确定图像质量,便可得到主观评价分数。NIQE与图像的自然性存在着负相关,值越小时,图像越接近自然状态。NIQE的计算如公式(11)所示:

$$ D({v_1},{v_2},{\Sigma _1},{\Sigma _2}) = \sqrt {({{({v_1} - {v_2})}^{\rm{T}}}{{\left(\frac{{{\Sigma _1} + {\Sigma _2}}}{2}\right)}^{ - 1}})({v_1} - {v_2}))} $$ (11) 式中:v1,v2分别表示自然图像和处理图像的均值向量;Σ1,Σ2分别表示自然图像MVG模型和处理图像MVG模型的协方差。表2为图8的NIQE评价指标结果,加粗字体为最优值。

表 2 NIQE评价指标结果

Table 2. Quantitative results in terms of NIQE

Image DCP LAB CLAHE DehazeNet and HWD DUIENet UGAN MFGAN 1 3.559 5 3.850 2 3.909 8 4.715 6 4.700 6 4.663 0 3.614 4 2 3.581 4 3.547 5 3.411 6 4.873 4 4.901 1 3.525 3 3.442 2 3 6.457 1 6.047 4 5.804 9 8.510 4 6.034 8 3.327 0 4.548 6 4 3.585 5 3.712 1 3.875 2 3.993 4 4.150 3 4.562 4 3.359 9 5 4.050 1 4.065 9 3.904 6 3.868 5 4.507 8 5.097 9 3.745 3 6 3.226 1 3.400 2 3.497 2 3.580 7 3.061 8 5.546 0 3.455 4 Average 4.076 6 4.058 9 4.067 2 4.923 6 4.559 4 4.453 6 3.727 3 Image1经DCP处理后的NIQE的值比较低,但是颜色恢复效果不明显,对水体偏蓝图像作用效果较小。经CLAHE处理后的Image2,UCIQE的值不是很高,表明色彩信息恢复不准确,对比度低,然而从图7可以看出,CLAHE处理之后的Image2更符合视觉效果,因此有较高的NIQE值。Image3经UGAN处理后,整体偏白,色彩信息恢复不自然,导致NIQE的值偏低。经DUIENet处理后的Image6,饱和度和对比度较低,具有较低的UCIQE值,但是更符合训练好的模型参数,进而获得更小的NIQE值。MFGAN在测试图像中整体表现出较低的NIQE值,相比于其他算法更接近与自然状态。

-

针对水下图像颜色失真、雾化和低对比度等问题,设计了基于多输入融合对抗网络的水下图像增强。MFGAN主要由一个生成网络和一个判别网络组成。生成网络主要负责合成水下清晰图像,判别网络的作用是不断驱动生成网络合成与参考图像在视觉上相同的图像。其次,为了网络更好学习图像的特征,利用多个子网络对同幅图像不同的增强特征进行学习,对应输出相乘相加。最后,构建了多损失函数,提高网络的鲁棒性,利用生成网络与判别网络进行相互交替训练。实验结果表明,相比于对比算法,MFGAN的UCIQE平均值为0.639 9,NIQE平均值为3.727 3,特征点匹配平均高5-10个匹配点,证明了MFGAN能恢复出更多的细节信息,适用于在不同类型的水下退化图像。在未来的工作将考虑水下成像模型与网络训练相结合,对水下退化图像进行复原。

Multi-input fusion adversarial network for underwater image enhancement

-

摘要: 针对水下图像出现对比度低、颜色偏差和细节模糊等问题,提出了多输入融合对抗网络进行水下图像增强。该方法主要特点是生成网络采用编码解码结构,通过卷积层滤除噪声,利用反卷积层恢复丢失的细节并逐像素进行细化图像。首先,对原始图像进行预处理,得到颜色校正和对比度增强两种类型图像。其次,利用生成网络学习两种增强图像与原始图像之间差异的置信度图。然后,为减少在生成网络学习过程中两种增强算法引入的伪影和细节模糊,添加了纹理提取单元对两种增强图像进行纹理特征提取,并将提取的纹理特征与对应的置信度图进行融合。最后,通过构建多个损失函数,反复训练对抗网络,得到增强的水下图像。实验结果表明,增强的水下图像色彩鲜明并且对比度提升,评价指标UCIQE均值为0.639 9,NIQE均值为3.727 3。相比于其他算法有显著优势,证明了该算法的良好效果。Abstract: For underwater image of low contrast, color deviation and blurred details and other issues, the multi-input fusion adversarial networks was proposed to enhance underwater images. The main feature of this method was that the generative network used encoding and decoding structure, filtering noise through convolution layer, recovering lost details through deconvolution layer and refining the image pixel by pixel. Firstly, the original image was preprocessed to obtain two types of images: color correction and contrast enhancement. Secondly, the confidence graph of the difference between the two enhanced images and the original image was learned by using the generated network. Then, in order to reduce artifacts and details blur introduced by the two enhancement algorithms in the process of generating network learning, the texture extraction unit was added to extract texture features from the two enhanced images, and the extracted texture features were fused with the corresponding confidence map. Finally, the enhanced underwater image was obtained by constructing multiple loss functions and training the adversarial network repeatedly. The experimental results show that the enhanced underwater image has bright color and improved contrast, the average value of UCIQE and NIQE is 0.639 9 and 3.727 3 respectively. Compared with other algorithms, the algorithm has significant advantages and proves its good effect.

-

表 1 UCIQE评价指标结果

Table 1. Quantitative results in terms of UCIQE

Image DCP LAB CLAHE DehazeNet and HWD DUIENet UGAN MFGAN 1 0.676 2 0.600 8 0.645 5 0.669 7 0.630 3 0.690 6 0.676 6 2 0.636 3 0.576 9 0.615 8 0.613 8 0.577 2 0.619 6 0.641 0 3 0.595 1 0.466 6 0.461 6 0.546 9 0.441 2 0.561 6 0.637 7 4 0.598 5 0.569 9 0.605 1 0.653 3 0.566 8 0.601 5 0.624 1 5 0.590 3 0.546 8 0.577 7 0.580 7 0.593 8 0.577 7 0.624 4 6 0.638 8 0.568 5 0.592 6 0.639 1 0.568 1 0.592 6 0.640 3 Average 0.622 5 0.554 9 0.583 1 0.617 2 0.562 9 0.607 3 0.639 9 表 2 NIQE评价指标结果

Table 2. Quantitative results in terms of NIQE

Image DCP LAB CLAHE DehazeNet and HWD DUIENet UGAN MFGAN 1 3.559 5 3.850 2 3.909 8 4.715 6 4.700 6 4.663 0 3.614 4 2 3.581 4 3.547 5 3.411 6 4.873 4 4.901 1 3.525 3 3.442 2 3 6.457 1 6.047 4 5.804 9 8.510 4 6.034 8 3.327 0 4.548 6 4 3.585 5 3.712 1 3.875 2 3.993 4 4.150 3 4.562 4 3.359 9 5 4.050 1 4.065 9 3.904 6 3.868 5 4.507 8 5.097 9 3.745 3 6 3.226 1 3.400 2 3.497 2 3.580 7 3.061 8 5.546 0 3.455 4 Average 4.076 6 4.058 9 4.067 2 4.923 6 4.559 4 4.453 6 3.727 3 -

[1] Hu Haofeng, Li Xiaobo, Liu Tiegen. The latest development of underwater image restoration technology based on polarization imaging [J]. Infrared and Laser Engineering, 2019, 48(6): 0603006. (in Chinese) [2] Chen Qingjiang, Zhang Xue. Application of hybrid residual learning and guided filtering algorithm in image defogging [J]. Optical Precision Engineering, 2019, 27(12): 2702−2712. (in Chinese) [3] Cameron Fabbri, Md Jahidul Islam, Junaed Sattar. Enhancing underwater imagery using generative adversarial networks[C]//IEEE International Conference on Robotics and Automation(ICRA), 2018: 7159-7165. [4] Guo Yecai, Li Hanyu, Zhuang Peixian. Under-water image enhancement using a multiscale dense generative adversarial network [J]. IEEE Journal of Oceanic Engineering, 2019−2911447. [5] Li Chuan, Michael Wand. Precomputed real-time texture synthesis with markovian generative adversarial networks[C]//European Conference on Computer Vision Springer, 2016: 702-716. [6] Ye Xinchen, Xu Hongcan, Ji Ming, et al. Underwater image enhancement using stacked generative adversarial networks[C]//Pacific Rim Conference on Multimedia, 2018: 514-524. [7] Liang Tianquan, Zhang Xiaoyun, Duan Peng, et al. Target detection of underwater strong scattering medium by improved dark channel method [J]. Infrared and Laser Engineering, 2020, 49(2): 0203012. (in Chinese) [8] He Kaiming, Sun Jian, Fellow, et al. Single image haze removal using dark channel prior [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 33(12): 2341−2353. [9] Wang Chunzhe, An Junshe, Jiang Xiujie, et al. Candidate region optimization algorithm based on convolutional neural network [J]. Chinese Optics, 2019, 12(6): 1348−1361. (in Chinese) [10] Long Jonathan, Shelhamer Evan, Darrell Trevor. Fully convolutional networks for semantic segmentation[C]// IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2015, 3434-3440. [11] Li Chongyi, Guo Chunle Wenqi Ren, et al. An underwater image enhancement benchmark dataset and beyond [J]. IEEE Transactions on Image Processing, 2020, 29: 4376−4389. doi: 10.1109/TIP.2019.2955241 [12] Pan Panwang, Fei Yuan, Cheng En. Underwater image de-scattering and enhancing using dehazenet and hwd [J]. Journal of Marine Science and Technology, 2018, 26(4): 531−540. [13] Miao Yang, Sowmya Arcot. An underwater color image quality evaluation metric [J]. IEEE Transactions on Image Processing, 2015, 24(12): 6062−6071. doi: 10.1109/TIP.2015.2491020 [14] Mittal Anish, Rajiv Soundararajan, Alan C Bovik, et al. Making a "completely blind" image quality analyzer [J]. IEEE Signal Processing Letters, 2013, 20(3): 209−212. doi: 10.1109/LSP.2012.2227726 [15] Dai Chenggang, Lin Mingxing, Wang Zhen, et al. Color compensation based on bright channel and fusion for underwater image enhancement [J]. Acta Optica Sinica, 2018, 38:1110003. (in Chinese) -

下载:

下载: