-

红外图像是红外探测器通过测量物体表面的红外辐射并进一步转换后生成的图像,其在分辨率、对比度等方面不如可见光图像,其受天气条件制约较少;可见光图像具有分辨率高、对比度好等优势,但是其受到天气条件等因素影响,不能够全天候进行工作,因此若将红外图像与可见光图像的互补信息进行有效融合,可以形成更加适合人类视觉认知系统的新图像[1-3]。融合后生成的新图像鲁棒性强,具有更加丰富的细节信息,可以被广泛的应用于光电侦察、光电告警、多传感器信息融合等光电信息领域[4-5]。

传统的多尺度融合方法如非下采样剪切波变换(Non-subsampled Shearlet Transform,NSST)性能表现良好,从而被广泛的应用到图像融合领域之中,但一般融合方式的图像特征器需要手动设计,运算效率较低,所提取的图像特征固定、单一,并不能很好的应用于各类复杂的图像环境,影响融合图像的质量[6-10]。近年来,随着深度学习理论的发展,深度学习因其强大的特征学习能力在图像融合领域中取得了优异的成果[11-12]。Yang等提出了基于卷积神经网络(Convolutional Neural Network,CNN)的图像融合方法,使融合图像特征更为清晰,提升了融合图像质量[13]。An等提出基于监督卷积神经网络的红外与可见光图像融合算法,该方法能较好地保留红外图像的目标特征[14]。传统的深度学习图像融合算法,在的训练过程中并没有对图像进行高低频的划分,影响了融合图像的视觉效果。而通过深度学习结合多尺度算法可以更好的提取源图像的低频信息,有效保留源图像的高频信息,从而进一步提升融合图像质量。

综上,文中首次提出了基于卷积神经网络与NSST相结合的红外与可见光图像融合方法。首先,将具有目标、背景二分功能的卷积神经网络模型训练成功,并将红外图像输入训练好的模型之中,区分红外图像的目标与背景;其次,结合调频(Frequency-tuned,FT)显著性检测算法进行目标特征提取,得到目标显著图;最后,利用NSST结合目标显著图,得到红外与可见光融合图像。实验结果表明,相比于传统多尺度图像融合方法,文中方法在融合效果的主客观评价上均有明显提高,融合图像更加清晰,细节更加丰富,更有利于观察者识别。

-

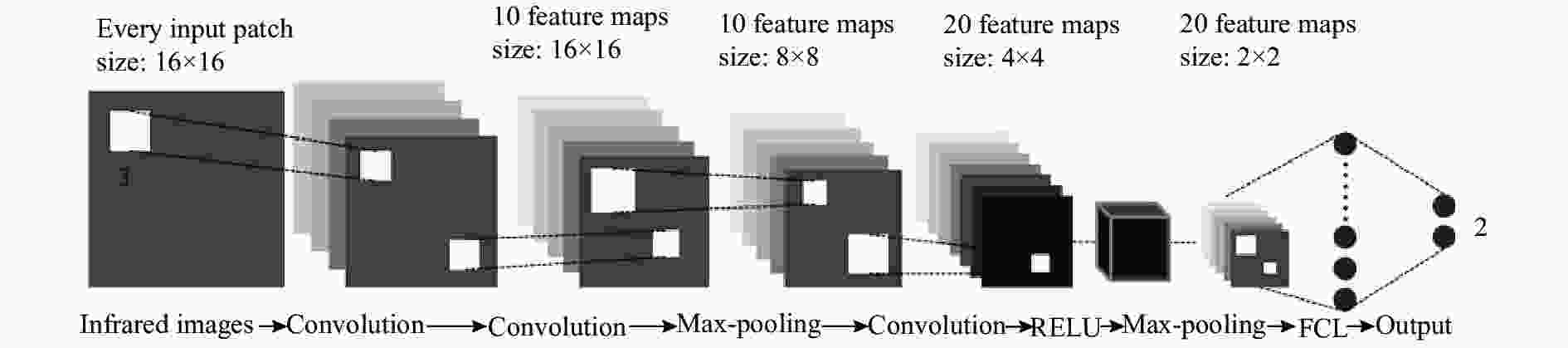

红外图像是红外探测器通过测量目标热辐射获得的。通常情况下,目标区域的温度较高,所发出的辐射强度会远大于背景区域。这使得目标区域更容易被人眼观察。因此,目标区域可被视为人类视觉系统中的显著性区域。文中通过卷积神经网络结构提取出目标显著图,其模型如图1所示。

文中使用的卷积神经网络是在Liu[15]等提出的基础上,增添了一个卷积层和一个最大池化层,进一步实现对红外目标图像特征的进一步提取。其构建与训练过程如下:首先,将红外图像(256×256 pixel)分为大小16×16的子块,并且以步长为16的滑动窗口遍历整个图像;然后,采用3×3的卷积核对其进行卷积操作,步长设置为1,经历两个卷积层后,每个子块拥有10个特征图,大小为16×16;接下来,插入最大池化层,压缩模型中的数据,卷积核尺寸和步长分别为2×2和2,子块中特征图的大小为8×8;再经过一个卷积核大小2×2且步长为2的卷积,获得20个大小为4×4的特征图;下一步,让数据通过非线性激活层和池化层,并将子块的特征图的大小变为2×2,进一步降低了数据的空间尺寸;最后,将获得的数据与二维输出向量进行全连接,再经过softmax分类器,使输出数据的处于(0,1)之间。选择较小的数据作为判断准则,概率越接近0,则说明来源于红外目标区域的可能性则越大。通过上述过程,实现对原始红外图像中目标显著性的预测。

从TNO_Image_Fusion_Datase[16]数据集随机抽取200幅红外图像,再对图像进行平移、旋转等尺度变换,扩增到2 000幅图像。将每幅图像进行切割,分成16×16大小的子块,并将子块按红外辐射强弱分为红外目标区域图像集和背景图像集。将目标区域图像集设置为1,背景区域图像集设置为0,训练集与测试集图像数量比设置为9∶1。

文中在Pytorch框架上建立模型,将交叉熵函数作为模型损失函数,返回损失和平均值,使用optimzier优化器,采用随机梯度下降方式降低损失函数。模型中学习率设置为1×10−6,进行500次迭代,训练过程中,卷积神经网络训练的损失函数如图2所示。

从图2可以看出,随着迭代次数的增加,卷积神经网络的损失函数(交叉熵)逐渐下降,而损失函数越小,说明该分类器在真实标签上的分类概率越大,模型性能也就越好。当模型测试时,大小16×16且步长为1的滑动窗口遍历输入的红外图像,以便更加准确的寻找红外目标区域位置,进而精确提取目标显著图。

-

将红外图像输入训练成功的模型可以准确定位红外目标区域,但此时红外目标区域存在其他干扰因素。为了有效减少与目标显著图无关的弱红外背景区域,文中采用卷积神经网络与FT相结合的方式,其主要是通过训练模型定位红外目标区域,再通过FT算法提取源图像目标显著性,二者结合区域作为目标显著性区域,进一步获得目标显著图。采用手动PS方法得到标准分割图,比较二者之间差异,以全分辨率方法(简称AC)、频域残差法(Spectral Residual,SR)、局部对比度法(Local Contrast,LC)、FT算法为对照方法,进一步验证卷积神经网络与FT相结合方法的有效性。

为了验证融合的有效性,从数据集[16]选取两组配准完成的红外与可见光图像(像素大小为256×256)在maltlab17软件进行多次仿真实验。图3为红外图像“UN Camp”的目标显著性提取实验,图4为红外图像“dune”的目标显著性提取实验。

图 3 红外图像“UN Camp”及多种方法显著性提取后图像。 (a) 红外图像“UN Camp”;(b) 图像“UN Camp”标准分割图;(c) AC方法;(d) SR方法;(e) LC方法;(f) FT方法;(g) CNN方法;(h) CNN+FT方法

Figure 3. Infrared image ''UN Camp''and images after saliency extraction by various methods. (a) Infrared image "UN Camp"; (b) Standard segmentation of image "UN Camp"; (c) AC method; (d) SR method; (e) LC method; (f) FT method; (g) CNN method; (h) CNN+FT method

图 4 红外图像“dune”及多种方法显著性提取后图像。 (a) 红外图像“dune”;(b) 图像“dune”标准分割图;(c) AC方法(d) SR方法;(e) LC方法;(f) FT方法;(g) CNN方法;(h) CNN+FT方法

Figure 4. Infrared image ''dune'' and images after saliency extraction by various methods. (a) Infrared image "dune"; (b) Standard segmentation of image "dune"; (c) AC method; (d) SR method; (e) LC method; (f) FT method; (g) CNN method; (h) CNN+FT method

从图3、图4中可以看出,AC、LC与FT方法可以提取目标,但混杂了大量的区域背景;SR方法所提取的目标较为模糊;单独CNN方法提取的目标显著图与标准分割图较为相似,但目标区域较大;CNN结合FT方法提取的目标显著图明显与标准分割图更为接近。

为了尽一步评价目标显著性的准确性,以平均绝对误差(Mean Absolute Error,MAE)作为目标显著性客观评价指标,并进行多组次实验,求取平均值。MAE主要反映被提取目标图与理想标准分割图之间的平均绝对误差,其公式如下:

$${\rm{MAE}} = \frac{1}{{m×n}}\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {} } \left| {{{\hat y}_{ij}} - {y_{ij}}} \right|$$ (1) 式中:

$m×n$ 为分割图像的大小;$\hat y_{ij}^{}$ 是标准分割图在位置$\left( {i,j} \right)$ 的像素值;${y_{ij}}$ 是目标显著图在位置$\left( {i,j} \right)$ 的像素值。上述6种方法提取的目标显著图与标准分割图之间的MAE值如表1所示。

表 1 目标显著性提取评价指标MAE

Table 1. Target significance extraction evaluation index MAE

Method AC SR LC FT CNN CNN+FT MAE1 15.64 1.00 8.59 9.34 0.50 0.27 MAE2 8.45 0.55 2.91 2.91 0.63 0.35 表1中,MAE1为红外图像“UN Camp”目标显著性评价指标,MAE2为红外图像“dune”目标显著性评价指标。从MAE1和MAE2值中可以看出CNN结合FT方法与标准分割图之间误差最小,客观验证了CNN结合FT方法提取目标显著性的优越性。

-

图5为所提出的融合算法模型图。首先,由CNN和FT算法获取红外图像的显著性目标提取图;其次,分别对红外图像和可见光图像进行NSST变换,将其分解成低频子带系数和多个高频子带系数,并针对低频子带融合,使用目标显著性与和自适应模糊逻辑相结合的方法,针对高频子带融合,采用高频子带系数局部方差对比度方法;最后,通过NSST逆变换得到融合后的图像。

-

NSST变换将红外与可见光图像分解成低频子带系数和多个高频子带系数。基于源图像的低频子带融合,采用自适应模糊逻辑和目标显著图相结合的融合规则,通过目标显著图提取低频红外图像的目标和背景,采用自适应模糊逻辑算法实现低频部分融合。

针对图像低频子带的融合,文中首次采用目标显著图和模糊逻辑相结合的方法。通过目标显著图,生成模板图

$mask$ 。如果红外图像的区域是目标显著性区域,则$mask\left( {i,j} \right) = 1$ ;反之,$mask\left( {i,j} \right) = 0$ 。然后,采用模糊逻辑中高斯隶属度函数进行加权平均,实现低频子带的融合,其数学式如下:$${\eta _{\rm{1}}} = \left\{ \begin{array}{l} \exp \left\{ { - \dfrac{{{{\left[ {C_L^{VIS}\left( {i,j} \right) - \mu _L^{vis}} \right]}^2}}}{{2{{\left( {k\sigma _L^{vis}} \right)}^2}}}} \right\} \\ 0,mask\left( {i,j} \right) = 1 \\ \end{array} \right.,mask\left( {i,j} \right) = 0$$ (2) $${\eta _{\rm{2}}} = {\rm{1 - }}{\eta _{\rm{1}}}$$ (3) $$_{}C_L^{}\left( {i,j} \right) = {\eta _{\rm{1}}}C_L^{IR}\left( {i,j} \right) + {\eta _{\rm{2}}}C_L^{VIS}\left( {i,j} \right)$$ (4) 式中:

$C_L^{VIS}\left( {i,j} \right)$ 、$C_L^{IR}\left( {i,j} \right)$ ,${C_L}\left( {i,j} \right)$ 依次为可见光、红外图像、融合图像低频子带像素的大小;${\eta _{\rm{1}}}$ ,${\eta _{\rm{2}}}$ 为可见光像素$\left( {i,j} \right)$ 位置的背景隶属度和目标隶属度;$\mu _L^{vis}$ ,$\sigma _L^{vis}$ 分别为可见光图像低频子带图像像素的均值和方差;$k$ 为高斯函数调整参数。高斯函数调整参数对低频图像融合有着至关重要的影响。传统的随机取值使融合效果并不理想,因此针对参数选取,提出了一种自适应模糊逻辑算法来确定

$k$ 值,其具体步骤如下:(1)设定某一区域(目标或背景)红外图像像素的权重

${\eta _{\rm{0}}}\left( {{\rm{0}} \leqslant {\eta _{\rm{0}}} \leqslant {\rm{1}}} \right)$ ;(2)设定

$k$ =0.1,以0.1步长逐渐增大,当$k$ =2时停止。计算不同$k$ 值的红外图像像素的权重${\eta _k}$ ,并求取${\eta _k}$ 与${\eta _{\rm{0}}}$ 差值的绝对值$\left| {{\eta _k} - {\eta _0}} \right|$ ;(3)找出

$\min \left| {{\eta _k} - {\eta _0}} \right|$ 所对应的高斯函数调整参数${k_0}$ 值,并计算对应的交叉熵$C{E_0}$ ;(4)计算不同

$k$ 值时红外图像的交叉熵,找出最小交叉熵$C{E_{\min }}$ 所对应的高斯函数调整参数${k_1}$ 值;(5)计算

$C{E_0}$ 与$C{E_{\min }}$ 差值的绝对值$\left| {C{E_0} - C{E_{\min }}} \right|$ ,判断$\left| {C{E_0} - C{E_{\min }}} \right| \le \delta $ 是否成立。若判断结果成立,${k_1}$ 值即为所确定的高斯函数调整参数;如果判断结果不成立,比较${k_0}$ 与${k_1}$ 的大小,若${k_0} \leqslant {k_1}$ ,适量增加$\eta {}_{\rm{0}}$ 值,若${k_0} \geqslant {k_1}$ 适量减小${\eta _{\rm{0}}}$ 值,返回第1步,直到交叉熵差值符合要求。对于图像高频子带融合采用局部方差对比度的融合规则。在高频子带融合过程中,由于红外图像与可见光图像在灰度值上的差别影响,直接赋值的融合方式,会产生块效应及过渡不平滑,因此,我们对高频像素进行边滤波处理,从而保持图像的边缘。

公式(5)和公式(6)分别为局部均值和局部方差计算公式,如下:

$$u_H^{ir} = \dfrac{{ \displaystyle\sum\limits_{m = 1}^M {\sum\limits_{n = 1}^N {C_H^{IR}\left( {i,j} \right)} } }}{{M \times N}}$$ (5) $$\delta _H^{ir}\left( {i,j} \right) = \frac{1}{{M \times N}}{\sum\limits_{m = 1}^M {\sum\limits_{n = 1}^N {\left[ {C_H^{IR}(i + m,j + n) - u_H^{ir}(i,j)} \right]} }}^2$$ (6) 式中:

$C_H^{IR}\left( {i,j} \right)$ 、$u_H^{ir}\left( {i,j} \right)$ ,$\delta _H^{vis}\left( {i,j} \right)$ 分别表示红外图像高频子带的边缘滤波后像素、局部均值和局部方差。文中所选的窗口M×N的大小为3×3。同理,可见光图像高频子带的局部方差

$\delta _H^{vis}\left( {i,j} \right)$ 也如上述方法求得。针对红外高频图像和可见光高频图像上每个像素,求解其局部方差对比度,公式(7)为局部方差对比度计算公式:

$$R\left( {i,j} \right) = \dfrac{{\delta _H^{ir}\left( {i,j} \right)}}{{\delta _H^{vis}(i,j)}}$$ (7) 式中:

$R\left( {i,j} \right)$ 表示局部方差对比度,若$R\left( {i,j} \right) \geqslant 1$ 表明红外图像特性对比度高;反之,则表明可见光图像特性对比度高。而文中通过选择图像特性对比度高的像素来确定高频子带系数的大小,进而实现图像高频子带融合,公式(8)为高频子带系数的大小计算公式:$$C_H^{}\left( {i,j} \right) = \left\{ \begin{gathered} C_H^{IR}\left( {i,j} \right),R\left( {i,j} \right) \geqslant 1 \\ C_H^{VIS}\left( {i,j} \right),R\left( {i,j} \right) < 1 \\ \end{gathered} \right.$$ (8) 式中:

$C_H^{IR}\left( {i,j} \right)$ 、$C_H^{VIS}\left( {i,j} \right)$ 、${C_H}\left( {i,j} \right)$ 依次为红外图像、可见光图像以及融合图像分别在同层、同方向的高频子带系数大小。最后,通过NSST逆变换重构,生成新的融合图像。

-

为了验证文中算法的有效性,选取三组红外与可见光图像进行仿真实验。其中,两组为公共数据集[16]中红外与可见光图像(像素大小为256×256);另一组是通过可见光相机和中波热像仪(波段3~5μm,分辨率320×256)拍摄,再经过去噪、校准等预处理获得的红外与可见光图像。同时,与离散小波变换(DWT)、压缩感知(CS)、二维经验模态分解(BEMD)、非下采样轮廓波变换结合模糊逻辑(NSCT+FL)等融合方法进行比较。其中,DWT方法中,DWT采用单层“bior3.7”小波,分解成3层,采用加权平均方法融合;BEMD方法中,BEMD将源图像分解成合适的本征模态函数和残余分量;NSCT结合模糊逻辑方法中,NSCT变换采用“maxflat”滤波器、“dmaxflat7”滤波器。最后,从主客观双重角度评价文中所提出的算法。

第一组实验图像采用“UN Camp”红外与可见光图像进行融合,图像以及融合结果如图6所示。图6(a)、(b)分别为红外图像和可见光图像。由图6(c)可知,融合图像的背景部分不明显,不符合人眼视觉;从图(d)、(e)可知,融合图像存在虚影模糊,融合效果不够理想;从图(f)可知,基于NSCT的融合图像更平滑,但背景信息较模糊;通过图(g)可知,传统的NSST域内结合模糊逻辑的融合方法背景细节丰富,但目标特征不够突出;通过图(h)可知,融合图像边缘信息更丰富,人物更加清晰,对比度更高,视觉效果更好。

图 6 “UN Camp”红外和可见光图像以及融合结果。(a) 红外图像;(b) 可见光图像;(c) DWT方法;(d) CS方法;(e) BEMD方法;(f) NSCT+FL方法;(g) NSST+FL方法;(h) 文中方法;(i) 显著区域融合图像

Figure 6. ''UN Camp'' infrared and visible images and fusion results. (a) Infrared image; (b) Visible image; (c) DWT method; (d) CS method; (e) BEMD method; (f) NSCT+FL method; (g) NSST+FL method; (h) Proposed method; (i) Significant area fusion image

第二组实验图像采用“dune”红外和可见光图像进行融合,图像以及融合结果如图7所示。在图7中,由视觉观察得出,图(c)融合结果对比度相对较低;图(d)、图(e)中图像存在着“朦胧感”视觉效果相对较差;图(f)、图(g)没有明显的突出目标特征;而图(h)中目标区域人物明亮可见,背景细节保留较好,更有利于后续的处理。

图 7 “dune”红外和可见光图像以及融合结果。(a) 红外图像;(b) 可见光图像;(c) DWT方法;(d) CS方法;(e) BEMD方法;(f) NSCT+FL方法;(g) NSST+FL方法;(h) 文中方法;(i) 显著区域融合图像

Figure 7. ''dune'' infrared and visible images and fusion results. (a) Infrared image; (b) Visible image; (c) DWT method; (d) CS method; (e) BEMD method; (f) NSCT+FL method; (g) NSST+FL method; (h) Proposed method; (i) Significant area fusion image

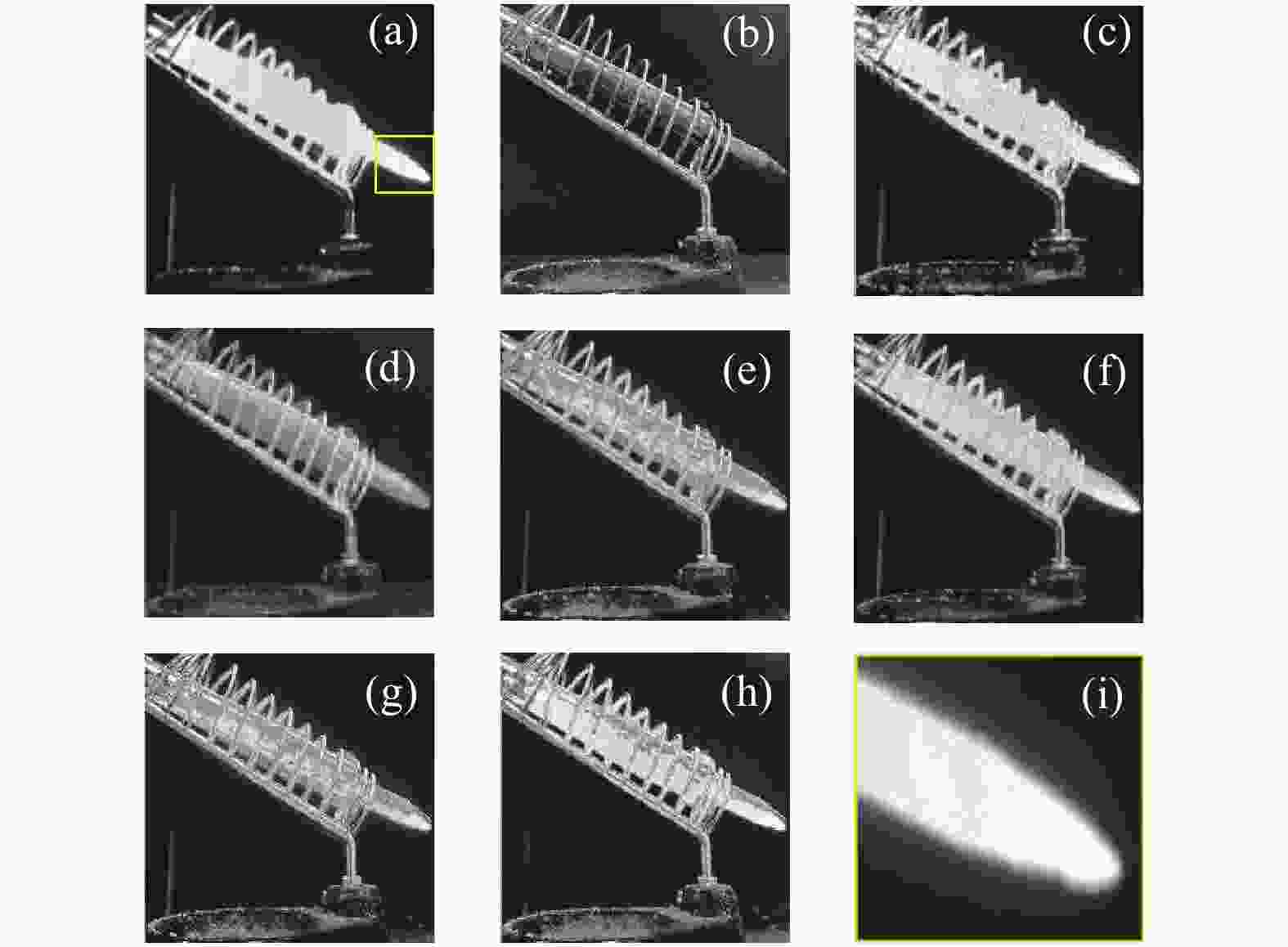

第三组实验图像采用“iron”红外和可见光图像进行融合,图像以及融合结果如图8所示。在图8中,图(a)、(b)分别为红外图像和可见光图像,其中图(a)中黄色框范围是红外图像的视觉显著性区域。图(c)中的电烙铁的目标轮廓基本消失;图(d)、图(e)并没有突出电烙铁的高温特征;图(f)并没有体现出电络铁的温度层次;图(g)中,电烙铁的高温虽然得到了体现,但尖端部分的高温信息并不明显;而图(h)中电烙铁各处温度差异都得到了一定的反映,特别是尖端的高温图像的特征信息被保留,同时尾部的低温以及底座的常温均被良好地体现出来,温度层次较为明显,有利于人眼识别。图(i)为红外显著区域融合图像的局部放大图,突出了电烙铁尖端的高温。

图 8 “iron”红外和可见光图像以及融合结果。(a) 红外图像;(b) 可见光图像;(c) DWT方法;(d) CS方法;(e) BEMD方法;(f) NSCT+FL方法;(g) NSST+FL方法;(h) 文中方法;(i) 显著区域融合图像

Figure 8. ''iron'' infrared and visible images and fusion results. (a) Infrared image; (b)Visible image; (c) DWT method; (d) CS method; (e) BEMD method; (f) NSCT+FL method; (g) NSST+FL method; (h) Proposed method; (i) Significant area fusion image

为了客观评价图像融合的质量,进一步选取信息熵(E)、平均梯度(AG)、空间频率(SF)、像素交叉熵(CE)、像素互信息(MI)五种客观评价指标对图像融合效果进行评价。文中通过多组次(3组)实验获得实验结果,并求取平均值,进而验证文中方法的有效性,表2为红外与可见光图像融合效果评价。

表 2 红外与可见光图像融合效果评价

Table 2. Infrared and visible image fusion effect evaluation

Image Method E AG SF MI CE UN DWT 6.934 2 7.049 2 13.921 7 2.668 3 0.356 3 Camp CS 6.252 7 4.965 9 10.300 5 1.593 3 0.599 9 BEMD 6.603 8 6.146 2 12.007 7 1.573 8 0.575 9 NSCT+FL 6.810 5 7.110 9 14.126 5 2.432 8 0.326 4 NSST+FL 6.855 5 7.051 6 14.475 8 2.355 0 0.279 8 Proposed method 7.116 3 8.008 2 16.106 9 2.991 9 0.264 8 Dune DWT 6.657 4 6.507 5 12.371 8 2.594 3 0.307 2 CS 5.903 8 4.694 8 9.790 9 1.188 4 0.654 5 BEMD 6.156 6 5.426 7 10.391 4 1.196 5 0.576 0 NSCT+FL 6.675 8 6.578 3 15.540 9 2.222 0 0.292 5 NSST+FL 6.666 7 7.365 3 13.954 2 2.637 0 0.301 4 Proposed method 6.701 1 7.386 8 14.153 9 2.815 7 0.289 2 Iron DWT 6.677 8 12.647 6 33.730 4 3.617 3 0.550 3 CS 6.537 2 7.647 5 20.025 4 3.177 3 0.498 7 BEMD 6.677 7 9.090 6 23.349 1 3.392 5 0.539 7 NSCT+FL 6.767 7 14.998 1 38.969 7 3.397 5 0.474 5 NSST+FL 6.751 1 15.645 4 40.410 4 3.177 4 0.427 9 Proposed method 6.768 7 16.282 2 41.718 8 3.701 3 0.409 3 由表2可以看出,文中方法在3组实验的表现上均好于其他对比算法。对于“UN camp”融合图像,图像质量评价指标中的信息熵、平均梯度、空间频率、互信息、交叉熵分别提高了2.62%、12.6%、11.3%、12.1%、5.66%;对于“dune”红外与可见光融合图像,其信息熵、平均梯度、空间频率、互信息、交叉熵分别提高了0.38%、0.30%、1.43%、6.78%、1.14%;对于“iron”红外与可见光融合图像,其信息熵、平均梯度、空间频率、互信息、交叉熵分别提高了0.01%、4.07%、3.24%、2.32%、4.54%。综合5个评价指标,文中方法在客观评价结果中具有最多的最优值,客观上验证了CNN与NSST相结合方法的优越性。

综上,运用CNN与FT相结合方法可以很好获取红外图像目标显著性特征,表现出强大的目标区域筛选能力,提升了目标、背景分离准确性。使用NSST、自适应模糊逻辑结合目标显著图解决了图像融合过程中低频背景、目标界限不清晰问题,更好的表达了源图像特征;利用高频子带系数局部方差对比度方法将图像高频部分融合,改善了融合图像细节信息难以保留的问题,提高了图像的清晰度,更有利于人眼识别。

-

提出了一种新型的卷积神经网络结合NSST的红外与可见光图像融合方法。文中首次利用卷积神经网络和调频显著性相结合方法获取红外图像目标显著图,该方法相比于AC、SR、LC、FT、CNN方法明显降低了与标准分割图之间的平均绝对误差,提高了目标提取准确性;同时,首次使用自适应的模糊逻辑方法结合目标显著图的方式进行低频图像融合,突出了源图像的特征。实验结果表明,相比于传统算法,文中方法可以更好的提取源图像的特征信息,提高了融合图像对比度,图像更加清晰,更有利于人眼观察,同时,融合图像在信息熵、平均梯度、空间频率、互信息、交叉熵等多个客观评价指标上至少分别提高了0.01%、0.30%、1.43%、2.32%、1.14%。该方法可以很好的应用于光电侦察告警、红外搜索与跟踪、多传感器信息融合等光电信息领域。

Infrared and visible image fusion of convolutional neural network and NSST

-

摘要: 传统的多尺度红外与可见光图像融合方法,所提取的图像特征固定,并不能很好的应用于各类复杂的图像环境,而深度学习可以自主选择合适图像特征,改良特征提取单一性问题,因此提出一种基于卷积神经网络与非下采样剪切波变换(NSST)相结合的红外与可见光图像融合方法。首先,用卷积神经网络提取红外目标与背景的二分类图,利用调频(FT)显著性检测算法对分类图进行精准分割,同时,利用NSST将源图像多尺度、多方向进行分解;其次,利用目标显著性结合自适应模糊逻辑算法进行低频子带融合,利用高频系数局部方差对比度方法进行高频子带融合;最后,通过NSST逆变换得到融合后图像。实验结果表明:相比于传统图像融合算法,该方法在信息熵、平均梯度、空间频率、互信息和交叉熵等多个客观评价指标上至少分别提高了0.01%、0.30%、1.43%、2.32%、1.14%。一定程度提高了融合图像对比度,丰富了背景细节信息,更有利于人眼识别,可以广泛的应用于光电侦察、光电告警、多传感器信息融合等光电信息领域。Abstract: Traditional multi-scale infrared and visible image fusion methods couldnot be well applied to all kinds of complex image environments, because the extracted image features were fixed. However, deep learning could independently select appropriate image features to solve the unicity in feature extraction of multi-scale methods. Therefore, an infrared and visible image fusion method based on the combination of convolutional neural network and non-subsampled shear wave transform (NSST) was proposed. Firstly, the binary classification map of the infrared target and background was extracted by convolutional neural network, and the classification map was accurately segmented by frequency-tuned (FT) saliency detection algorithm. At the same time, the NSST was used to decompose the source image in multiple scales and directions; Secondly, the target saliency combined with adaptive fuzzy logic algorithm was used for the fusion of low frequency sub-bands, and the high frequency coefficient local variance contrast method was used for the fusion of high frequency sub-bands; Finally, the fused image was obtained through the inverse transformation of NSST. The experiment results show that compared with the traditional image fusion algorithm, this method improves objective evaluation indicators such as information entropy, average gradient, spatial frequency, mutual information and cross entropy at least increased by 0.01%, 0.30%, 1.43%, 2.32%, 1.14%, respectively. The contrast of fusion image is greatly improved, and the background details are enriched, which is more conducive to human eye recognition. It can be widely used in electro-optical reconnaissance, electro-optical warning, multi-sensor information fusion and other electro-optical information fields.

-

Key words:

- image fusion /

- convolutional neural network /

- saliency extraction /

- NSST /

- fuzzy logic

-

图 3 红外图像“UN Camp”及多种方法显著性提取后图像。 (a) 红外图像“UN Camp”;(b) 图像“UN Camp”标准分割图;(c) AC方法;(d) SR方法;(e) LC方法;(f) FT方法;(g) CNN方法;(h) CNN+FT方法

Figure 3. Infrared image ''UN Camp''and images after saliency extraction by various methods. (a) Infrared image "UN Camp"; (b) Standard segmentation of image "UN Camp"; (c) AC method; (d) SR method; (e) LC method; (f) FT method; (g) CNN method; (h) CNN+FT method

图 4 红外图像“dune”及多种方法显著性提取后图像。 (a) 红外图像“dune”;(b) 图像“dune”标准分割图;(c) AC方法(d) SR方法;(e) LC方法;(f) FT方法;(g) CNN方法;(h) CNN+FT方法

Figure 4. Infrared image ''dune'' and images after saliency extraction by various methods. (a) Infrared image "dune"; (b) Standard segmentation of image "dune"; (c) AC method; (d) SR method; (e) LC method; (f) FT method; (g) CNN method; (h) CNN+FT method

图 6 “UN Camp”红外和可见光图像以及融合结果。(a) 红外图像;(b) 可见光图像;(c) DWT方法;(d) CS方法;(e) BEMD方法;(f) NSCT+FL方法;(g) NSST+FL方法;(h) 文中方法;(i) 显著区域融合图像

Figure 6. ''UN Camp'' infrared and visible images and fusion results. (a) Infrared image; (b) Visible image; (c) DWT method; (d) CS method; (e) BEMD method; (f) NSCT+FL method; (g) NSST+FL method; (h) Proposed method; (i) Significant area fusion image

图 7 “dune”红外和可见光图像以及融合结果。(a) 红外图像;(b) 可见光图像;(c) DWT方法;(d) CS方法;(e) BEMD方法;(f) NSCT+FL方法;(g) NSST+FL方法;(h) 文中方法;(i) 显著区域融合图像

Figure 7. ''dune'' infrared and visible images and fusion results. (a) Infrared image; (b) Visible image; (c) DWT method; (d) CS method; (e) BEMD method; (f) NSCT+FL method; (g) NSST+FL method; (h) Proposed method; (i) Significant area fusion image

图 8 “iron”红外和可见光图像以及融合结果。(a) 红外图像;(b) 可见光图像;(c) DWT方法;(d) CS方法;(e) BEMD方法;(f) NSCT+FL方法;(g) NSST+FL方法;(h) 文中方法;(i) 显著区域融合图像

Figure 8. ''iron'' infrared and visible images and fusion results. (a) Infrared image; (b)Visible image; (c) DWT method; (d) CS method; (e) BEMD method; (f) NSCT+FL method; (g) NSST+FL method; (h) Proposed method; (i) Significant area fusion image

表 1 目标显著性提取评价指标MAE

Table 1. Target significance extraction evaluation index MAE

Method AC SR LC FT CNN CNN+FT MAE1 15.64 1.00 8.59 9.34 0.50 0.27 MAE2 8.45 0.55 2.91 2.91 0.63 0.35 表 2 红外与可见光图像融合效果评价

Table 2. Infrared and visible image fusion effect evaluation

Image Method E AG SF MI CE UN DWT 6.934 2 7.049 2 13.921 7 2.668 3 0.356 3 Camp CS 6.252 7 4.965 9 10.300 5 1.593 3 0.599 9 BEMD 6.603 8 6.146 2 12.007 7 1.573 8 0.575 9 NSCT+FL 6.810 5 7.110 9 14.126 5 2.432 8 0.326 4 NSST+FL 6.855 5 7.051 6 14.475 8 2.355 0 0.279 8 Proposed method 7.116 3 8.008 2 16.106 9 2.991 9 0.264 8 Dune DWT 6.657 4 6.507 5 12.371 8 2.594 3 0.307 2 CS 5.903 8 4.694 8 9.790 9 1.188 4 0.654 5 BEMD 6.156 6 5.426 7 10.391 4 1.196 5 0.576 0 NSCT+FL 6.675 8 6.578 3 15.540 9 2.222 0 0.292 5 NSST+FL 6.666 7 7.365 3 13.954 2 2.637 0 0.301 4 Proposed method 6.701 1 7.386 8 14.153 9 2.815 7 0.289 2 Iron DWT 6.677 8 12.647 6 33.730 4 3.617 3 0.550 3 CS 6.537 2 7.647 5 20.025 4 3.177 3 0.498 7 BEMD 6.677 7 9.090 6 23.349 1 3.392 5 0.539 7 NSCT+FL 6.767 7 14.998 1 38.969 7 3.397 5 0.474 5 NSST+FL 6.751 1 15.645 4 40.410 4 3.177 4 0.427 9 Proposed method 6.768 7 16.282 2 41.718 8 3.701 3 0.409 3 -

[1] Lu Jiuming, Meng Weihua. Infrared small target detection based on fully convolutional neural network and visual saliency [J]. Acta Photonica Sinica, 2020, 49(7): 0710003. (in Chinese) [2] Yan Ge, Xu Tingfa, Ma Xu, et al. Hyperspectral image com-pression sensing based on dynamic measurement [J]. Chinese Optics, 2018, 11(4): 550-559. (in Chinese) [3] Chen Qingjiang, Zhang Yanbo, Chai Yuzhou, et al. Fusionof infrared and visible images based on finite discrete she-arlet domain [J]. Chinese Optics, 2016, 9(5): 523-531. (in Chinese) doi: 10.3788/co.20160905.0523 [4] Zhou Yuren, Geng Anhui, Zhang Qian, et al. Fusion of in-frared and visible images based on compressive sensing [J]. Optics and Precision Engineering, 2015, 23(3): 855-863. (in Chinese) doi: 10.3788/OPE.20152303.0855 [5] Wang Wenxiu, Fu Yutian, Dong Feng, et al. Infrared ship T-arget detection method based on deep convolution neural network [J]. Acta Optica Sinica, 2018, 38(7): 0712006. (in Chinese) [6] Zeng Hanlin, Meng Xiangyong, Qian Weixian. Image fusion algorithm based on DOG filter [J]. Infrared and Laser Engineering, 2020, 49(S1): 20200091. (in Chinese) [7] Wang Xi, Ji Tongbo, Liu Fu. Fusion of infrared and visible images based on target segmentation and compressed sens-ing [J]. Optics and Precision Engineering, 2016, 24(7): 1743-1753. (in Chinese) doi: 10.3788/OPE.20162407.1743 [8] Dai Jindun, Liu Yadong, Mao Xianyin, et al. Infrared and visi-ble light image fusion based on FDST and dual-channel PCNN [J]. Infrared and Laser Engineering, 2019, 48(2): 0204001. (in Chinese) [9] Li Jiao, Yang Yangchun, Dang Jianwu, et al. NSST and gui-ded filtering for multi-focus image fusion algorithm [J]. Journal of Harbin Institute of Technology, 2018, 50(11): 145-152. (in Chinese) doi: 10.11918/j.issn.0367-6234.201805006 [10] Rahman M A, Liu S, Wong C Y. Multi-focal image fusion using degree of focus and fuzzy logic [J]. Digital Signal Processing, 2017, 1(60): 1-19. [11] He Kangjian, Zhou Dongming, Zhang Xuejie, et al. Multi-focus image fusion combining focus region level partition and pulsecoupled neural network [J]. Soft Computing, 2019(23): 4685-4699. [12] Li Hui, Wu Xiaojun. Infrared and visible image fusion with ResNet and zero phase component analysis [J]. Infrared Physics and Technology, 2019, 11(102): 103039. [13] Yong Yong, Nie Zhipeng, Huang Shuying, et al. Multi-level features convolutional neural network for multi-focus image fusion [J]. IEEE Transactions on Computational Imaging, 2019, 5(2): 262-273. doi: 10.1109/TCI.2018.2889959 [14] An Wenbo, Wang Hongmei. Infrared and visible image fu-sion with supervised convolutional neural network [J]. Optik, 2020: 165120. [15] Liu Yu, Chen Xun, Cheng Juan, et al. Infrared and visible image fusion with convolutional neural networks [J]. International Journal of Wavelets, Multiresolution and Information Processing, 2018, 6(5): 1850018. [16] Toet A. TNO Image fusion dataset[DB/OL]. [2014-04-26]. https://figshare.om/articles/TN/Image/Fusion/Data-setYang -

下载:

下载: