-

随着世界科技的发展,世界各国目标信息获取与应用需求日益迫切,尤其是现今国际局势紧张,提升我国国防技术能力势在必行,而空中目标的信息获取是目标信息获取领域的重要方面,在此情形下,研发新型空中目标信息获取技术对促进社会进步、保障国民安全重要意义[1-3]。

基于目标大气扰动的目标探测技术作为一种新型的目标探测技术,利用空中目标飞行时与大气环境发生的交互作用——大气扰动作为探测目标,通过对目标大气扰动的探测确定目标位置,具有探测效能不受现有军事技术影响的显著优势,具有巨大的发展前景。基于目标大气扰动的目标探测技术的实现主要依靠图像处理技术,通过对探测图像中目标大气扰动信息的检出进行大气扰动反演,进而实现目标探测。因此,高精度目标大气扰动图像处理方法是基于目标大气扰动的目标探测技术的关键技术之一。

文中主要介绍高精度目标大气扰动图像处理方法,主要分为四个方面:互相关方法、光流方法、帧间差分法、背景减除法。研究了上述目标大气扰动图像处理方法的技术原理以及发展现状,分析现阶段四种目标大气扰动图像处理方法的关键技术及优劣势,最后对四种方法以及高精度目标大气扰动图像处理方法未来的发展方向进行展望与总结。

-

目标的大气扰动是物体高速飞行时,由于空气的粘性效应,在几何和气动外形上的气流阻碍作用伴随着气流的减速增压而产生的空气动力学现象。

目标大气扰动主要改变空中的密度分布,由于光线在不同密度的介质中折射率不同,大气扰动会使光线传播发生折射,通过这一基本原理可以检出目标的大气扰动,现以激波现象为例,阐述其基本原理,具体如下。

由于空气的粘性效应,飞行器飞行会对大气气体进行压缩,形成大气扰动场,使大气密度变大,引起折射率变化。根据空气动力学原理,物体在空气中超音速飞行时会产生激波,如图1所示。

对于激波,设其波前参数为$ {p}_{1}、{T}_{1}、{\rho }_{1}、{V}_{1} $,波后参数为$ {p}_{2}、{T}_{2}、{\rho }_{2}、{V}_{2} $。

根据连续方程$\;{\rho _1}{V_1} = {\rho _2}{V_2}$,动量定理${p_1} + {\rho _1}V_1^2 = {p_2} + {\rho _2}V_2^2$ ,能量方程${h_1} + V_1^2/2 = {h_2} + V_2^2/2$,状态方程${p_1} = {\rho _1}R{T_1},{p_2} = {\rho _2}R{T_2}$,可以得出激波前后气流密度之间的关系:

$$ \frac{{{\rho _2}}}{{{\rho _1}}} = \frac{{(k + 1)M_1^2}}{{(k - 1)M_1^2 + 2}} $$ (1) 式中:k为绝热指数;${M_1}$为波前马赫数。

由此可知,飞机高速飞行会使空气密度发生改变,其改变程度与飞机飞行速度、空气绝热指数等因素相关。

光线偏折原理即空气密度变化引起折射率变化的原理,可以用洛伦兹-洛伦茨方程(Lorentz-Lorenz equation)来表示:

$$ \frac{{{n^2} - 1}}{{{n^2} + 2}} = \frac{{4\pi }}{3}N\alpha $$ (2) 式中:$N$为单位体积内的分子数;$\alpha $为平均极化率。对于气体而言,洛伦兹-洛伦茨方程可以简化为格拉德斯通-戴尔方程(Gladstone-Dale equation):

$$ n - 1 = K\rho $$ (3) 式中: $K$为格拉德斯通-戴尔常数;$\;\rho $为密度。上式给出了气体折射率与密度之间的定量关系。因此,利用大气扰动引起的大气密度变化,进而引起大气扰动区折射率变化的原理,通过探测地物光线通过大气扰动区域形成的图像变化,可实现目标大气扰动的探测。

-

目前,大气扰动目标探测主要依靠纹影技术实现,应用于纹影技术中的图像处理方法主要有两种:互相关法与光流法。同时,目标大气扰动由空中目标运动产生,随目标运动而运动,故对于目标大气扰动的探测本质上为运动目标检测,运动目标检测方法也可应用于大气扰动检测;目前,运动目标检测的主要方法有:帧间差分法、背景减除法和光流法。所以综上所述,目前可应用于大气扰动目标探测图像处理的方法主要有互相关法、光流法、帧间差分法、背景减除法四种。

-

互相关算法的基本实现方式是对连续拍摄到的两幅流场图片进行匹配,从而求出流场信息。在实际应用中,一般图像的像素很高,直接对两幅图像进行匹配计算量过大,准确率受限,所以一般先对两幅图像分块,然后对每一对对应的小块进行匹配,这样就可以求出每个小块内的流场信息,因为两幅图片拍摄间隔极短,所以可以近似地认为所求出的流场信息即可以表征真实流场情况,然后遍历整幅图片,就可以求出流场的全部信息。互相关算法的基本执行步骤如图2所示[4-5]。

假设存在连续两幅图像,分别为${t_1}$时刻的流场图像与${t_2}$时刻的流场图像。假设两帧图像在很短的时间间隔内$\Delta t = {t_2} - {t_1}$,图像相应像元分别在$x$方向和$ y$方向上的位移分别表示为$(\Delta x,\Delta y)$。如果${t_1}$时刻的流场图像可以表示为$q(x,y) = I(x,y) + {n_1}(x,y)$,当两幅图像拍摄的时间间隔足够小时,可以认为流场内其他条件不变,则${t_2} = {t_1} + \Delta t$时刻流场图像的位移可写成$q(x,y) = I(x + \Delta x,y + \Delta y) + {n_2}(x,y)$;其中,${n_1}(x,y)$与${n_2}(x,y)$为图像系统中的随机噪音。假定噪音${n_1}(x,y)$与${n_2}(x,y)$的有效图像函数$I(x,y)$在统计意义上不相关,计算$p(x,y)$与$q(x, y)$的互相关函数${r_{pq}}({\tau _x},{\tau _y})$,可以得到如下公式:

$$ \begin{split} {r_{pq}}({\tau _x},{\tau _y}) =& \int\limits_{ - \infty }^\infty {\int\limits_{ - \infty }^\infty {p\left( {x,y} \right)q(x + {\tau _x},y + {\tau _y}){\rm{d}}x{\rm{d}}y} } = \\ & \int\limits_{ - \infty }^\infty {\int\limits_{ - \infty }^\infty {I\left( {x,y} \right)I(x + \Delta x + {\tau _x},y + \Delta y + {\tau _y}){\rm{d}}x{\rm{d}}y} } \\ \end{split} $$ (4) 根据自相关函数的定义,$I\left( {x,y} \right)$的自相关函数为:

$$ r({\tau _x},{\tau _y}) = \int\limits_{ - \infty }^\infty {\int\limits_{ - \infty }^\infty {I\left( {x,y} \right)I(x + {\tau _x},y + {\tau _y}){\rm{d}}x{\rm{d}}y} } $$ (5) 则$r({\tau _x},{\tau _y})$可以转化为:

$$ {r_{pq}}({\tau _x},{\tau _y}) = r({\tau _x} + \Delta x,{\tau _y} + \Delta y) $$ (6) 自相关函数是偶函数,并在原点取得最大值,即:

$$ r({\tau _x},{\tau _y}) \leqslant r(0,0) $$ (7) 所以,如下不等式成立:

$$ {r_{pq}}({\tau _x},{\tau _y}) \leqslant {r_{pq}}( - \Delta x, - \Delta y) $$ (8) 由此可知,图像像元的最大位移即为互相关函数的峰值所处的位置,其中峰值的高度即为像元位移变化速度的大小,峰值距离中心点的方向即为流场流动的方向。

根据互相关算法的基本原理可知,传统互相关算法采用傅里叶变换的方式进行数据处理,计算目标的运动情况,主要存在运算效率较低、计算准确率较差的问题。针对上述两方面问题,国内外学者开展了大量的互相关算法优化研究。

在提高运算效率方面,2006年,Zahiri等人提出具有先验估计的时域互相关算法进行图像运动估计,该方法可以提高10倍运算速度[6];2008年,Jimmy等人提出一种快速序列互相关算法,可以不通过FFT进行快速的有效计算[7];2009年,Jae等人提出一种快速归一化互相关方法,显著提高了计算速度及准确率[8];2010年,Jian等人提出一种运动估计的快速归一化互相关方法,采用穷举搜素与高窗口重叠的方法进行计算,显著提升了运算效率[9];2017年,Chang等人提出用矢量化方法提高数据互相关的计算效率,可以将处理速度提高26倍[10]。

近年来,大部分学者将注意力转移至提高互相关算法精度的研究中。2011年,Hijazi等人提出一种基于离子图像测速说的两步互相关运动估计算法,该算法对90%的估计速度的偏差小于0.2 pixel[11];2012年,Jose等人提出一种互相关与差分技术相结合的位移场测量技术,该算法通过数字图像相关算法实现,实验表明该算法具有更可靠的位移估计[12];2015年,Shi等人利用小波变换和多分辨率分析的思想,提出一种分层处理算法,实验表明该算法具有良好的性能与可靠性[13]。2017年,Wang等人提出一种结合归一化互相关和粒子群算法的运动估计方法,利用粒子群算法为不同数据寻找最佳窗口长度,有效提高了算法精度[14]。2021年,Tekwani等人分析了模式特征对运动估计的影响,建立了一种基于模式跟踪的互相关运动估计算法[15]。同年,Sahu等人利用卡尔曼滤波同图像互相关相结合的方法,设计了一种气流速度估计算法,该方法的平均误差为3.31%,算法执行效率优于常规互相关方法[16]。2022年,Li等人利用联合特征和最大互相关算法对GF-3号图像进行了处理,获取了海冰的运动数据,该算法速度计算的不确定性优于0.3 cm/s[17]。

综上所述,国内外对互相关算法的优化已进行了大量研究,增强了算法鲁棒性和测量精度,但互相关算法本身存在一些由其检测原理衍生出的局限性。具体如下:

1)空间分辨率降低:由于互相关算法中一个查询窗口只能输出一个速度矢量;因此,互相关PIV算法最终只能够输出稀疏的流场,空间分辨率受到限制;

2)互相关理论基本假设限制:由于互相关算法假设一个窗口内的所有粒子的运动状态一致,故算法检出效果在复杂流场条件下的准确率较低;

3)物理约束限制:互相关算法本质上是一个匹配过程,计算查询窗口与目标位置的匹配程度,其中每个矢量相对独立,没有考虑到流体对象的局部或者全局的物理约束,易受到流场特性与环境噪声的影响。

总而言之,互相关算法存在一定的算法局限性,在对大范围、均匀流场且环境背景不变或变化较小的场景中应用效果较好。

-

光流算法有以下三个前提假设:

1)相邻帧图像像素的亮度恒定不变;

2)相邻帧图像中像素点都不会产生较大运动;

3)图像内同一子图像像素点以类似方式运动。

假设像素点$ (x,y) $在$ t $时刻的亮度为$ I(x,y,t) $,经过$ \Delta t $时间后,即在$ t + \Delta t $时刻,该像素点的亮度为$I(x + \Delta x,y + \Delta y,t + \Delta t)$。当$ \Delta t \to 0 $时,根据假设1)可知:

$$ I(x,y,t) = I(x + \Delta x,y + \Delta y,t + \Delta t) $$ (9) 对上式进行一级泰勒级数展开,可得:

$$ \begin{split} & I(x + \Delta x,y + \Delta y,t + \Delta t) = \\ & I(x,y,t) + \frac{{\partial I}}{{\partial x}}\frac{{\Delta x}}{{\Delta t}} + \frac{{\partial I}}{{\partial y}}\frac{{\Delta y}}{{\Delta t}} + \frac{{\partial I}}{{\partial t}} + \varepsilon \\ \end{split} $$ (10) 式中:$ \varepsilon $为高阶无穷小项,由假设2)可知相邻帧图像中像素点移动很小,所以高阶无穷小项占可以忽略不计,那么可以得到:

$$ \frac{{\partial I}}{{\partial x}}\frac{{\Delta x}}{{\Delta t}} + \frac{{\partial I}}{{\partial y}}\frac{{\Delta y}}{{\Delta t}} + \frac{{\partial I}}{{\partial t}} = 0 $$ (11) 设$ u{\text{ = }}{{\Delta x} \mathord{\left/ {\vphantom {{\Delta x} {\Delta t}}} \right. } {\Delta t}} $和$ v{\text{ = }}{{\Delta y} \mathord{\left/ {\vphantom {{\Delta y} {\Delta t}}} \right. } {\Delta t}} $,分别为像素点水平方向的速度分量和垂直方向上的速度分量,代入上式可得:

$$ {I_x}u + {I_y}v + {I_t} = 0 $$ (12) 式中:$ {I_x} $,$ {I_y} $和$ {I_t} $分别为图像灰度值在$ x $,$ y $,$ t $三个方向上的偏导数。

上式被称为光流场基本方程,写成矢量形式为:

$$ \nabla I \cdot U + {I_t} = 0 $$ (13) 式中:$ \nabla I = ({I_x},{I_y}) $表示图像在$ (x,y) $处像素点灰度值的梯度;$ U = (u,v) $为$ (x,y) $处的光流。

通过求取的光流信息即可求取图像中的目标信息,即目标大气扰动信息。

由于像素点的光流速度分量是二维的,有两个变量$ u $和$ v $,而上述各式中只有一个约束条件,所以不能唯一地确定光流。为了能够唯一地确定光流,必须增加新的约束条件。研究人员为此提出了几种新的约束条件,比如Horn和Schunck等人将光流的全局平滑性假设作为新的约束条件来求解,即Horn-Schunck光流算法,Lucas和Kanade等人将局部平滑性假设作为新的约束条件进行求解,即Lucas-Kanade光流算法,之后也有很多研究人员在这两种经典光流算法的基础上提出了改进算法[18]。

光流估计方法的发展进程按照时间顺序大致分为三个阶段:基于能量函数的方法、由稀疏到稠密的方法和基于深度学习的光流估计方法,如图3所示。

光流法发展第一阶段处于1981~2016年期间,此期间主要采用最小化能量函数方法求解光流,如由Horn和Schunck提出的由光滑项与规则项组成的能量函数;此类方法是经典的求光流的方法,缺点是计算复杂度较高,且容易陷入局部最优值,此期间一些较有代表性的光流法大致如下:

1986年,Nagel首先将利用有条件的约束,采用加权矩阵对数据进行平滑处理,对H-S法进行改进[19];1991年,Fleet等人提出了相位法,将图像变换到频率域中,使得光流在梯度变化较小时仍然保持敏感[20];2001年,Bouguet通过改变光流的计算模型来提高光流计算速度或计算精度[21];2011年,Sundberg等在基于FPGA的稀疏光流场硬件加速的基础上实现了完整的KLT 算法,取得了很好的效果[22];Zimmer等人提出在计算过程中用上次迭代计算产生的光流场的梯度方向来导向平滑,使得光流场边缘清晰并分段平滑[23]。

2011年,光流法进入第二个发展阶段,其主要代表为2011年Brox等人提出的在能量函数中插入匹配项,通过求取匹配值作为光流的初始化再插值的优化方法,即变分光流计算方法。此类方法获得更优的光流初始值,鲁棒的匹配和插值结果有助于最后能量函数的优化[24]。

2014年,Sun等人利用基于加权中值滤波的非局部优化模型(Classic+Non-local, classic+NL)消除光流计算过程中的异常值,取得较好的效果[25];2016年,Hu等人提出基于最近邻域场的计算策略,用于提高大位移光流估计的精度和鲁棒性[26];2018年,Maurer等人提出运动感知块匹配方法,大幅提高刚性物体大位移运动光流估计的性能[27];2019年,Yin等人提出一种基于匹配密度估计的光流计算方法,用于提高大位移光流估计的精度和鲁棒性[28];同年,Chen 等人提出基于分段块匹配的光流计算模型,增强全局正则化的鲁棒性,有效提高了大位移运动光流的估计精度[29]。

2015年,光流法发展进入第三个阶段,同年,德国弗莱堡大学的Dosovitskiy等人首次提出利用卷积神经网络进行光流估计的方法FlowNet1.0,将光流在能量函数上的在线优化过程转为在卷积神经网络上进行的离线优化过程[30]。该类方法首先利用卷积神经网络在多尺度空间提取图像特征,然后根据图像特征建立相邻帧图像像素点的对应关系,最后根据像素对应关系预测光流。

2015年,Dosovitskiy等人基于有监督学习的光流网络,验证了利用通用U型网络架构直接估计图像光流的可行性[31];2017年,IIg等人在FlowNet模型上进行堆叠,设计光流网络2.0(FlowNet 2.0),提高了深度学习光流估计的精度[32];2018年,Sun等人提出紧凑型卷积神经网络光流估计方法(PWC-Net),在减少模型尺寸、参数量的同时有效提高光流的计算精度[33];2019年,Hur等利用计算图像序列的前向光流与后向光流并进行匹配的方法,提高运动遮挡图像序列的光流计算可靠性[30];2020年,Hofinger等人提出使用采样策略代替变形策略,有效避免了变形策略引起的重影问题[34];同年,Zhao等人设计可学习遮挡掩模的非对称特征匹配模块,学习粗级遮挡掩摸,在特征变形后过滤无用遮挡区域,提高了遮挡区域光流估计的准确性[35]。

光流法在理想情况下, 图像的光流场与成像平面上的二维运动场是吻合的, 但实际中物体运动情况复杂,且环境改变也会引起光流变化,从而导致光流法存在以下局限。

1)孔径问题:光流法在进行孔径图像检测时容易陷入局部最优的求取,缺乏对全局情况的把握,造成运动估计不准确。

2)遮挡问题:当物体在运动过程中被其他物体挡住,或物体自身旋转造成部分特征被挡住时,在图像上会表现为前一帧图像中的某些特征在后一帧中消失,光流法在处理这类图像时会因找不到特征关系而无法计算光流或者产生错误的光流。

3)光照变化:照变化对光流估计影响严重,在一些特殊情况下,光流场不能等效于运动场。光流的产生基于图像像素亮度变化,如果物体本身没有运动,其表面亮度发生变化,同样可以产生光流。

4)边界问题:如何处理运动边界处的光流是光流计算的一个难题。理想的光流估计要求既能保留清晰的运动边界,又要使光流尽可能地平滑,但是实际情况中二者难以同时满足。

综上所述,光流法由于其三项基本假设,在实际应用中受光照影响较大,存在一定的局限。

-

帧间差分法有两帧差分法、三帧差分法以及其他多帧差分法的区别,其原理基本相同,下面主要介绍两帧差分法与三帧差分法的基本原理。

两帧差分法每次利用连续两帧的变化检测目标。设$ {I_{t - 1}}(x,y) $和$ {I_t}(x,y) $分别为$ t - 1 $时刻和$ t $时刻的图像帧,计算$ {I_t}(x,y) $和$ {I_{t - 1}}(x,y) $的绝对差值来得到差分图像$ {D_t}(x,y) $:

$$ {D_t}(x,y) = \left| {{I_t}(x,y) - {I_{t - 1}}(x,y)} \right| $$ (14) 在得到差分图像后,需要设置阈值$ T $对其进行二值化处理,通过判断$ {D_t}(x,y) $与$ T $的大小关系分割前景和背景,前景图像$ {f_t}(x,y) $的获取方式为:

$$ {f_t}(x,y) = \left\{ \begin{gathered} 1 \;\; {D_t}(x,y) \gt T \\ 0 \;\; {D_t}(x,y) \lt T \\ \end{gathered} \right. $$ (15) 得到二值图像后通常需要进行形态学滤波等后处理来获得一个较为完整的前景区域。

三帧差分利用三帧图像进行差分,计算两个相邻图像之间的差值,将它们的结果作与运算得到最终的结果。取三帧图像分别为$ {I_{t - 1}}(x,y) $、$ {I_t}(x,y) $和$ {I_{t + 1}}(x,y) $,按上式计算差分图像,获得$ {D_t}(x,y) $和$ {D_{t + 1}}(x,y) $,同样设定阈值进行二值化后得到$ {f_t}(x,y) $和$ {f_{t + 1}}(x,y) $,最终的结果为:

$$ {f_t}' (x,y) = {f_t}(x,y) \cap {f_{t + 1}}(x,y) $$ (16) 三帧差分法考虑了图像连续帧之间的相关性,抑制了背景的变化,但该方法仍受限于阈值的选取,并难以解决动态背景和光照变化。

通过阈值分离图像中的前景区域与背景区域,前景区域即为图像中的目标信息,以此对目标大气扰动图像进行处理[36]。

帧间差分法的主要问题首先是对复杂场景中的运动目标往往不能够得到完整的边缘信息;其次是差分图像效果受帧间时间间隔影响较大;再次,若运动目标的颜色分布均匀,则重叠的区域无法分辨,检测获取的运动目标区域就会发生漏检,出现目标运动区域“空洞”的现象。

针对帧间差分法的上述问题,国内外学者对帧间差分法的优化问题开展了多方面的研究,具体如下:

2011年,Yin等人提出均值漂移方法与帧间差分法相结合的帧间差分优化方法,帧间差分法对目标粗定位,均值漂移滤波算法对目标精确跟踪,提升检出效果[37];2012年,Zhang等人利用三帧相减的方法提取目标,利用数学形态学方法对图像进行处理,该方法显著地消除了噪声[38];2015年,Fan等人提出一种基于Susan边缘检测的帧间差分法,实验证明该方法简单有效,具有一定实用价值[39]; 2017年,Du等人提出一种融合核相关滤波和三帧差分的优化帧间差分算法,算法融合核相关滤波器与帧间差分法获取的目标信息,大大提高了目标运动信息获取的准确性[40];同年,Sandeep等人提出一种基于帧间差分法与W4法的帧间差分法优化方法,该方法可以有效克服帧间差分法的孔洞和重影问题[41];2019年,Gao等人利用纹理特征和Lab颜色空间对帧间差分法进行优化,结合图像纹理特征与颜色特征,利用两帧差分法对运动目标进行检测,该方法可以有效提高目标检测性能[42];同年,Shang等人提出一种融合优化五帧差法和优化更新速率码本的行人检测算法,利用设计的码本模型以及改进的五帧差分法分别获取前景图像并进行融合,得到目标的精确区域,该算法具有良好的鲁棒性与准确性[43];2020年,Ou等人设计了一种基于深度帧差卷积神经网络的运动目标检测方法,基于帧间差分法的原理,采用深度学习的方法进行运动目标检测,该方法在复杂场景中具有良好的监测性能[44];2021年,Zheng等人提出利用高斯建模算法来修复传统帧差法产生的孔洞与断裂,采用自适应学习模型,结合改进的三帧差分法获取目标运动的前景图像。该团队还提出采用U-Net深度学习网络进行运动目标检测,实验证明,该算法能够抑制帧间差分法孔洞的产生和破裂,有效降低噪声[45];2022年,Ding等人提出一种结合卷积神经网络的帧间差分法,采用YOLOv5与帧间差分法相结合,大幅度提高了帧间差分法的检测精度[46]。

帧间差分法原理较为简单,算法实时性较好,但同样存在一定的局限性:

1) “空洞”问题:帧间差分法在检出目标时,容易在物体内部产生“空洞”现象,导致目标检测结果不完整;

2)分割阈值:帧间差分法对于前景与背景分割阈值的要求较高,不同场景下分割阈值的选取不同,环境适应性较差。

综上所述,帧间差分法存在的主要问题即为分割阈值选取问题,其限制着帧间差分法的实际应用。

-

背景减除法主要通过对图像信息进行前景图像与背景图像分离完成目标检测,可以分为以下几个步骤:

1)模型选择,选择描述背景的模型;

2)背景初始化,利用前N帧初始化不含目标的背景模型;

3)前景检测,通过比较待检测图像与背景模型的差异获得前景;

4)模型更新,利用检测结果对背景模型进行更新。

在图像序列检测过程中,步骤3)和步骤4)不断循环。有的检测方法会加入如噪声抑制、形态学滤波等后处理的过程。在实际应用中,若由于镜头移动或突然抖动造成图像序列内容出现较大变化,检测方法会进行重新初始化。设$ t $时刻图像为$ {I_t}(x,y) $,$ t - 1 $时刻保存的背景图像为$ {B_{t - 1}}(x,y) $,则通用的前景检测可以表示为:

$$ d[{I_t}(x,y),{B_{t - 1}}(x,y)] \gt T $$ (17) 式中:$ d $表示计算两者之间的距离,最简单的距离为绝对差值。满足上式的像素点将被划分为前景,否则为背景。检测完成后对背景图像进行更新,比较常用的方式是加权平均,具体形式如下:

$$ {B_t}(x,y) = (1 - \alpha ){B_{t - 1}}(x,y) + \alpha {I_t}(x,y) $$ (18) 式中:$ \alpha \in \left[ {0,1} \right] $称为学习率。如果前景区域也用于更新背景模型会导致背景模型被前景破坏,所以有的方法采用保守更新的策略,即只更新被检测为背景的区域。

$$ {B_t}(x,y) = \left\{ \begin{gathered} (1 - \alpha ){B_{t - 1}}(x,y) + \alpha {I_t}(x,y) \;\;\;\;\; (x,y) \in B \\ {B_{t - 1}}(x,y) \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\; (x,y) \in F \\ \end{gathered} \right. $$ (19) 式中:$ F $和$ B $分别表示得到的前景和背景区域。通过前景区域与背景区域的分离来确定图像中的目标信息,以此进行目标大气扰动信息的检测。

背景减除方法中, 混合高斯模型和视觉背景提取(ViBe)方法被认为是两种经典方法,反复被研究者进行改进[47]。

关于混合高斯模型方面,国内外学者的研究主要围绕提高混合高斯模型的运算速率、提高方法的准确率两个方面,其中第二个方面是学者研究的重点方向。混合高斯模型国内外发展情况大体如下。

2013年,Li等人提出一种改进的混合高斯模型,基于归一化RGB空间进行阴影消除,该模型具良好的适应性与鲁棒性[48];2014年,Li等人提出一种自适应高斯混合模型,通过引入光照变化因子和模型参数的更新技术以及采用自适应选择的组件数来自适应调整学习率,提高算法运算速率,具有较高的适应性与鲁棒性[49];2017年,Ji等人提出一种鲁棒的基于粗糙集的改进高斯混合模型图像分割方法,构造了一个新的空间权重因子与新的先验因子,利用三个自动确定的粗略区域来表征每个高斯分量,该算法有效提升了混合高斯模型的性能[50];2018年,Isabel等人将色彩空间辨别能力与滞后和用于背景模型更新的动态学习速率相结合,有效地提高了混合高斯模型背景减除方法的运算速率[51];同年,Deepak等人利用Wronskian函数的空间关系,在混合高斯模型中采用了一种新的模糊自适应学习速率,并提出一种加权小波变换来减轻动态背景像素的影响,得到了更好的效果[52];Chen等人采用帧间差分法进行运动目标检测,优化混合高斯模型,达到97.29%的准确率,准确率有明显的提高[53];2020年,Dong等人在混合高斯模型算法初始化背景模型的基础上,利用Kanade-Lucas-Tomas特征跟踪器检测两帧相邻的光流特征点,利用随机抽样一致性算法过滤出正确的匹配点获取图像的背景模型,显著提高了算法精度与运算速度[54];2021年,Ajisha等人通过二维经验模式分解从场景中提取特征,通过混合高斯模型进行前景与背景的分离,有效提高了背景减除方法的性能[55];2022年,Liu等人结合采用像素漂移去噪算法,优化混合高斯模型,提高了混合高斯模型的性能[56];同年,Pan等人将原始图像中加入频率调谐得到显著图并与原始图像合并,显著图的值以空间信息权重的形式加入混合高斯模型,该法通过期望最大化算法计算模型参数,有效提高算法的精度与鲁棒性[57]。

关于背景视觉提取方法的改进与优化,现阶段的研究主要围绕着消除鬼影与提高动态背景适应性两方面,大体如下。

2014年,Han等人提出一种使用自适应距离阈值对背景视觉提取方法进行改进的方法,有效提升了背景视觉提取方法的背景减除效果[58]。2015年,Wang等人基于直方图统计的图像亮度归一化方法提出一种具有光照鲁棒性的视觉背景提取方法,可以有效提高算法的检测精度与鲁棒性[59]。2017年,Yang等人提出两种具有自适应变化能力的模型来优化背景视觉提取方法,一为闪烁能量模型,可以通过增加范围来检测动态背景,二为对象概率模型,可以通过减小范围来防止运动对象的腐蚀。该方法既能准确识别动态背景,又能有效防止物体腐蚀[60]。同年,Zhao等人引入的速度信息来更准确地去除鬼影和噪声点,利用方向信息来减少动态背景干扰,有效提高了视觉背景提取方法的准确性与鲁棒性[61]。2018年,Zhao等人利用引导滤波器在图像预处理阶段对图像进行增强,从而有效增强了视觉背景提取方法的性能[62]。2020年,Zuo等人利用二次判断来消除像素空间传输过程中的鬼像素干扰,并通过分析像素的闪烁程度来抑制动态背景像素干扰,有效提高了算法的准确性[63]。2021年,Yang等人采用KLT的运动补偿方法获取背景模型,引入OTSU算法获得最佳阈值,增强算法对动态背景的鲁棒性[64]。同年,Liu等人利用像素的时空信息,得到自适应的分割阈值,进行视觉背景提取,有效提高了动态背景的检测效果[65]。2022年,Ihssane等人利用RGB与深度通道获得背景分割的初步结果,同背景视觉提取方法的结果进行融合,有效提升了视觉背景提取方法的性能[66]。

背景减除法按照背景模型进行运动目标检测,因此背景模型的构建对背景减除法的检测效果影响巨大,由此背景减除法面临了一些问题:

1)背景模型构建,背景模型构建是背景减除法的关键,在实际应用中,背景模型需不断更新,造成算法效率低,同时背景模型的构建需要一定的先验信息,实际应用受限;

2)阴影问题:同光流法类似,图像中的阴影问题将严重影响目标检出的效果;

3)鬼影问题:利用背景减除法对运动目标进行检测时,会在图像中出现“空洞”问题。

综上所述,背景减除法由于需要背景模型的构建,在实时运动目标检测应用中存在一定的局限,同时背景减除法同样受光照条件影响较大。

-

根据上述分析,上述四种目标大气扰动图像处理方法,各有其局限性,如互相关算法计算准确率较差;光流法计算复杂度较高,实时性较差;帧间差分法易发生漏检与“空洞”的现象;背景减除法中的混合高斯模型需要先验信息,运算效率低;背景视觉提取法存在鬼影现像、背景适应性较差等,各类方法的局限性具体见表1。

表 1 各类目标大气扰动图像处理方法局限性

Table 1. Limitations of various target atmospheric disturbance image processing methods

Image processing method of target atmospheric disturbance Limitation Cross-correlation method The resolution of processing results is reduced, the calculation accuracy is poor, the detection effect is easily affected by the characteristics of flow field and environmental noise, and the application is limited in complex environment Optical flow method The calculation complexity is high, the timeliness is poor, and it is easy to fall into the local optimal value. When the illumination conditions change, there are occlusions, and the target moves locally, the detection effect is poor, and the application is limited Interframe difference method The ability of complete extraction of target information is poor, and the phenomenon of missing detection and "void" is easy to occur. The calculation accuracy is poor, and the detection effect is poor under the moving background or when the background changes dramatically Background subtraction Mixed Gaussian model Prior information is required to build the background model, which has low operational efficiency and limited application when the background changes dramatically ViBe method The background model construction method is relatively simple with large error, resulting in poor calculation accuracy. Also, due to the background model, its application is limited in the scene with drastic changes in the background environment 针对现阶段目标大气扰动图像处理算法的局限性,国内外学者纷纷进行优化改进方案的研究,具体的可以分为优化算法自身、同其他图像处理方法融合以及基于神经网络方法三种技术优化途径,下面对三种技术途径的最新研究进展进行介绍。

-

通过优化目标大气扰动图像处理算法,提高目标大气扰动图像的处理效率,提升准确度,弥补自身局限性,可以有效地提升目标大气扰动图像处理算法的运行速率、精度等。

在互相关算法方面,对其算法自身的优化主要集中于特征选取与跟踪方面。2021年,Hema Tekwani等人提出的基于模式跟踪的互相关运动估计算法(图4),利用交叉相关的方式进行图像相关。该方法可有效应用于高速摄像机进行双目物体运动估计[15]。

图 4 基于模式跟踪的互相关算法基本流程图

Figure 4. Basic flow chart of cross-correlation algorithm based on pattern tracking

2022年,中国科学院谢宗明团队利用约束条件对互相关算法进行优化,通过构建一个目标函数(包括归一化互相关项的剩余量),一个负责空间平滑性的分量,一个负责时间平滑性的分量,通过最小化该目标函数得到一系列图像的最佳速度场。该算法减除系统误差仅为0.05 pixel的量级,测量不确定度约为0.1 pixel[67]。

同年,武汉大学 Li Mingci等人提出一种结合特征跟踪和最大互相关的运动估计算法,该算法首先对图像进行预处理,产生灰度图像;其次,计算非均匀分布的运动向量;再次,执行线性和多项式插值来估计规则网格上的运动向量,并利用最大互相关算法改进估计的运动向量;最后,利用基于局部一致流场过滤的方法,移除错误的运动向量。根据实验结果评估,该算法速度估计的结果误差为mm/s量级,具有较好的实用性。

在光流法方面,2021年,重庆科技大学Song Tao 等人提出一种基于半稠密光流的优化方法,该方法首先通过计算图像中像素梯度较大的像素点来保存特征点;其次,根据灰度不变形原理,构造相邻帧对应特征点之间的灰度差函数;最后,利用梯度下降原理优化灰度差函数,实现相邻帧对应特征点的精确匹配[68]。

帧间差分法方面,2021年,北京工业大学 Guo Wen-yue等人提出的一种基于精确运动矢量补偿的帧间差分优化方法。该方法首先采用SURF算法获取运动向量的匹配对;其次,使用RANSAC算法获取精确的运动向量;再次,采用自适应背景滤波方法消除目标运动矢量对全局运动估计的影响,并通过建立背景运动矢量的仿射变换模型,将背景的地面运动矢量代入模型进行参数估计;最后,运动补偿图像计算完成后,通过帧间差分得到运动目标检测结果。实验效果表明,该方法消除了目标点对全局运动估计的影响[69]。

背景减除法方面,2020年,天津理工大学与南非大学联合团队Dong Enzeng等人提出一种适用于相机运动的运动目标检测方案,该算法首先采用高斯混合模型算法对背景模型进行初始化,然后采用KLT特征跟踪器检测相邻两帧的光流特征点,采用RAN-SAC算法过滤正确的匹配点,从而得到一个单应矩阵,以此构建新的背景模型匹配当前帧,使用新的背景模型即可检测当前帧的移动目标。

同年,印度尼西亚Faculty of Computer Science Dian Nuswantoro University的Moch Arief Soeleman等人提出一种自适应阈值,用以改进混合高斯模型的运动检出效果。该方法首先对视频数据集进行帧分解,然后采用高斯混合模型、Otsu阈值和灰度阈值并行构成自适应阈值从视频数据集中提取前景,下面对帧中的二进制运动目标进行形态学运算,直到检测到运动目标[70]。

2022年,武汉大学与清华大学团队的Cai Enjian等人提出一种基于颜色压缩和空间加权广义的混合高斯模型优化方法,该方法利用图像的先验信息进行相位估计,采用基于斑块组的高斯混合模型学习算法(PG-GMM)对训练图像进行非局部自相似(NSS)先验学习;然后利用学习到的先验补丁组对相位信息进行建模,并采用高斯分量选择和加权稀疏编码的方法对相位信息进行优化[71]。

ViBe法方面,2022年,河北科技大学Wang Shuhai团队提出一种基于多帧结合自适应阈值的ViBe改进方法,该方法首先将ViBe算法的样本集扩展到24个字段,减少像素误分类的可能性;其次,引入历史像素队列,得到初始化的无鬼背景模型;最后,利用灰度特征收敛性和发散性动态调整距离判定阈值,通过两个自适应更新因子,优化背景模型的更新速率。改进算法在静止、运动背景下均可以较为精确地检出目标,提高了算法检测精度与鲁棒性[72]。

同年,北京工业大学Song Baoyu等人提出一种改进的双背景模型ViBe算法,解决了传统ViBe算法检测过程中容易出现的“鬼影”问题。首先,算法利用像素的时间特征,为每个像素添加时间背景模型;其次,改进原始背景模型,通过比较帧间的汉明距离实现双背景模型的共存;再次,改进前景检测的决策机制,利用当前像素与时间背景模型样本中值之间的欧氏距离来补充决策;最后,设计一种交叉更新策略,对双背景模型进行快速更新。实验结果表明,改进算法可以较好地抑制传统ViBe算法产生的鬼影现象 [73]。

-

通过同其他图像处理算法融合的方式,可以利用其他算法的技术优势,弥补目标大气扰动图像处理算法的局限性,提升算法检出精度、增强鲁棒性等。

光流法方面,2022年,Ladoke Akintola科技大学与Kwara State Polytechnic大学的Adegbola等人提出一中利用Canny边缘检测技术进行光流优化的方法。该团队提出一种基于上下文滤波与多尺度边缘跟踪相结合的边缘提取方法,首先在精细图像中寻找边缘,再在粗糙图像中跟踪边缘,可以减少噪声和模糊的影响,消除破碎边缘问题[74]。

帧间差分法方面,2022年, Zheng Dingchao等人提出一种结合光流法的帧间差分优化方法。首先,采用自适应中值滤波和直方图均衡化算法对图像进行预处理;其次,对预处理后的图像进行两两序列差分处理,并计算差分结果之和;最后,利用光流法对差分视频序列进行处理,实现对运动目标的准确检测和识别。实验结果表明,该算法前景目标检测准确率优于88%,检测错误率低于2%。

背景减除法方面,2022年,济南大学的 Liu Jianting提出一种利用像素漂移去噪算法对混合高斯模型进行优化的方法,该方法主要利用像素漂移去噪算法对图像帧中发生的灰度漂移进行去噪处理,以提高混合高斯模型对前景目标提取的效果。该优化方法可以较为有效地抑制图像中的噪声,提高混合高斯模型的检出准确性与灵敏度。

同年,安徽工程大学与河南工业大学联合团队的Zhang Qian等人提出一种基于多帧差分法的ViBe改进方法。首先,将第一帧图像初始化背景模型替换为多帧连续图像初始化背景模型;其次,采用改进的ViBe算法和自适应动态阈值五帧差分算法对运动目标进行检测,并对二者得到的二值前景图像进行逻辑“或”操作进行检测,消除光干扰下运动目标的阴影,实现对运动目标的精确检测。该算法具有一定优化效果,证明该优化路线具有合理性,可以为后续ViBe算法的优化提供技术借鉴[75]。

-

近年来,深度学习算法已经成为机器学习领域应用的主流模型,其中,卷积神经网络等神经网络在图像等数据对象的智能检测、识别应用中效果尤其突出,已经成为最主要的深度神经网络模型之一。随着精确感知和高精度识别任务需求的不断增长,将现有目标大气扰动图像处理方法同神经网络融合以提升算法性能的技术方向具有巨大潜力。

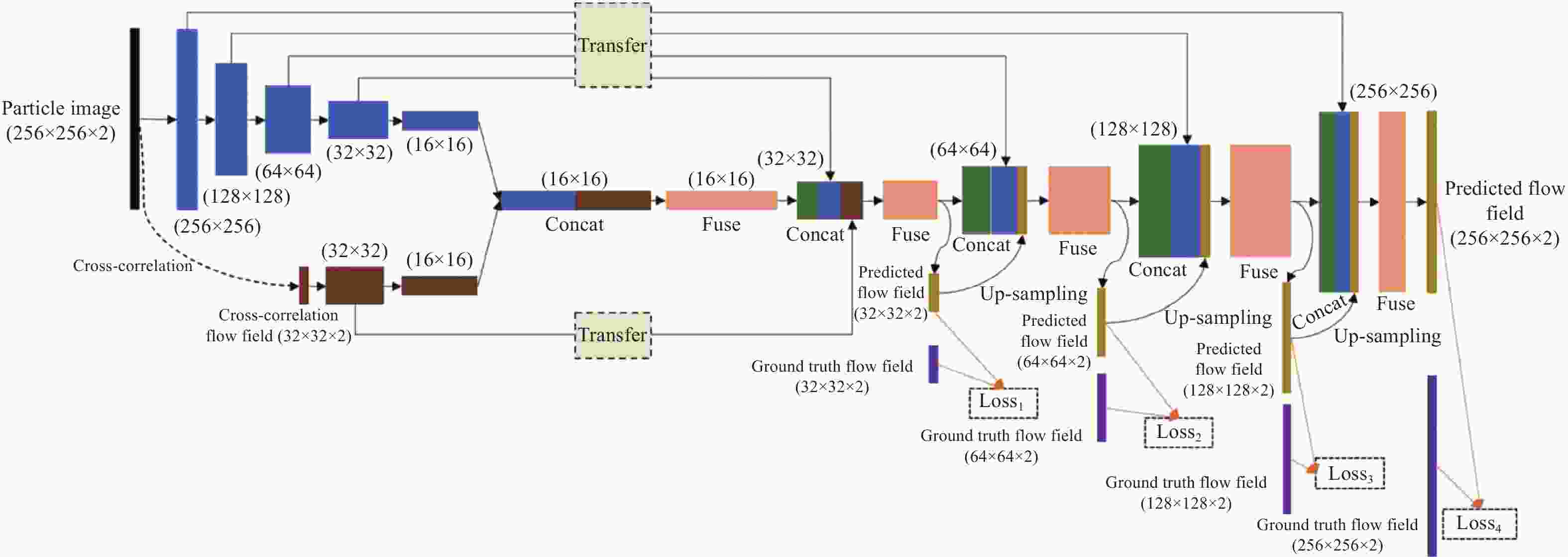

在互相关法方面,2021年,浙江大学高琪等人提出一种基于嵌入互相关的全卷积网络运动估计方法(图5),该方法利用互相关和完全卷积网络相互结合,利用图像与互相光求取的速度场作为完全卷积神经网络的输入层,通过两个金字塔模块分别对图像和速度场进行特征提取;其次,通过融合模块对特征进行融合;最后,通过一系列反卷积层实现速度精确求取。实验结果表明,该算法计算速度的偏零误差最小,检出精度最高可达百分之一个像素[76]。

图 5 基于嵌入互相关的全卷积网络运动估计方法基本流程图

Figure 5. Basic flow chart of motion estimation method for full convolutional networks based on embedded cross-correlation

光流法方面,2021年,中国电子科技大学的 Liu Shuaicheng等人提出一种基于无监督学习的遮挡修复光流估计方法,用以解决遮挡区域的光流估计问题,该团队提出一个遮挡修复框架,即一种新的外观流网络来修复基于图像内容的遮挡流。同时,该团队还提出了一种利用边界扩张扭曲来处理有超出图像边界位移引起的遮挡[77]。

同年,亚琛工业大学与剑桥大学团队的Lagemann Christian等人提出一种基于深度神经网络的方法,采用端到端的方式进行学习,以此来优化光流法的性能。该团队利用循环全对场变换(RAFT)的光流学习神经网络架构实现深度学习。实验结果表明,该算法具有较高的准确性,优于目前的有监督与无监督算法 [78]。如图6所示。

帧间差分法方面,2021年,武汉大学Mei Meng-qing等人针对缓动目标的提取,提出一种基于多标记学习和高斯背景描述模型的新型目标检测方法,同多帧差分法融合,以优化多帧差分法的性能。实验结果表明,该算法在检出成功率与检出精度方面具有明显的优化效果[79]。

同年, Zhang Xueliang团队利用机器学习对基于帧间差分法的运动目标检出方法进行优化研究。首先,利用四帧间差分法和背景平均法的融合算法改进帧间差分法和背景差分法的不足;其次,该融合算法利用机器学习方式实时更新背景,结合形态学处理对前景进行校正,可以有效地应对背景的缓慢变化。通过与最新研究成果对比,该算法的效率与准确性提高了近5% [80]。

背景减除法方面,2022年,上海交通大学的Wei Dong等人提出一种基于深度学习的全局-局部特征融合的ViBe优化方法,该方法主要分为预处理、提取前景目标、对目标进行回归与分类、合并分支结果四个步骤。该算法对吉林-1号卫星数据中的车辆检测效果较好,性能较好[81]。见图7。

-

根据上述各方向的研究成果,可做出如下总结,如表2所示。根据表2可以看出:互相关法方面,目前学者的主要研究方向集中于对互相关算法自身进行优化,以及同神经网络进行融合,对于互相关算法同其他图像处理算法进行融合方面的研究较少;针对算法自身的研究中,学者主要集中对互相关算法中特征提取与跟踪方法的优化研究,以提升算法性能,且效果较为明显。对于融合神经网络方面,基于神经网络的互相关算法性能提升明显,发展前景广阔。

表 2 各类目标大气扰动检测图像处理方法发展情况

Table 2. Development of image processing methods for atmospheric disturbance detection of various targets

Method Optimization algorithm itself Fusion with other image processing algorithms Neural network-based Cross-correlation

method●Autonomous velocity measurement and positioning technology based on improved optical flow algorithm[18]

●Pyramidal implementation of the affine lucas kanade feature tracker description of the algorithm[21]

●Phase-based disparity measurement[20]An investigation of smoothness constraints for the estimation of displacement vector fields from image sequences[19] Optical flow method ●Moving target detection algorithm based on Susan edge detection and frame difference[39] ●Moving object detection based on frame difference and W4[41] ●Object tracking in satellite videos by fusing the kernel correlation filter and the three-frame-difference algorithm[40]

●Moving target detection using inter-frame difference methods combined with texture features and lab color space[42]Interframe difference method ●A ship target image recognition method based on inter-frame difference algorithm[35] ●Underwater object detection based on bi-dimensional empirical mode decomposition and Gaussian mixture model approach[55] ●Optimal transport for Gaussian mixture models[53]

●Moving target detection based on improved Gaussian mixture model considering camera motion[54]Background subtraction Mixed Gaussian model ●An improved vibe algorithm of dual background model for quickly suppressing ghost images[73]

●Detection and tracking of a moving object using Canny edge and optical flow techniques[74]

●Deep learning-driven gaussian modeling and improved motion detection algorithm of the three-frame difference method●Application of pixel drift denoising algorithm in optimizing Gaussian mixture model ViBe method ●A robust single-pixel particle image velocimetry based on fully convolutional networks with cross-correlation

embedded [76]

●Deep recurrent optical flow learning for particle image velocimetry data[78]●Oiflow: Occlusion-inpainting optical flow estimation by unsupervised learning[77] ●An improved ViBe method for motion target detection[75] 光流法方面,对于光流法自身的优化研究,主要集中于对于光流法特征点求取与跟踪方面的优化;对于同其他图像处理方法进行融合方面的研究较多,如边缘检测同光流法融合、帧间差分法同光流法融合等,效果较好;对于融合神经网络方面,目前研究较为深入,已有较为成熟的光流网络,如FlowNet1.0、Flow-Net2.0等,已取得了较好的研究效果。

帧间差分法方面,对于帧间差分法自身的优化研究,主要针对消除背景对于算法检出效果的影响方面,如提升帧间差分法在动态背景下的检出能力等;对于同其他图像处理方法进行融合方面,相关研究较多,如帧间差分法同光流法融合、帧间差分法同ViBe法融合等;对于融合神经网络方面,目前相关研究同样为利用神经网络减少背景目标对于前景目标的影响,增强前景目标检出能力方面。

背景减除法方面,对于背景减除法自身的优化研究,主要为两个方面,一是优化模型更新策略,二是优化前景与背景目标分割阈值,以此进行背景减除法的优化;对于同其他图像处理方法进行融合方面,学者们同样进行了广泛的研究,如利用去噪算法同背景减除法进行融合、利用互相关算法同背景减除法进行融合等,取得了一定的效果;对于融合神经网络方面,由于混合高斯模型自身为聚类算法,属于机器学习的范畴,故国内外学者并未对此算法同神经网络融合深入研究;对于ViBe法,研究主要集中于利用神经网络对前景目标与背景目标进行区分方面,取得了一定效果。

通过分析可知上述三种发展方向的优缺点(表3)。

表 3 三种发展方向优缺点分析

Table 3. Analysis of advantages and disadvantages of three development directions

Item Optimization algorithm itself Fusion with other image processing algorithms Neural network-based Advantage The algorithm has the advantages of low complexity, fast operation speed and good real-time performance The method can make up for their own technological limitations, can be used to achieve better performance, and better robustness The algorithm performance can be greatly improved, and the algorithm has strong adaptability in multiple scenarios. Disadvantage It is difficult to eliminate the technical limitations of the algorithm, and the robustness of the algorithm is generally low Increase algorithm complexity, reduce operational efficiency, real-time performance is poor Large amount of prior information is required for model construction and the operation speed is low -

通过分析可知各类传统大气扰动目标检测图像处理方法的优缺点,具体见表4。

表 4 各类高精度大气扰动目标探测图像处理方法比较表

Table 4. Comparison of various high-precision image processing methods for atmospheric disturbance target detection

Performance Cross-correlation method Optical flow method Interframe difference method Background subtraction Detection effect The sparse flow field information of target atmospheric disturbance can be obtained, but the detailed description ability is insufficient More detailed information about atmospheric disturbance can be obtained, such as the motion vector in the x and y directions Only the shape and contour information of atmospheric disturbance can be obtained, and the ability to obtain details is poor To obtain the shape and contour information of atmospheric disturbance, more detail information is lost Disturbance inhibition ability Undisturbed background suppression capability Undisturbed background suppression capability Undisturbed background suppression capability Have ability to disturbance background suppression Algorithm complexity With Fourier change, the algorithm has some complexity It needs to use the least square method or other algorithms to obtain the approximate solution, and the algorithm complexity is high The gray difference between two frames is calculated, and the algorithm is simple Need to build background model algorithm complexity Algorithm applicability Best Best Good Poor Real-time performance Best Poor Best Good Advantage Simple calculation and high real-time performance High detection accuracy, complete target, can adapt to the background movement to a certain extent Simple calculation and high real-time performance High detection accuracy, complete target and small amount of calculation Disadvantage Reduced resolution and poor robustness to disturbance The calculation is complex, the calculation error of target contour is large, and the robustness to disturbance is poor Easy to produce "void", poor robustness to disturbance It is not universal to the environment and its robustness to disturbance is poor 根据表4可以看出:

1)互相关算法具有较高的实时性与实用性,但该算法会降低图像分辨率,对扰动的鲁棒性差;

2)光流算法有较好的算法适用性以及一定的运动背景适应能力,但其计算复杂,实时性差,且目标轮廓计算误差较大,对扰动的鲁棒性差;

3)帧间差算法具有较好的实时性与实用性,但该算进行大气扰动检出时容易产生“空洞”,而且同样对扰动的鲁棒性较差;

4)背景减除法具有较高的检测精度,具有一定的抑制扰动的能力,但该算法实时性较差、鲁棒性同样较差,对环境的适应性不强。

根据上述分析可知,现阶段对于基于大气扰动的目标探测技术在实际应用中对算法提出的高精度、高鲁棒性以及高实时性需求,传统的目标大气扰动图像处理方法不能同时满足要求,故需对传统大气扰动目标探测图像处理方法进行优化。

-

根据各类目标大气扰动图像处理方法的优缺点,结合上述对于目标大气扰动图像处理方法的三种发展方向的对比分析可知:

利用其他算法对大气扰动目标检测图像处理方法进行优化的方法,同样适用于每一种大气扰动目标检测图像处理方法,适用性较强,且可以利用其他算法的优势弥补被优化方法的局限,如帧间差分法结合光流法提升大气扰动目标检测图像处理效果等,该种技术途径可以较好地满足实际应用中对算法的高精度、高鲁棒性的要求。针对该方法会增加算法复杂程度,降低实时性方面,可以采用硬件实现的方式加快运算速率,解决实时性问题,故现阶段该方法有望满足基于大气扰动的目标检测技术在实际应用中的需求,具有发展前景。

除此之外,神经网络具有可以自我学习的特点,可以实现自适应的优化方式,是一种极具应用前景的大气扰动目标检测图像处理方法的优化方法;该方法具有自我学习能力,可以实现自适应的功能,故其对多场景图片的适用性也较强,检出效果也非常好;但其缺陷在于,算法运算效率较慢,且有监督学习需要大量样本,但实际应用中一般不存在大量的先验信息,而无监督学习现阶段检出精度受限,不满足实际应用需求。

但面向未来而言,利用小样本无监督学习的大气扰动目标检测图像处理方法有望在满足算法实时性的基础上实现更高精度、更高鲁棒性的目标大气扰动图像处理方法,具有巨大的应用前景,将会是未来发展的主流方向。

-

文中首先介绍目标大气扰动探测的基本原理,在此基础上对各类目标大气扰动处理方法基本原理以及发展现状进行了介绍,主要对于在各类目标大气扰动检测方法领域内国内外学者所做的最近进展进行了详细阐述,总结各类目标大气扰动处理方法的发展方向。此外,对于目标大气扰动图像处理方法的优缺点进行了分析,分析现阶段目标大气扰动图像处理方法于实际应用中存在的问题:目前,互相关算法会降低图像分辨率,对扰动的鲁棒性差;光流算法计算复杂,实时性差,且目标轮廓计算误差较大,对扰动的鲁棒性差;帧间差算法进行大气扰动检出时容易产生“空洞”,而且同样对扰动的鲁棒性较差;背景减除法实时性、鲁棒性较差,对环境的适应性不强等。

基于上述问题,根据国内外目标大气扰动图像处理方法的研究进展,总结出目标大气扰动图像处理方法未来的发展方向,并结合实际需求,给出工程应用建议:现阶段需着力发展利用其他算法对大气扰动目标检测图像处理方法进行优化的技术方向;未来基于小样本无监督学习的大气扰动目标检测图像处理方法具有巨大的应用前景。

A review of image processing methods in target atmospheric disturbance detection

-

摘要: 世界各国目标信息获取与应用需求日益迫切,各国纷纷着力开展新型的目标信息获取技术研究,针对各类目标,尤其是对空中目标进行高效信息获取。在现今的信息化社会中,新型信息获取技术意义重大,可以促进社会发展、提升人民生活水平,同时在完善国防体系,保障国民安全方面也作用显著。因此,对新型目标信息获取技术的研究十分必要。基于大气扰动的目标探测技术作为一种新型的信息获取技术体制,利用目标飞行时形成的大气扰动进行目标探测具有不受目标自身性能影响的显著优势,应用潜力巨大。此篇综述基于大气扰动的目标探测技术,对目标大气扰动检测中图像处理方法进行研究,主要分为互相关方法、光流方法、帧间差分法、背景减除法四个方面,阐述其国内外研究进展,分析其技术优劣势及发展技术途径,最后对四种方法以及目标大气扰动图像处理方法未来的发展方向进行展望与总结。Abstract:

Significance The demand of target information acquisition and application is becoming more and more urgent all over the world, and all countries are focusing on the research of new target information acquisition technology, especially for all kinds of targets, especially for air targets. In today's information society, the new information acquisition technology is of great significance, which can promote social development and improve people's living standards, and also play a significant role in improving the national defense system and ensuring national security. Therefore, it is necessary to study the new target information acquisition technology. Target detection technology based on atmospheric disturbance is a new information acquisition technology system. The use of atmospheric disturbance in target detection is not affected by the performance of the target itself, and has great application potential. Progress In this paper, four main image processing algorithms of target atmospheric disturbance detection are introduced, which are cross-correlation method, optical flow method, frame difference method and background detection method. The technical principle is described and the technical advantages and disadvantages are analyzed (Tab.4). The cross-correlation algorithm has good real-time performance, but will reduce the resolution; The optical flow method has high precision but poor real-time performance. Inter-frame difference method has good real-time performance, but poor accuracy and applicability. Background detection method has good accuracy and poor applicability. According to the development status of the four algorithms at home and abroad, through comprehensive research, the optimization methods of various algorithms are analyzed and summarized, which can be divided into three categories (Tab.2) of optimization algorithm itself, integration with other image processing algorithms, and neural network based. Through the analysis of relevant literature, the advantages and disadvantages of the three algorithm optimization methods are revealed (Tab.3). The optimization algorithm itself has low complexity and can achieve high real-time performance, but limited by the basic principles of the algorithm, the optimization effect is not obvious; The method of fusion with other image processing algorithms can make up for the technical limitations of the algorithm, achieve high performance and high robustness, but the complexity of the algorithm increases, and the real-time performance is affected. The optimization method based on neural network can greatly improve the algorithm performance and achieve high adaptability, but it requires a lot of prior information and has poor real-time performance. Based on this, the four methods and the future development direction of target atmospheric disturbance image processing are prospected and summarized. Conclusions and Prospects Based on the analysis and summary of the research progress of target atmospheric disturbance image processing methods at home and abroad, the optimization method of image processing algorithm in target atmospheric disturbance detection is given as follows. At present, it is necessary to develop the technical direction of optimizing the image processing methods of atmospheric disturbance target detection by using other algorithms, such as inter-frame difference method combined with optical flow method, and overall optimization of multiple target atmospheric disturbance algorithms by using machine learning technology. Facing the future, the image processing method of atmospheric disturbance target detection based on small sample unsupervised learning has great application prospect. -

Key words:

- atmospheric disturbance /

- image processing methods /

- target detection

-

表 1 各类目标大气扰动图像处理方法局限性

Table 1. Limitations of various target atmospheric disturbance image processing methods

Image processing method of target atmospheric disturbance Limitation Cross-correlation method The resolution of processing results is reduced, the calculation accuracy is poor, the detection effect is easily affected by the characteristics of flow field and environmental noise, and the application is limited in complex environment Optical flow method The calculation complexity is high, the timeliness is poor, and it is easy to fall into the local optimal value. When the illumination conditions change, there are occlusions, and the target moves locally, the detection effect is poor, and the application is limited Interframe difference method The ability of complete extraction of target information is poor, and the phenomenon of missing detection and "void" is easy to occur. The calculation accuracy is poor, and the detection effect is poor under the moving background or when the background changes dramatically Background subtraction Mixed Gaussian model Prior information is required to build the background model, which has low operational efficiency and limited application when the background changes dramatically ViBe method The background model construction method is relatively simple with large error, resulting in poor calculation accuracy. Also, due to the background model, its application is limited in the scene with drastic changes in the background environment 表 2 各类目标大气扰动检测图像处理方法发展情况

Table 2. Development of image processing methods for atmospheric disturbance detection of various targets

Method Optimization algorithm itself Fusion with other image processing algorithms Neural network-based Cross-correlation

method●Autonomous velocity measurement and positioning technology based on improved optical flow algorithm[18]

●Pyramidal implementation of the affine lucas kanade feature tracker description of the algorithm[21]

●Phase-based disparity measurement[20]An investigation of smoothness constraints for the estimation of displacement vector fields from image sequences[19] Optical flow method ●Moving target detection algorithm based on Susan edge detection and frame difference[39] ●Moving object detection based on frame difference and W4[41] ●Object tracking in satellite videos by fusing the kernel correlation filter and the three-frame-difference algorithm[40]

●Moving target detection using inter-frame difference methods combined with texture features and lab color space[42]Interframe difference method ●A ship target image recognition method based on inter-frame difference algorithm[35] ●Underwater object detection based on bi-dimensional empirical mode decomposition and Gaussian mixture model approach[55] ●Optimal transport for Gaussian mixture models[53]

●Moving target detection based on improved Gaussian mixture model considering camera motion[54]Background subtraction Mixed Gaussian model ●An improved vibe algorithm of dual background model for quickly suppressing ghost images[73]

●Detection and tracking of a moving object using Canny edge and optical flow techniques[74]

●Deep learning-driven gaussian modeling and improved motion detection algorithm of the three-frame difference method●Application of pixel drift denoising algorithm in optimizing Gaussian mixture model ViBe method ●A robust single-pixel particle image velocimetry based on fully convolutional networks with cross-correlation

embedded [76]

●Deep recurrent optical flow learning for particle image velocimetry data[78]●Oiflow: Occlusion-inpainting optical flow estimation by unsupervised learning[77] ●An improved ViBe method for motion target detection[75] 表 3 三种发展方向优缺点分析

Table 3. Analysis of advantages and disadvantages of three development directions

Item Optimization algorithm itself Fusion with other image processing algorithms Neural network-based Advantage The algorithm has the advantages of low complexity, fast operation speed and good real-time performance The method can make up for their own technological limitations, can be used to achieve better performance, and better robustness The algorithm performance can be greatly improved, and the algorithm has strong adaptability in multiple scenarios. Disadvantage It is difficult to eliminate the technical limitations of the algorithm, and the robustness of the algorithm is generally low Increase algorithm complexity, reduce operational efficiency, real-time performance is poor Large amount of prior information is required for model construction and the operation speed is low 表 4 各类高精度大气扰动目标探测图像处理方法比较表

Table 4. Comparison of various high-precision image processing methods for atmospheric disturbance target detection

Performance Cross-correlation method Optical flow method Interframe difference method Background subtraction Detection effect The sparse flow field information of target atmospheric disturbance can be obtained, but the detailed description ability is insufficient More detailed information about atmospheric disturbance can be obtained, such as the motion vector in the x and y directions Only the shape and contour information of atmospheric disturbance can be obtained, and the ability to obtain details is poor To obtain the shape and contour information of atmospheric disturbance, more detail information is lost Disturbance inhibition ability Undisturbed background suppression capability Undisturbed background suppression capability Undisturbed background suppression capability Have ability to disturbance background suppression Algorithm complexity With Fourier change, the algorithm has some complexity It needs to use the least square method or other algorithms to obtain the approximate solution, and the algorithm complexity is high The gray difference between two frames is calculated, and the algorithm is simple Need to build background model algorithm complexity Algorithm applicability Best Best Good Poor Real-time performance Best Poor Best Good Advantage Simple calculation and high real-time performance High detection accuracy, complete target, can adapt to the background movement to a certain extent Simple calculation and high real-time performance High detection accuracy, complete target and small amount of calculation Disadvantage Reduced resolution and poor robustness to disturbance The calculation is complex, the calculation error of target contour is large, and the robustness to disturbance is poor Easy to produce "void", poor robustness to disturbance It is not universal to the environment and its robustness to disturbance is poor -

[1] Tang Hongchen, Xu Peng, Ruan Ningjuan, et al. Detection of hypersonic moving point target [J]. Spacecraft Recovery & Remote Sensing, 2018, 39(6): 46-54. (in Chinese) [2] Li Xiaobin, Jiang Bintao, Yang Yuanbo et al. A survey on obj- ect detection technology in optical remote sensing images [J]. Spacecraft Recovery & Remote Sensing, 2019, 40(4): 95-104. (in Chinese) [3] Zhang Zhengzhou, Gao Kun, Li Wei, et al. A survey on the optical remote sensing image super-resolution technology [J]. Spacecraft Recovery & Remote Sensing, 2020, 41(6): 21-33. (in Chinese) doi: 10.3969/i.issn.1009-8518.2020.06.003 [4] Chen Bo, Li Wanping. Error compensation for sub-pixel displacement estimation in cross-correlation particle image velocimetry(PIV) [J]. Journal of Computer—Aided Design & Computer Graphics, 2011, 23(11): 1896-1901. (in Chinese) [5] Wang Tian. Research on particle image velocity measurement technology based on PIV/PTV hybrid algorithm [D]. Nanjing: Nanjing University of Science and Technology, 2017. (in Chinese) [6] Zahiri-Azar R, Salcudean S E. Motion estimation in ultrasound images using time domain cross correlation with prior estimates [J]. IEEE Transactions on Biomedical Engineering, 2006, 53(10): 1990-2000. doi: 10.1109/TBME.2006.881780 [7] Eng J K, Fischer B, Grossmann J, et al. A fast SEQUEST cross correlation algorithm [J]. Journal of Proteome Research, 2008, 7(10): 4598-4602. doi: 10.1021/pr800420s [8] Yoo J C, Han T H. Fast normalized cross-correlation [J]. Circuits, Systems and Signal Processing, 2009, 28(6): 819-843. doi: 10.1007/s00034-009-9130-7 [9] Luo J, Konofagou E E. A fast normalized cross-correlation calculation method for motion estimation [J]. IEEE Transactions on Ultrasonics, Ferroelectrics, and Frequency Control, 2010, 57(6): 1347-1357. doi: 10.1109/TUFFC.2010.1554 [10] Chang C Y, Ma C C. Increasing the computational efficient of digital cross correlation by a vectorization method [J]. Mechanical Systems and Signal Processing, 2017, 92: 293-314. doi: 10.1016/j.ymssp.2017.01.027 [11] Hijazi B, Vangeyte J, Cointault F, et al. Two-step cross correlation-based algorithm for motion estimation applied to fertilizer granules' motion during centrifugal spreading [J]. Optical Engineering, 2011, 50(6): 067002. doi: 10.1117/1.3582859 [12] Xavier J, Sousa A M R, Morais J J L, et al. Measuring displacement fields by cross-correlation and a differential technique: experimental validation [J]. Optical Engineering, 2012, 51(4): 043602. doi: 10.1117/1.OE.51.4.043602 [13] Shi B, Wei J, Pang M. A modified cross-correlation algorithm for PIV image processing of particle-fluid two-phase flow [J]. Flow Measurement and Instrumentation, 2015, 45: 105-117. doi: 10.1016/j.flowmeasinst.2015.06.010 [14] Wang J, Huang X, Liu H, et al. Fluorescence and scattering light cross correlation spectroscopy and its applications in homogeneous immunoassay [J]. Analytical Chemistry, 2017, 89(10): 5230-5237. doi: 10.1021/acs.analchem.6b04547 [15] Tekwani H, Raj K. Role of pattern characteristics in cross correlation based motion estimation [J]. Indian Journal of Science and Technology, 2021, 14(41): 3114-3125. doi: 10.17485/IJST/v14i41.1137 [16] Sahu S, Adhikari G, Dey R K. Tracking of object with occlusion based on normalized cross correlation and kalman filter estimation[C]//2021 2nd International Conference on Range Technology (ICORT). IEEE, 2021: 1-5. [17] Li M, Zhou C, Li B, et al. Application of the combined feature tracking and maximum cross-correlation algorithm to the extraction of sea ice motion data from GF-3 imagery [J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 3390-3402. doi: 10.1109/JSTARS.2022.3166897 [18] Wei Jiaqi. Autonomous velocity measurement and positioning technology based on improved optical flow algorithm[D]. Taiyuan: North University of China, 2022. (in Chinese) [19] Nagel H H, Enkelmann W. An investigation of smoothness constraints for the estimation of displacement vector fields from image sequences [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, 8(5): 565-593. doi: 10.1109/TPAMI.1986.4767833 [20] Fleet D J, Jepson A D, Jenkin M R M. Phase-based disparity measurement [J]. CVGIP: Image understanding, 1991, 53(2): 198-210. doi: 10.1016/1049-9660(91)90027-M [21] Bouguet J Y. Pyramidal implementation of the affine lucas kanade feature tracker description of the algorithm[EB/OL]. [2023-02-01]. https://robots.stanford.edu/cs223b04/algo_track-ing.pdf. [22] Sundberg P, Brox T, Maire M, et al. Occlusion boundary detection and figure/ground assignment from optical flow[C]//CVPR 2011. IEEE, 2011: 2233-2240. [23] Volz S, Bruhn A, Valgaerts L, et al. Modeling temporal coherence for optical flow[C]//2011 International Conference on Computer Vision. IEEE, 2011: 1116-1123. [24] Sundaram N, Brox T, Keutzer K. Dense point trajectories by gpu-accelerated large displacement optical flow[C]//European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2010: 438-451. [25] Sun D, Roth S, Black M J. A quantitative analysis of current practices in optical flow estimation and the principles behind them [J]. International Journal of Computer Vision, 2014, 106(2): 115-137. doi: 10.1007/s11263-013-0644-x [26] Hu Y, Song R, Li Y. Efficient coarse-to-fine patchmatch for large displacement optical flow[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 5704-5712. [27] Maurer D, Bruhn A. Proflow: Learning to predict optical flow[EB/OL]. (2018-06-03)[2023-02-01]. https://arxiv.org/abs/1806.00800. [28] Yin Z, Shi J. Geonet: Unsupervised learning of dense depth, optical flow and camera pose[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 1983-1992. [29] Chen H, Ye S, Nedzvedz A, et al. Traffic extreme situations detection in video sequences based on integral optical flow [J]. Компьютерная Oптика, 2019, 43(4): 647-652. doi: https://doi.org/10.18287/2412-6179-2019-43-4-647-652 [30] Hur J, Roth S. Iterative residual refinement for joint optical flow and occlusion estimation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 5754-5763. [31] Fischer P, Dosovitskiy A, Ilg E, et al. FlowNet: Learning optical flow with convolutional networks[EB/OL]. (2015-04-26)[2023-02-01]. https://arxiv.org/abs/1504.06852. [32] Ilg E, Mayer N, Saikia T, et al. Flownet 2.0: Evolution of optical flow estimation with deep networks[C]//Proceedings of the IEEE Conference on Computer Vision And Pattern Recognition, 2017: 2462-2470. [33] Sun D, Yang X, Liu M Y, et al. PWC-Net: CNNs for optical flow using pyramid, warping, and cost volume[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8934-8943. [34] Hofinger M, Bulò S R, Porzi L, et al. Improving optical flow on a pyramid level[C]//European Conference on Computer Vision. Cham: Springer, 2020: 770-786. [35] Zhao S, Sheng Y, Dong Y, et al. Maskflownet: Asymmetric feature matching with learnable occlusion mask[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 6278-6287. [36] Wang Huasong, Jia Haiyan. A ship target image recognition method based on inter-frame difference algorithm [J]. Infrared, 2020, 41(5): 45-48. (in Chinese) [37] Yin H, Chai Y, Yang S X, et al. Fast-moving target tracking based on mean shift and frame-difference methods [J]. Journal of Systems Engineering and Electronics, 2011, 22(4): 587-592. doi: 10.3969/j.issn.1004-4132.2011.04.006 [38] Zhang Y, Wang X, Qu B. Three-frame difference algorithm research based on mathematical morphology [J]. Procedia Engineering, 2012, 29: 2705-2709. doi: 10.1016/j.proeng.2012.01.376 [39] Fan X, Cheng Y, Fu Q. Moving target detection algorithm based on Susan edge detection and frame difference[C]//2015 2nd International Conference on Information Science and Control Engineering. IEEE, 2015: 323-326. [40] Du B, Sun Y, Cai S, et al. Object tracking in satellite videos by fusing the kernel correlation filter and the three-frame-difference algorithm [J]. IEEE Geoscience and Remote Sensing Letters, 2017, 15(2): 168-172. [41] Sengar S S, Mukhopadhyay S. Moving object detection based on frame difference and W4 [J]. Signal, Image and Video Processing, 2017, 11(7): 1357-1364. doi: 10.1007/s11760-017-1093-8 [42] Gao F, Lu Y. Moving target detection using inter-frame difference methods combined with texture features and lab color space[C]//2019 International Conference on Artificial Inte-lligence and Advanced Manufacturing (AIAM). IEEE, 2019: 76-81. [43] Shang L, You F, Wang S. Improved five-frame difference method and optimized update rate for codebook target detection[C]//2019 IEEE International Conference on Power, Intelligent Computing and Systems (ICPICS). IEEE, 2019: 324-328. [44] Ou X, Yan P, Wang H, et al. Research of moving object detection based on deep frame difference convolution neural network [J]. Acta Electonica Sinica, 2020, 48(12): 2384-2393. doi: 10.3969/j.issn.0372-2112.2020.12.014 [45] Zheng D, Zhang Y, Xiao Z. Deep learning-driven Gaussian modeling and improved motion detection algorithm of the three-frame difference method [J]. Mobile Information Systems, 2021, 2021: 9976623. doi: 10.1155/2021/9976623 [46] Ding Q, Chen J, Shen M, et al. Activity detection of suckling piglets based on motion area analysis using frame differences in combination with convolution neural network [J]. Computers and Electronics in Agriculture, 2022, 194: 106741. doi: 10.1016/j.compag.2022.106741 [47] Li Zhizhong. Research on moving objects detection based on background subtraction [D]. Tianjin: Civil Aviation University of China, 2015. (in Chinese) [48] Li W, Prasad S, Fowler J E. Hyperspectral image classification using Gaussian mixture models and Markov random fields [J]. IEEE Geoscience and Remote Sensing Letters, 2013, 11(1): 153-157. doi: 10.1109/LGRS.2013.2250905 [49] Li B, Bruyneel L, Lesaffre E. A multivariate multilevel Gaussian model with a mixed effects structure in the mean and covariance part [J]. Statistics in Medicine, 2014, 33(11): 1877-1899. doi: 10.1002/sim.6062 [50] Ji Z, Huang Y, Xia Y, et al. A robust modified Gaussian mixture model with rough set for image segmentation [J]. Neurocomputing, 2017, 266: 550-565. doi: 10.1016/j.neucom.2017.05.069 [51] Martins I, Carvalho P, Corte-real L, et al. BMOG: boosted Gaussian mixture model with controlled complexity for background subtraction [J]. Pattern Analysis and Applications, 2018, 21(3): 641-654. doi: 10.1007/s10044-018-0699-y [52] Panda D K, Meher S. Adaptive spatio-temporal background subtraction using improved Wronskian change detection scheme in Gaussian mixture model framework [J]. IET Image Processing, 2018, 12(10): 1832-1843. doi: 10.1049/iet-ipr.2017.0595 [53] Chen Y, Georgiou T T, Tannenbaum A. Optimal transport for Gaussian mixture models [J]. IEEE Access, 2018, 7: 6269-6278. doi: 10.1109/ACCESS.2018.2889838 [54] Dong E, Han B, Jian H, et al. Moving target detection based on improved Gaussian mixture model considering camera motion [J]. Multimedia Tools and Applications, 2020, 79(11): 7005-7020. [55] Mathias A, Dhanalakshmi S, Kumar R, et al. Underwater object detection based on bi-dimensional empirical mode decomposition and Gaussian Mixture Model approach [J]. Ecological Informatics, 2021, 66: 101469. doi: 10.1016/j.ecoinf.2021.101469 [56] Liu J. Application of pixel drift denoising algorithm in optimizing gaussian mixture model[C]//2022 2nd International Conference on Bioinformatics and Intelligent Computing, 2022: 457-464. [57] Pan X, Zheng Y, Jeon B. Robust segmentation based on salient region detection coupled Gaussian mixture model [J]. Information, 2022, 13(2): 98. doi: 10.3390/info13020098 [58] Guang H, Wang J, Xi C. Improved visual background extractor using an adaptive distance threshold [J]. Journal of Electronic Imaging, 2014, 23(6): 063005. doi: 10.1117/1.JEI.23.6.063005 [59] Wang H, Wang Q, Li Y, et al. An illumination-robust algorithm based on visual background extractor for moving object detection[C]//2015 10th Asian Control Conference (ASCC). IEEE, 2015: 1-6. [60] Yang Y, Zhang Q, Wang P, et al. Moving object detection for dynamic background scenes based on spatiotemporal model [J]. Advances in Multimedia, 2017, 2017: 5179013. doi: https://doi.org/10.1155/2017/5179013 [61] Zhao L L, Chen Y, Zou Y, et al. Shooting for smarter motion detection in cameras: improvements for the visual background extractor algorithm using optical flow [J]. IEEE Consumer Electronics Magazine, 2017, 6(4): 81-91. doi: 10.1109/MCE.2017.2715521 [62] Zhao D, Tan J, Yang W, et al. An improved VIBE algorithm for fast suppression of ghosts and static objects[C]//2018 IEEE International Conference on Mechatronics and Automation (ICMA). IEEE, 2018: 889-893. [63] Zuo J, Jia Z, Yang J, et al. Moving object detection in video sequence images based on an improved visual background extraction algorithm [J]. Multimedia Tools and Applications, 2020, 79(39): 29663-29684. [64] Yang M, Chu Q. Static scene target detection based on VIBE algorithm[C]//2021 2nd International Seminar on Artificial Intelligence, Networking and Information Technology (AINIT). IEEE, 2021: 169-174. [65] Liu K, Zhang J. Moving object detection based on improved ViBe algorithm[C]//Real-Time Image Processing and Deep Learning 2021. SPIE, 2021, 11736: 154-160. [66] Houhou I, Zitouni A, Ruichek Y, et al. Improving ViBe-based background subtraction techniques using RGBD information[C]//2022 7th International Conference on Image and Signal Processing and their Applications (ISPA). IEEE, 2022: 1-6. [67] Xie Z, Wang H, Xu D. Spatiotemporal optimization on cross correlation for particle image velocimetry [J]. Physics of Fluids, 2022, 34(5): 055105. doi: 10.1063/5.0091839 [68] Song T, Cao L B, Zhao M F, et al. Image tracking and matching algorithm of semi-dense optical flow method [J]. International Journal of Wireless and Mobile Computing, 2021, 20(1): 93-98. doi: 10.1504/IJWMC.2021.113228 [69] Guo Wenyue, Zheng Xin, He Wei, et al. Moving target detection based on patrol UAV[C]//2021 7th International Conference on Computing and Artificial Intelligence, 2021: 21-27. [70] Soeleman M A, Nurhindarto A, Muslih M, et al. Adaptive threshold for moving objects detection using gaussian mixture model [J]. TElkomnika (Telecommunication Computing Electronics and Control), 2020, 18(2): 1122-1129. doi: 10.12928/telkomnika.v18i2.14878 [71] Cai E, Zhang Y. Gaussian mixture model based phase prior learning for video motion estimation [J]. Mechanical Systems and Signal Processing, 2022, 175: 109103. doi: 10.1016/j.ymssp.2022.109103 [72] Wang S, Zhou Y, Bai F, et al. Improved ViBe algorithm based on multi-frame combined with adaptive threshold[C]//Journal of Physics: Conference Series. IOP Publishing, 2022, 2303(1): 012021. [73] Song B, Wang B. An improved vibe algorithm of dual background model for quickly suppressing ghost images[C]//International Conference on Neural Networks, Information, and Communication Engineering (NNICE). SPIE, 2022, 12258: 290-295. [74] Adegbola O A, Alabi A Z, Idowu P O, et al. Detection and tracking of a moving object using Canny edge and optical flow techniques [J]. Asian Journal of Research in Computer Science, 2022, 22(1): 43-56. doi: 10.9734/ajrcos/2022/v13i130306 [75] Zhang Q, Wei L, Li T. An improved ViBe method for motion target detection[C]//2022 2nd International Conference on Computer, Control and Robotics (ICCCR). IEEE, 2022: 258-262. [76] Gao Q, Lin H, Tu H, et al. A robust single-pixel particle image velocimetry based on fully convolutional networks with cross-correlation embedded [J]. Physics of Fluids, 2021, 33(12): 127125. doi: 10.1063/5.0077146 [77] Liu S, Luo K, Ye N, et al. Oiflow: Occlusion-inpainting optical flow estimation by unsupervised learning [J]. IEEE Transactions on Image Processing, 2021, 30: 6420-6433. doi: 10.1109/TIP.2021.3093781 [78] Lagemann C, Lagemann K, Mukherjee S, et al. Deep recurrent optical flow learning for particle image velocimetry data [J]. Nature Machine Intelligence, 2021, 3(7): 641-651. doi: 10.1038/s42256-021-00369-0 [79] Mei M, He F. Multi-label learning based target detecting from multi-frame data [J]. IET Image Processing, 2021, 15(14): 3638-3644. doi: 10.1049/ipr2.12271 [80] Zhang X L, Yang F Q. Machine learning-based multitarget tracking of motion in sports video [J]. Complexity, 2021, 2021: 5533884. doi: https://doi.org/10.1155/2021/5533884 [81] Wei D, Jing Z, Pan H. Moving vehicle detection in satellite video via background subtraction and global-local features fusion Faster R-CNN[C]//International Conference on Aerospace System Science and Engineering. Singapore: Springer, 2023: 197-210. -

下载:

下载: