HTML

-

在轨服务和空间攻防是未来航天重要发展方向,而目标的局部特征识别是关键技术之一。非合作目标上没有配合测量的光标、角反射器等设施,且目标的形状、局部特征各异,成像特性易受到空间光照条件变化的影响。这给目标识别以及进一步的抵近、绕飞、测量、捕获带来了巨大的挑战。

在空间对抗与在轨服务领域中,需要对非合作目标整星、帆板、支架、喷管、对接环等局部特征进行识别检测,从而触发对应捕获的渔网、鱼叉、飞爪、加注管等相应部件,或完成相关跟踪测量。欧空局“清除碎片”(RemoveDebris)项目成功试验渔网对立方星的抓捕,并开展鱼叉、飞爪、拖曳帆、运动跟踪技术验证。德国宇航局开展的“实验服务卫星”(Experimental Serving Satellite, ESS)项目[1],通过卫星机械臂上搭载的立体摄像机对目标卫星上的发动机喷管进行成像识别。美国的FREND机械臂上的立体视觉系统能够对分离螺栓孔和星箭对接环进行识别和抓捕[2]。传统基于点线、边沿特征[3],圆形特征[4],以及关键点提取匹配[5]的方法用以识别帆板支架、卫星对接环和天线等局部特征。然而传统方法通过人工设计特征,难以适用于各类空间条件。且目标卫星上的天线、帆板、对接环、喷管以及各类敏感器会随着其位姿和所受光照条件的变化发生成像模糊,局部遮挡,尺度变化,以及出现阴影等情况。传统方法应对这类问题时,难以持续稳定地发挥其作用,还需将图片下传到地面,由操作人员来对非合作目标上局部特征进行识别标注,花费大量的人力且“自主性”不高。针对上述问题,基于卷积神经网络的空间非合作目标局部特征识别方法成为新的研究热点,使用RCNN、YOLO系列网络对非合作目标整星、天线、帆板、支架、对接环、喷管等典型局部特征进行检测或语义分割[6-8],以及基于卷积网络的非合作目标相对姿态测量[9-11]。近些年基于卷积神经网络的目标检测模型主要包含和SSD系列。且相比而言SSD能够兼顾检测精度和检测时间,为在轨应用提供可能。

文中设计一种轻量化特征融合网络(Non-cooperative Detection Network, NCDN)。构建SSD时引入特征融合策略,融合不同卷积层之间细节特征和语义信息,以适应局部特征尺度变换并提高微小部件的检测精度。同时对特征提取网络MobileNetV2进行轻量化改进。通过通道压缩减少模型计算量和参数量的冗余。并在非合作目标公开数据集SPEED上进行验证。

-

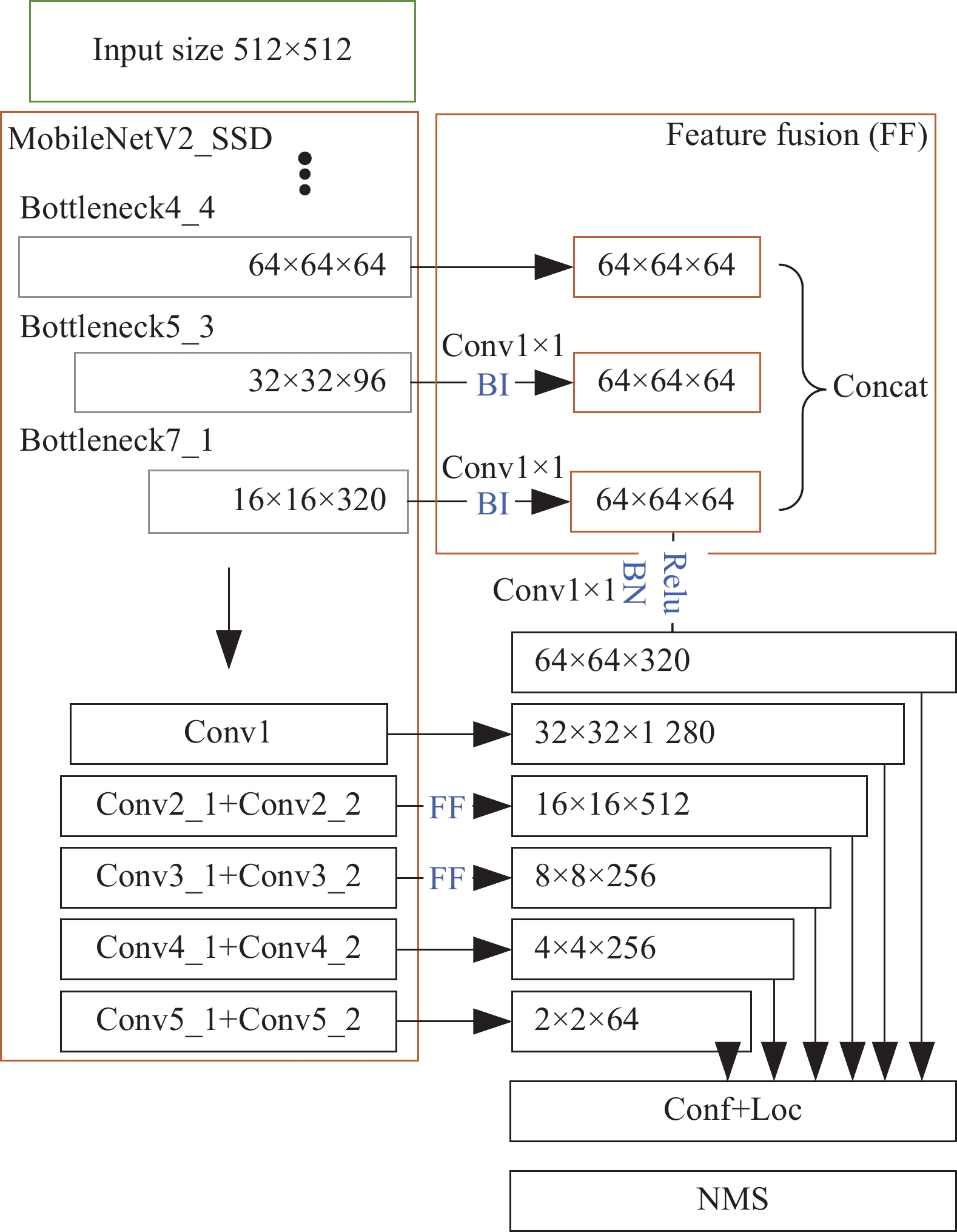

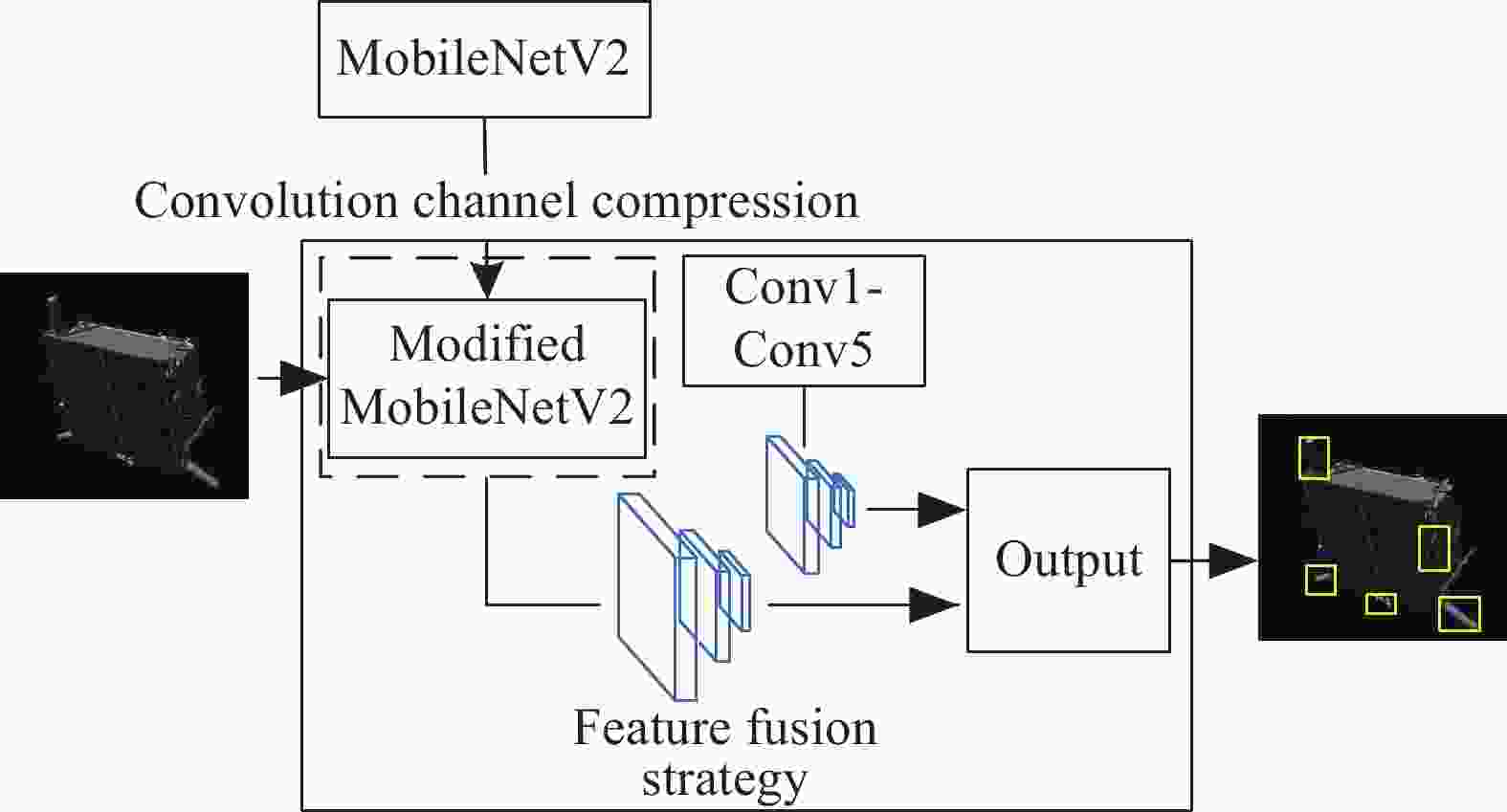

文中设计NCDN思路如图1所示。整体架构为SSD目标检测模型,并以MobileNetV2作为特征提取网络。在SSD模型中引入了特征融合策略,将MobileNetV2中多个卷积层提取的特征进行融合,同时在模型新加的Conv1-Conv5中的两层采取同样的方式融合,使得模型对不同尺度目标具有适应性。此外为减少模型计算量,设计网络轻量化方法,压缩卷积通道以减少特征提取网络MobileNetV2中冗余的参数。并对SPEED数据集中非合作目标Tango局部特征进行检测。

-

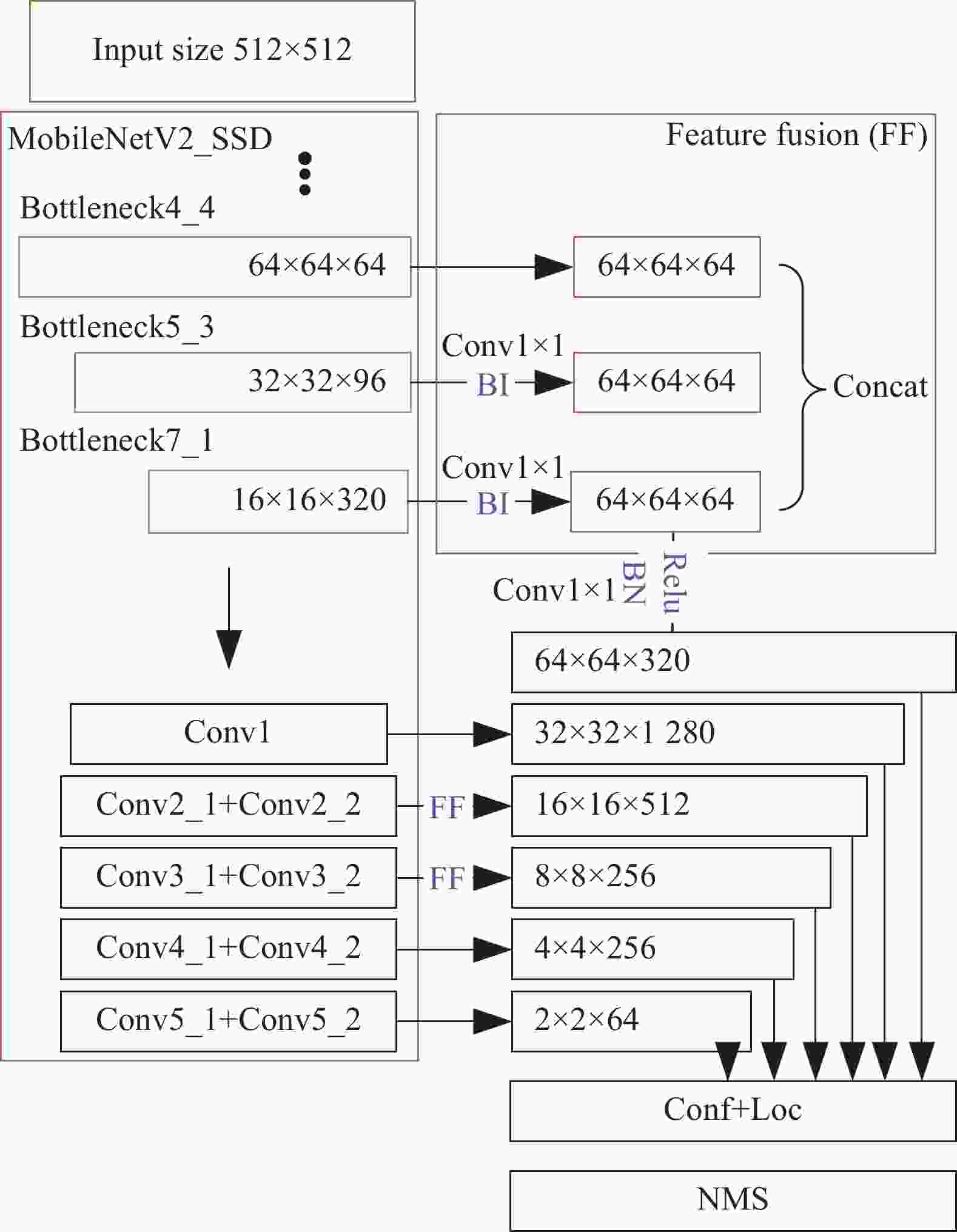

本文设计的SSD网络引入特征融合策略(Feature Fusion)。基础网络采用MobileNetV2中2个卷积层7个Bottleneck结构,共19层。并在其基础上添加8个卷积层Conv2-Conv5,其中每层包含2个小层(ConvX_1,ConvX_2)。由于模型对于目标尺度变化较为敏感,不利于检测尺微小目标,因此借鉴FPN[12]、FSSD[13]和FE-SSD[14]思想引入特征融合策略,将Bottelneck4_4, Bottelneck5_3,和Bottelneck7_1的输出特征进行融合,并将ConvX_1与ConvX_2之间特征进行融合。因为卷积网络在提取图像特征时,随着卷积层变深,提取的语义信息也更为丰富。然而传统SSD模型中这些卷积层之间相互独立,直接从各层特征图中输出检测结果,使得局部细节特征和全局语义特征无法相融合,进而难以检测尺度微小的局部特征。因此特征融合策略可以让低层高分辨率特征图共享高层提取的丰富语义信息以提高检测精度。

以卷积层Bottelneck4_4, Bottelneck5_3,和Bottelneck7_1为例,特征融合策略如下:

(1) 以Bottelneck4_4输出通道数

$64$ 基准,通过通过$1 \times 1$ 卷积将Bottelneck5_3,和Bottelneck7_1输出通道同降为64;(2) 以Bottelneck4_4特征图尺寸为

$64 \times 64$ 基准,通过BilinearIterp, (BI)将Bottelneck5_3,和Bottelneck7_1输出特征图尺寸升为$64 \times 64$ ;(3) 采用Concatenation (Concat)融合方式,将3个同维度特征图融合。并通过BatchNormal和Relu处理后融合成尺度为

$64 \times 64 \times 320$ 的新特征图。ConvX_1与ConvX_2(X=2,3)采用同样的融合策略,ConvX_2为ConvX_1基础上添加

$3 \times 3$ 卷积得到。由于特征图尺寸过小导致特征融合中携带的信息不足,因此最后2层Conv4,Conv5不进行融合,直接从ConvX_2(X=4,5)中生成特征图。如图2所示。多尺度融合特征图最终送入类别预测和经过默认框结构回归得到的位置坐标预测。并通过非极大值抑制算法(Non-maximum Suppression, NMS)得到最终目标检测结果。模型损失函数包括类别损失和位置损失:

式中:

${p_i},p_i^*$ 为类别真值和预测类别;${t_i},t_i^*$ 为位置真值和预测位置;${L_{cls}}$ 为类别损失Softmax交叉熵函数;${L_{reg}}$ 为位置损失SmoothL1函数;${N_{cls}}$ 为类别总数$\lambda $ 为权重系数。 -

基于轻量化特征提取网络的NCDN采用MobileNetV2作为基干。在检测精度上已经能够满足空间非合作目标局部特征检测任务,但训练后的模型存储空间仍有19M,难以满足星上存储空间需求。考虑到非合作目标局部特征类别数量不多于10种,远少于公开数据集所一般要求的1 000+种,从而认为特征提取网络MobileNetV2内部卷积参数有大量冗余。因此,文中提出基于通道压缩的MobileNetV2改进方法,压缩卷积层之间的通道数量,在不过分牺牲检测精度前提下,摒弃冗余参数以换取存储空间的进一步优化。

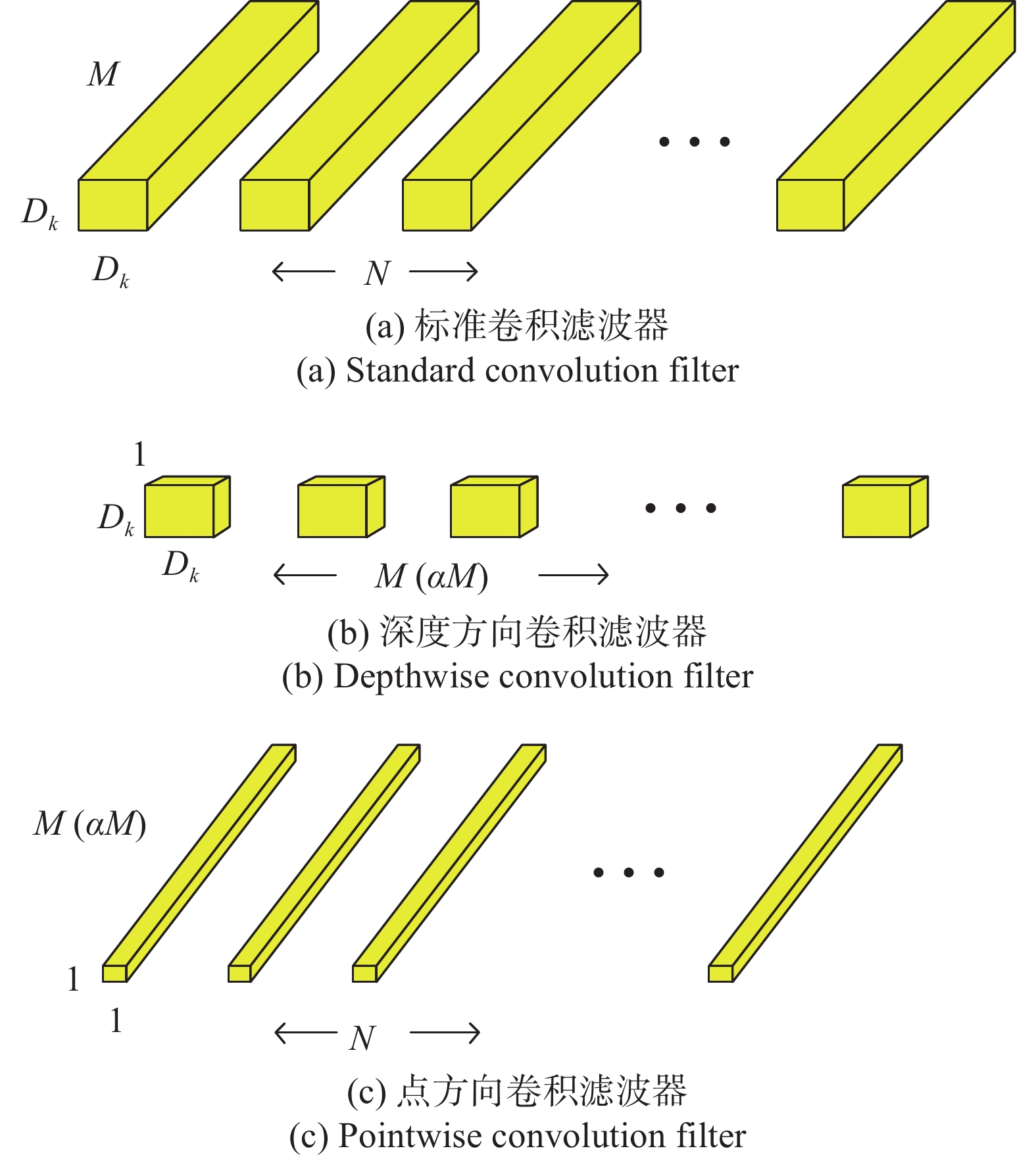

MobileNet在模型结构上采用了逐通道(Depth-wise, DW)卷积搭配逐点(Point-wise, PW)卷积的方式来提特征,这两个操作结合成为深度可分离卷积结构(Depth-wise Separable Convolution)。如图3所示:

$M$ 、$N$ 分别为输入、输出特征通道数,${D_K}$ 、${D_F}$ 分别为卷积核、特征图尺寸。这种结构可以成倍地减少卷积层的时间复杂度和空间复杂度。MobileNet已经极大地减小了计算量,然而对于空间非合作目标局部特征检测任务而言,参数量上仍有冗余。通过在结构中对所有卷积层中卷积核数量乘以缩小因子

$\alpha $ (其中$\alpha \in (0,1]$ )以压缩网络。并以此通道压缩方法改进图3(b)结构。通道压缩后深度方向卷积计算量:

用图3中的图3(b)+(c)代替图3(a),假设有

$N$ 个卷积核,每个卷积核维度是${D_K} \times {D_K} \times \alpha M$ ,输入特征图的通道数是$\alpha M$ ,输出特征图维度${D_F}' \times {D_F}' \times N$ 。则图3(b)表示用$\alpha M$ 个维度为${D_K} \times {D_K} \times 1$ 的卷积核去卷积对应输入的特征图,然后得到$\alpha M$ 个结果,且相互之间不累加。因此计算量是${D_F} \times {D_F} \times {D_K} \times {D_K} \times \alpha M$ ,比压缩前节省$\alpha $ 倍。如图4所示。通道压缩后点方向卷积计算量:

图3(b)生成的特征图维度

${D_F}' \times {D_F}' \times \alpha M$ ,图3(c)表示用N个维度为$1 \times 1 \times \alpha M$ 的卷积核卷积(图3(b))的结果,从而输出特征图维度为${D_F} \times {D_F} \times \alpha M \times N$ ,比压缩前节省$\alpha $ 倍。因此压缩后总体计算量为:

节省α倍。

1.1. SSD结构设计与特征融合策略

1.2. 基于通道压缩的MobileNetV2改进方法

-

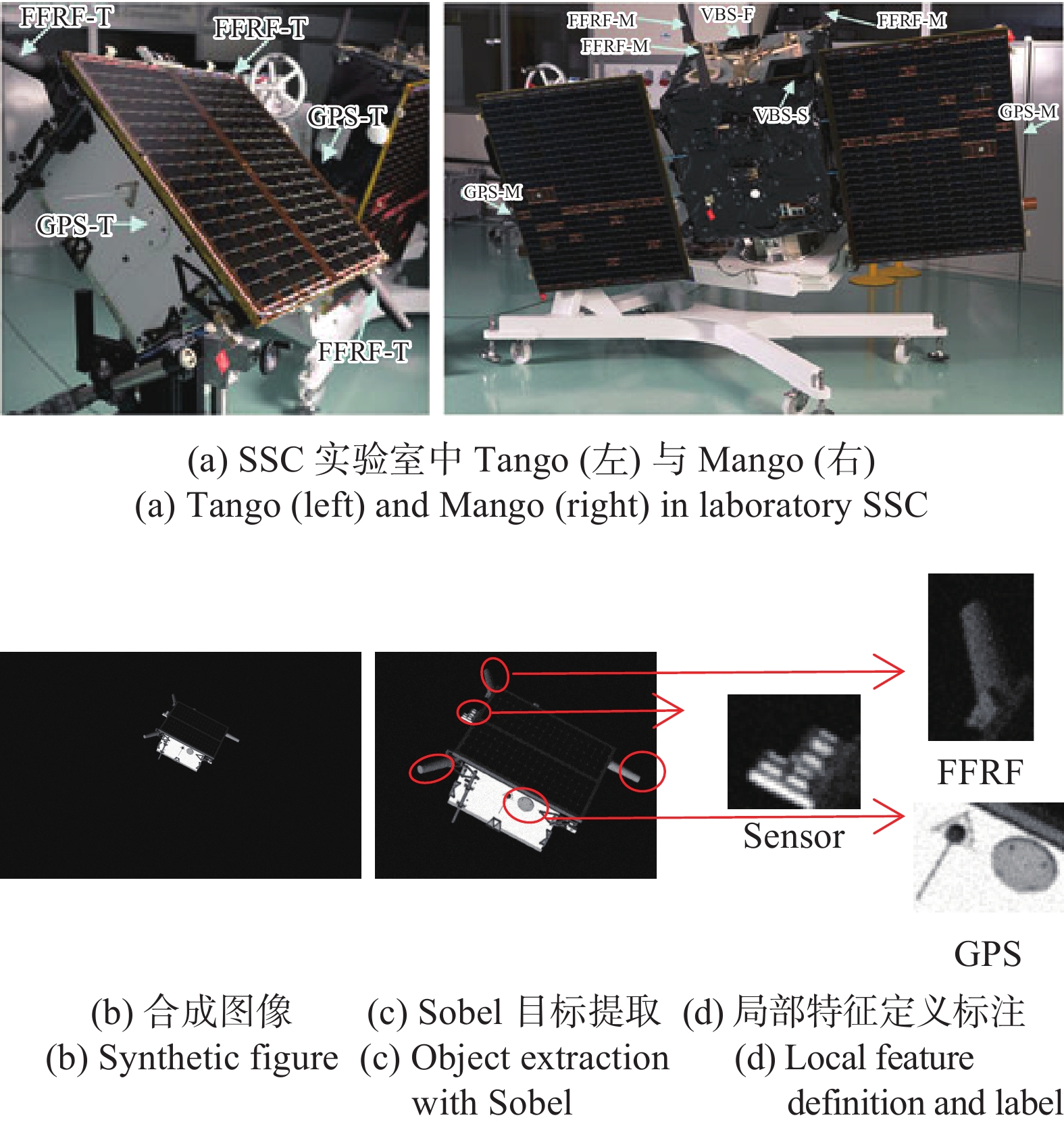

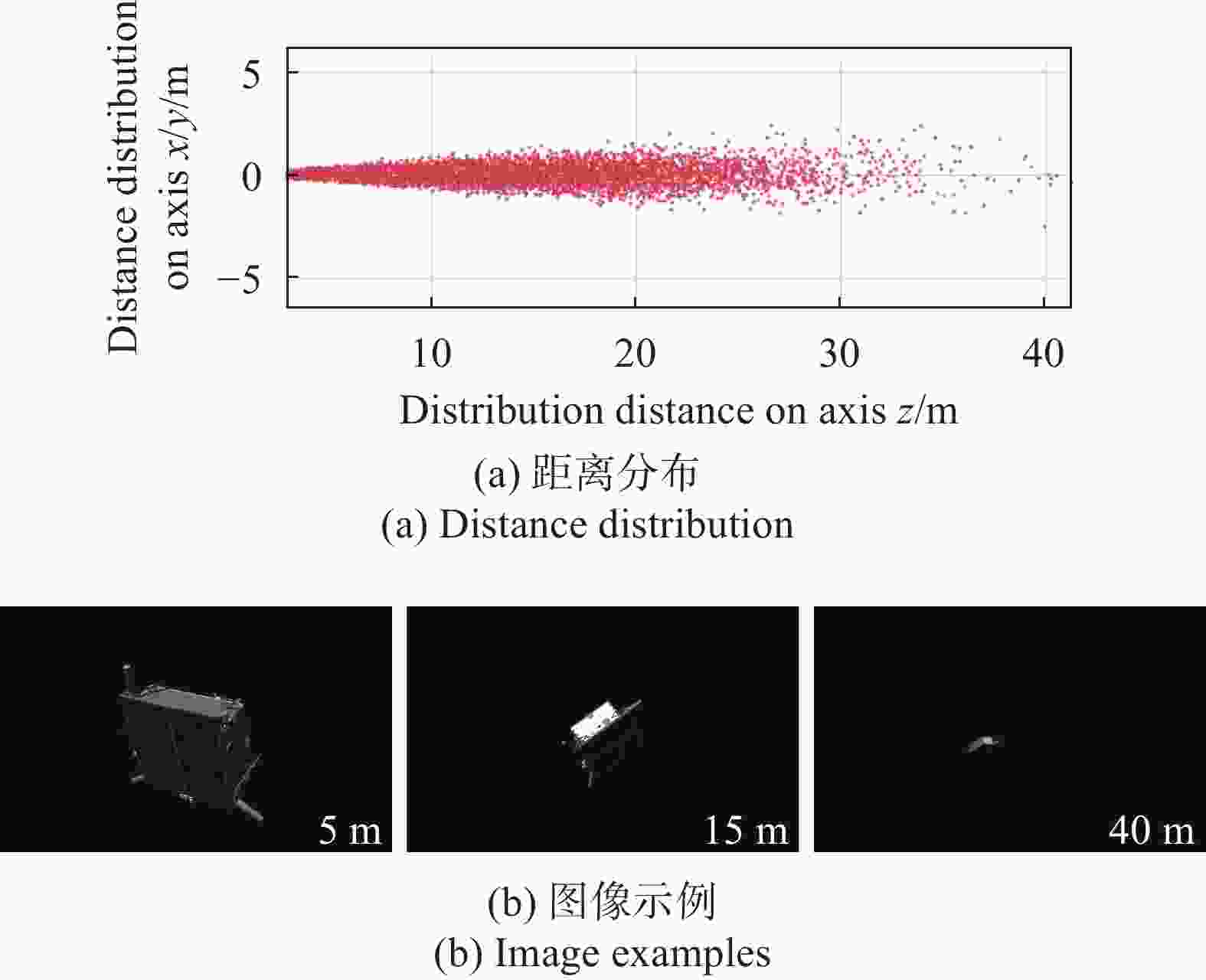

航天器姿态估计数据集(Spacecraft PosE Estimation Dataset,SPEED)由空间交会实验室(Space Rendezvous Laboratory, SLAB)采集。由PRISMA[15-16]任务中低轨卫星Mango对航天器Tango进行拍摄。如图5所示。

利用光学模拟器[17]合成的图像(约15 000张)并给出三轴姿态和4个关键点真值,还设立姿态估计公开挑战赛。文中利用该数据集验证NCDN网络性能,因此首先对数据集非合作目标图像局部特征进行定义与标注。如图6所示。

Tango可供识别的明显局部特征包括GPS天线、FFRT天线以及敏感器。选取数据集中1 000张图像按照7:3划分为训练集和测试集,训练样本进行了左右翻转并设置2种光照条件,数据增强后将样本扩充至4倍。针对空间非合作目标的图像处理通常先去除星空背景,使得处理具有尺度变化目标时最大程度上将有效信息输入算法模型中。因此,在标注训练前利用Sobel算法检测目标边沿并将目标从背景中分离出。

训练处理单元采用20核CPU单元Interl(R) Xeon(R) Silver 4114 CPU@220GHz, 64G内存;GPU采用NVIDIA Quadro P4000,8G显存; Win10系统下用MATLAB2020a配置CUDA10.1进行网络训练。超参数设置为:小批量尺寸为1,训练10代,学习率0.001,采用Adam优化器。

-

参考文献[18]中指出,合成数据对应距离的正太分布区间在50 m内(如图7(a)所示)。

根据相机模型成像公式:

可估算出Tango占据不同像素数为

$n$ ,即所占图像尺寸为$h$ 时,对应的实际拍摄距离为$D$ (如图7(b)所示)。从而通过实验确定NCDN实际使用范围。公式中其余变量含义及实际值如表1所示。Variables Meaning Variables’ value/m $f$ Focus 0.0176 $H$ Actual size of Tango $0.56 \times 0.75 \times 0.025$ $du$ Pixel size of detector $5.86 \times {10^{ - 6}}$ Table 1. Meaning of variables in camera model

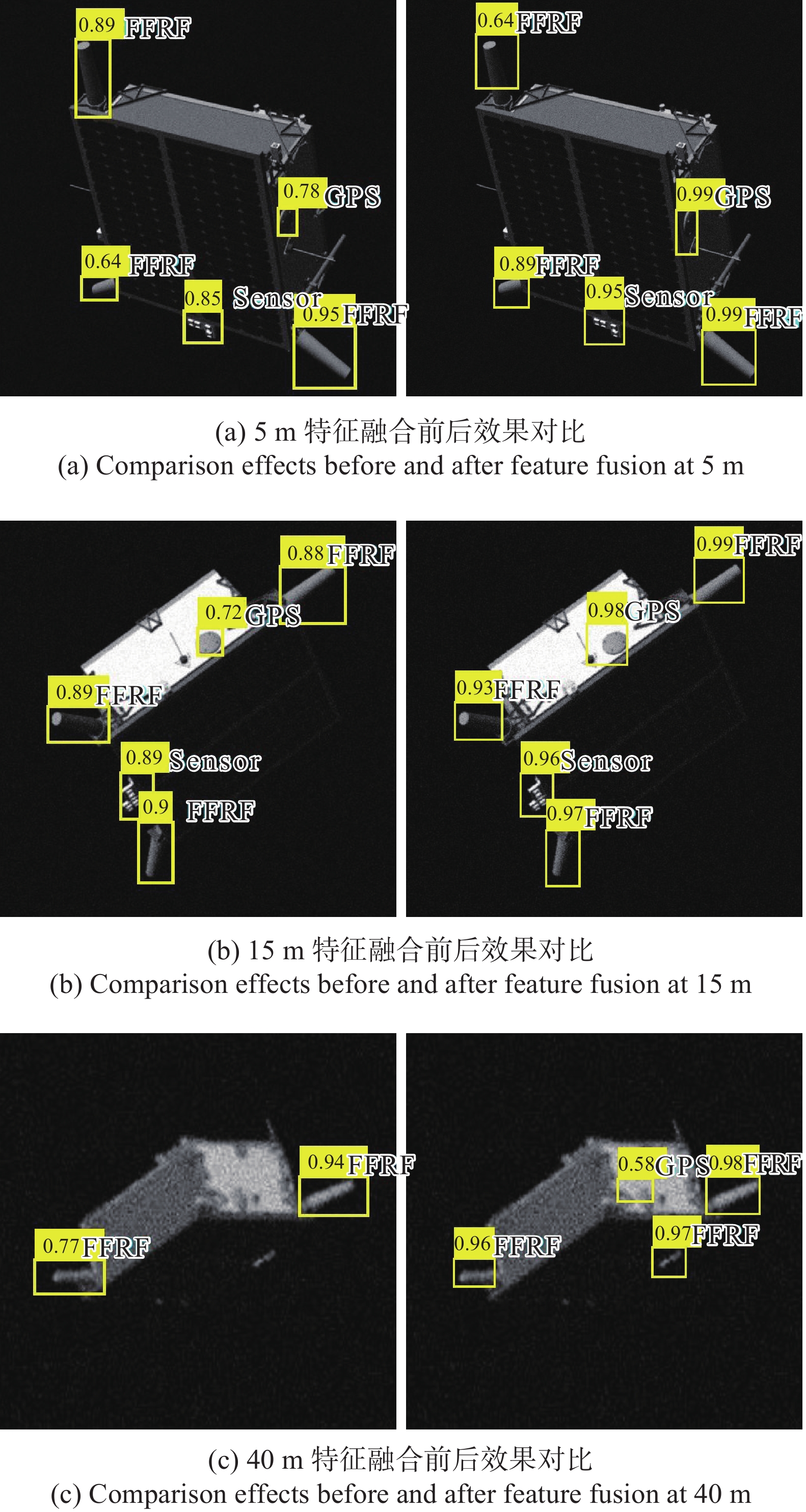

由于NCDN采用了特征融合策略,可将不同卷积层之间信息互通,因此,模型对不同距离下尺度变化导致的非合作目标局部特征分辨率差异有较好的鲁棒性。

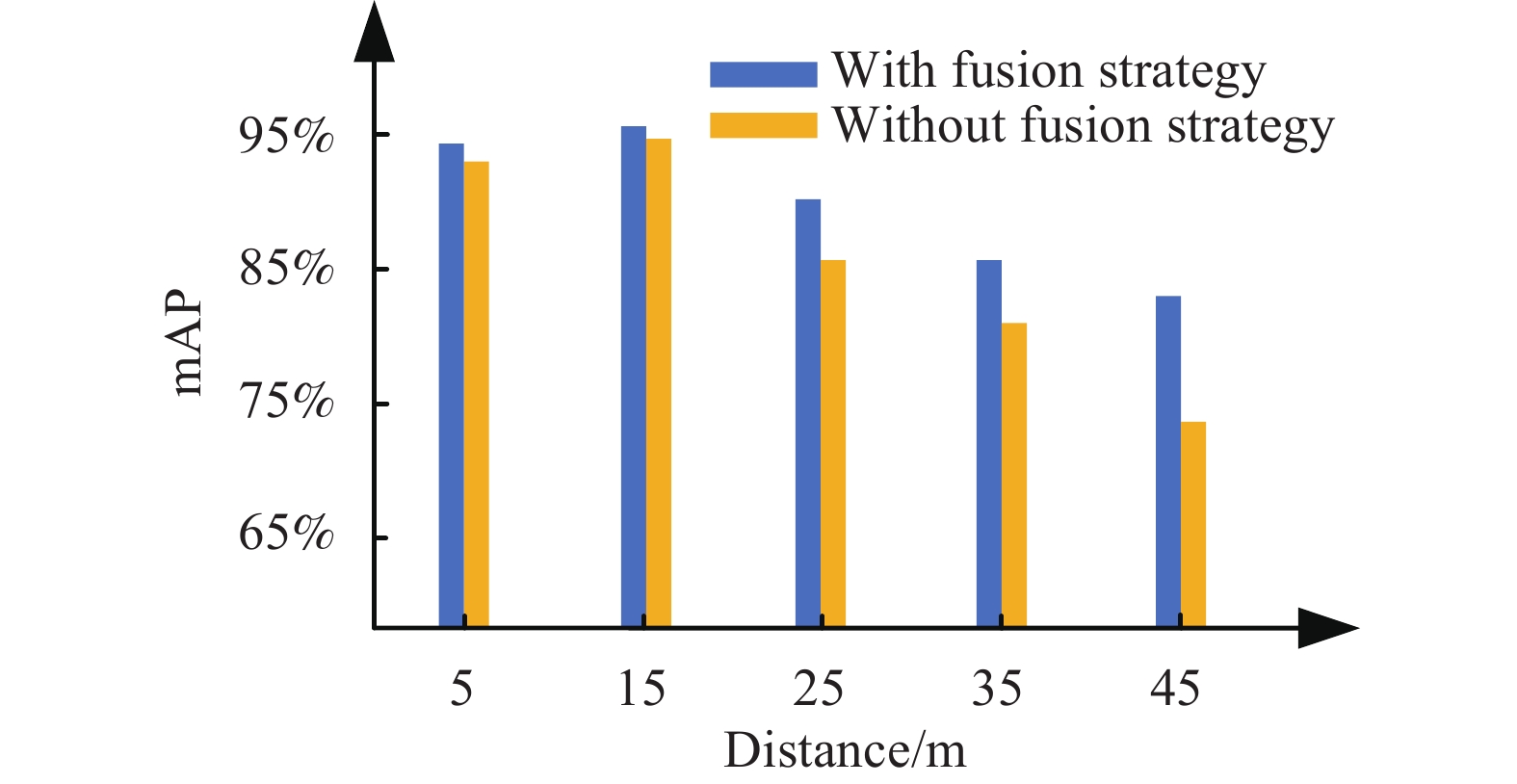

从图8定性对比可看出,目标局部特征随距离变远而分辨率逐渐降低。且随目标姿态变化出现光照条件不均,以及几何形态上的旋转、仿射变换等。不同距离下模型对3种特征平均准确率均值(mean Average Precision, mAP)变化如图9所示。

从图9中看出,引入特征融合策略使得模型对小尺度低分辨率局部特征检测效果有所提升,50 m内mAP从0.857提升至0.898。改进后基本能够满足相关课题和工程项目中近距(25 m内)非合作目标局部特征检测精度0.90的指标。若以各距离段内检测精度0.85为准,整体稳定检测距离区间25 m内提升至45 m内。且图8(b)中40 m下即便引入特征融合,对于局部特征分辨率较低时也较难区分形态相近的Sensor和FFRT,此距离段下NCDN性能逼近极限。

-

文中按照不同比例压缩卷积通道数,以探究在满足不同任务需求下压缩比例可调至多少,压缩比例选定0.25/0.5/0.75/1四个档位,对应压缩比所带来的存储空间节省和相对精度损失如表2所示。

Channel compression rate Storage space of model/MB Relative accuracy loss $\alpha = 1$ 19.0 0% $\alpha = 0.75$ 10.3 1% $\alpha = 0.5$ 5.1 2% $\alpha = 0.25$ 2.2 5% Table 2. Influence of channel compression on NCDN

从表中可以看出,按照0.25倍压缩卷积通道后模型计算量节省75%,存储空间节省88%,而相对检测精度损失仅有5%。当前星上存储资源一般在数MB至百MB,处理器计算能力基本在百MHz的处理能力。根据实际任务需求变换以调整通道压缩比,可使模型存储有效空间减少。实验验证了方法的可行性,也为卷积神经网络部署在嵌入式系统中实现在轨实时检测提供基础。

2.1. SPEED数据集标注

2.2. NCDN尺度适应性分析

2.3. 通道压缩效果分析

-

文中设计一种用于非合作目标局部特征识别的轻量化特征融合网络,即NCDN模型。通过引入特征融合策略实现对不同尺度大小的非合作目标局部特征的准确检测,在SPEED数据集上50 m内mAP可达到0.898,特征融合策略使得效果提升4.1%,可以准确识别SPEED数据集中非合作目标Tango上的GPS天线、FFRF天线和敏感器3种局部特征。卷积核通道压缩后能够在保证不过分牺牲卷积核表征能力、降低网络整体检测精度的情况下,优化卷积核参数的冗余,极大地节省了模型的计算量和存储开销。采用25%计算量时检测精度牺牲约5%,15 m内mAP仍可达0.90。且模型整体存储空间约2.2MB,节省约88%。通道压缩后的模型更适用于空间非合作目标局部特征实时检测,为将来模型部署在嵌入式系统和在轨应用奠定基础。

DownLoad:

DownLoad: