HTML

-

红外弱小目标及小目标检测是计算机视觉中的一个关键问题,因为目标上几乎没有可利用的信号,一般小目标于文中研究的红外小目标相比,其内在特征的稀缺性和背景复杂性有所不同,红外弱小目标的局部信噪比低。一般视觉任务中的小物体通常占图像区域的1%左右,而红外弱小目标的像素可能只占图像区域的0.1%或者更少。

红外弱小目标检测是指通过红外系统对打击目标进行识别检测和跟踪,主要应用在预警技术、导弹精确制导、海上巡逻预警监测等领域。如何在信噪比低、红外目标形状不规则及目标在像平面上像素占比较少等限制条件下能够精准、快速、稳定地检测出红外弱小目标是对武器的系统信息化和智能化的重要体现。

目前,红外弱小目标检测的传统算法中基于滤波的算法有:基于最恰对比度显著性、背景抑制中的二维空域廓线法等[1-2],通过滤波的方式增强目标特征和抑制背景信息,总体计算量小,但检出率较低。基于人类视觉系统的方法有:基于局部对比度的算法、基于低秩稀疏恢复等[3-4],通过人类感知特性对图像局部差分形成显著化目标特征,准确率高,但存在建模过程复杂,泛化能力较差等问题。红外图像数据集背景和目标特征多样化,使得传统检测算法必须与数据集高度匹配,且传统数学建模算法设计过程复杂,泛化性低,使得检测红外弱小目标成本较高。通过深度卷积神经网络识别检测红外弱小目标具有泛化能力强、建模过程更智能、鲁棒性更强等优点,运用深度学习建立通用性较强的红外检测系统成为越来越多学者的研究方向。

深度学习在红外弱小目标检测的研究主要有:赵琰等人使用YOLOv3的方法在自建数据集上进行检测[5],但是在公开数据集上准确率较低;冯小雨等人使用Faster RCNN进行检测[6],实时性低,且准确率有待提高。总体而言,深度学习在检测红外弱小目标方面需要解决以下问题:(1) 卷积神经网络结构在对局部信噪比较低的图像进行特征提取时具有敏感度低、特征信息消失等不利因素;(2) 深度学习对复杂背景下的弱小目标检测能力较差,误检率较高;(3) 红外数据集作为深度学习的训练数据集时,不同背景信息的图像数量需符合正比例分布。

论文在深入研究YOLO系列算法[7-10]的基础上,提出一种基于红外弱小目标检测的多尺度特征融合检测算法J-MSF,以采用单帧目标检测的实时算法YOLO框架为基础,以地/空背景下红外图像弱小飞机目标检测跟踪数据集[11]为研究对象,通过实验结果证明了所提出的红外弱小目标检测算法J-MSF的优越性,较YOLOv3系列算法和YOLOv4算法都有一定提升。

-

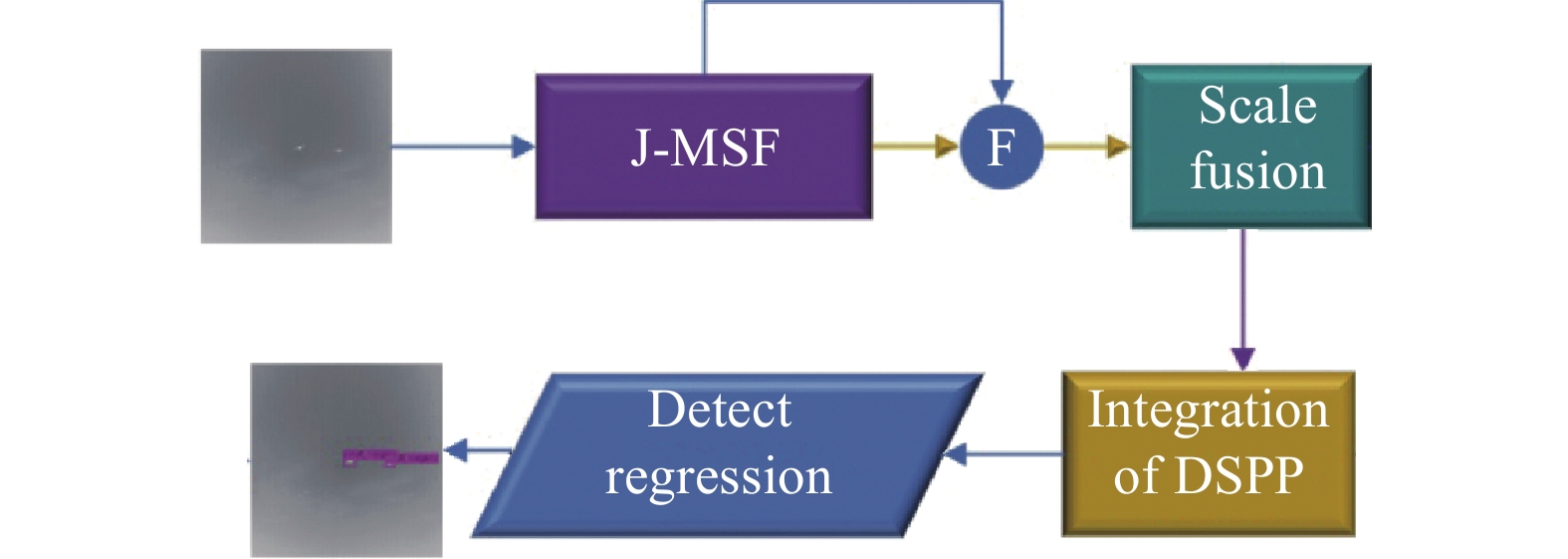

YOLO检测目标流程可分为三大部分,待检测的图像作为输入,第一部分首先通过主干提取网络采集多层特征图信息;第二部分对提取到的不同特征图进行上采样并与对应特征融合叠加,获得精细化的语义特征表示;第三部分为分类与回归输出模块,主要对目标进行分类及边框预测。如图1所示。

YOLOv3主干特征提取网络采用的是Darknet-53,YOLOv4的主干提取框架是CSPDarknet-53,后者在前者基础之上对每个残差块增加自上而下的并行连接,增加特征的初始特性,并与PAN自下向上的路径相互作用,使得梯度流分裂,梯度流通过不同的网络路径进行传播,增加特征提取的丰富度。YOLO颈部的作用为不同融合尺度特征图对不同大小的目标进行多尺度检测。YOLOv4在特征融合部分在YOLOv3的基础上增加SPP、SAM、PAN等模块。YOLO检测的头部是对每个预测目标输出目标边框、置信度、类别。YOLO采用的 对bbox的损失计算是对预测框和实际真实框之间的平方误差损失之和,YOLO的预测边界框总损失为公式(1):

式中:

${\rm{los}}{{\rm{s}}_1}$ 为预测框位置损失,即中心点坐标x和y以及预测框高度h和宽度w的损失;${\rm{los}}{{\rm{s}}_2}$ 为置信度损失和${\rm{los}}{{\rm{s}}_3}$ 分类损失。YOLOv4在YOLOv3的基础上进行改进补充,将Darknet-53改进升级为CSPDarknet-53,以及增加SPP模块,增加注意力机制模块,优化训练框架等,检测模块边界框回归依然采用原法。检测模块和主干提取网络部分采用的PAN通过自下向上的路径增强浅层中准确的定位信息流,建立浅层特征和深层特征的交流通道。

-

红外弱小目标相比于可见光图像小目标更难以检测,主要原因是红外弱小目标的像素占比极少,相互作用的卷积核之间的局部性质会强加有限感受野,8倍降采样特征图像对弱小目标的信息就很难提取到,进而造成目标信息丢失。提出算法整体检测流程如图2所示,首先,主干提取框架进行多级特征提取;其次,特定融合策略作为检测网络颈部,在流程图中用F来表示;最后,检测网络头部回归输出目标。为解决高层感受野目标易消失问题,提高弱小目标检出率,在主干提取网络部分提出JAnet结构来搭建多通道提取网络,使用DSPP等量整合多级融合特征的策略,对算法损失函数采用特定高斯优化。

-

可见光图像具有对比度高,层次感强,纹理信息明显,相对于可见光图像,红外图像可较好地体现远距离的物体的边缘信息,但红外图像灰度值密集地分布在某些相邻灰度级上。经典算法CNN结构相互作用的卷积核之间的局部性质会强加有限感受野,且单通道结构使得灰度级较少的红外图像中弱小目标信息极易丢失。为了解决在深层的网络结构中避免弱小红外目标像素信息丢失,提高对弱小目标的检出率,提出了一种分流聚合双通道结构JAnet(Junction Aggregation Net)。

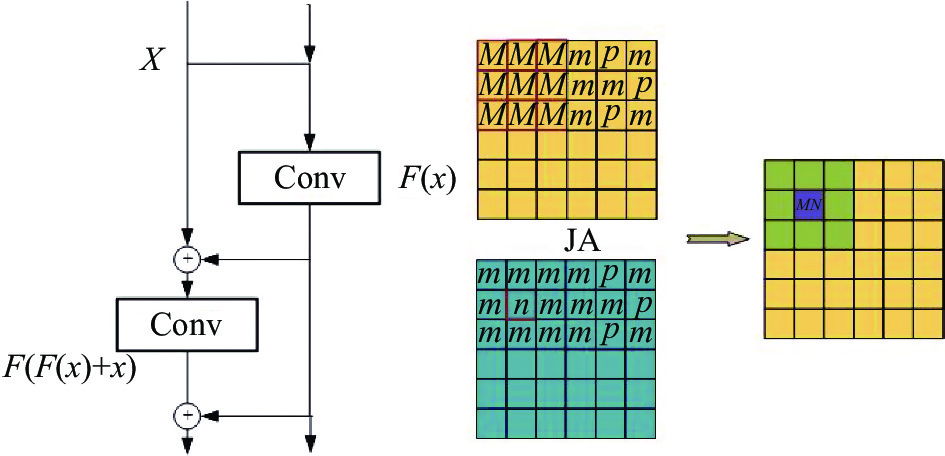

分流映射通过把图像

${{x = }}{\mathbb{R}^{H \times W \times C}}$ 输入并进行JA操作来保留原始信息流,如图3所示。其中,${\mu _{j|i}}$ 是所有预测向量的加权和,${\eta _{j|i}}$ 是前一层网络和权重矩阵的乘积,${c_{ij}}$ 是卷积核系数。计算公式如下:JAnet采用mish激活函数进行非线性操作之后进行输出,mish激活函数[12]在负值时允许较小的负梯度流入,保证信息不会中断。

JAnet网络期望通过相同底层卷积对图像特征进行传递并分流映射实现映射输出,期望映射关系为

$G\left( x \right) = M\left( {M\left( x \right) + x} \right)$ ,最终得到的期望映射输出为$M\left( x \right)$ 和$G\left( x \right) + M\left( x \right)$ ,保留更丰富的梯度流,图3描述了JAnet结构单元信息。JAnet结构优势:

(1) 增加感受野中目标信息的完整性,并保持局部与整体空间关系的不变性。

(2) 分流聚合的结构更有利于信息的传递和汇总,可以有更深的网络层数,并可更好地描述复杂的红外背景。

(3) 网络参数的层更少,训练时长和检测速度更优。

根据J-MSF主干网络结构,文中设计更适用于提取红外弱小目标J-MSF的主干提取网络,深的网络结构可以对复杂的背景信息进行描述,某些红外图像背景信息较为复杂,主干提取框架选取5个卷积提取块。在实时检测中,目标是移动的,显现在红外图像中目标所占像素有大有小,多级特征可以兼顾大小目标进行检测,主干特征图提取框架结构及J-MSF整体结构如图4所示。

-

跨层特征融合已被证明是缓解计算机视觉中尺度变化问题的一种有效方法,它通常通过线性组合来实现,如加法或级联[13-14]、或非线性自顶向下调制[15]。然而,这些方法不是为红外小目标检测任务设计的,与一般的计算机视觉任务不同,红外小目标检测的瓶颈是如何在深层保持和突出弱小目标的特征,而不是在浅层缺乏高层语义。为此,文中采用了新的多级特征融合策略,将主干网络的降32倍特征图上采样与降16倍特征图融合作为基础融合特征图。基础融合特征图再经上采样与降8倍特征图融合作为动脉融合特征图,在此处的动脉特征是检测的信息流的隘口,因此,增加DSPP模块用于整合融合特征,抑制弱小目标信息的丢失及掩盖。表1为基础特征图、动脉特征图、DSPP及各输出特征图网络参数,最终输出特征图较原图像尺度为16×16、32×32、64×64,融合更底层的特征有助于弱小目标检测,但仅增加浅层语义同样会带来更高的误检率,因此,弱小目标的多尺度策略如图4所示。并通过K-means聚类[9]得到3个不同尺度的预选框,即(1,1),(2,2),(4,3),(3,4),(4,4),(5,5),(7,6),(13,6),(25,25),算法初值的设置主要用于预测部分遮挡目标的检测框,该预选框初值同样也用于基准对比算法。

Fusion map/layer Kernel

sizeOutput size Stride Channel Basic-feature map - 8×8 - 1024 Artery-feature map - 16×16 - 768 Detection map 1 - 32×32 - 30 Detection map 2 - 64×64 - 30 Detection map 3 - 128×128 - 30 Maxpooling 1 3 32×32 1 128 Maxpooling 2 5 32×32 1 128 Maxpooling 3 7 32×32 1 128 Table 1. Dimensions of network parameters

-

J-MSF损失函数中的bbox回归是提取bbox中心点的信息

$\mathop t\nolimits_x $ 和$\mathop t\nolimits_y $ 以及bbox的高宽信息$\mathop t\nolimits_w $ 和$\mathop t\nolimits_h $ 。在提出的 算法中对最终预测框的坐标信息建立高斯模型,给定预测输入$x$ 和输出$y$ 都需包含高斯参数,如公式(4)所示:YOLO损失函数是使用bbox信息进行回归建模,值只包含了边界框的参数,并没有对预测的边界框参数的置信度进行回归,所以J-MSF的bbox边界框需要对中心点和高宽进行均值操作,如公式(5)~(7)所示:

但是由于均值必须表示为网格内的中心点坐标,实际值为在整张图片中的比例值,所以使用Sigmoid激活函数为输出方差即为增加的预测边框置信度值,每个方差的大小代表了不同坐标的不确定性,方差函数同样需要经过Sigmoid函数进行激活,如公式(8)、(9)所示:

在原损失函数中对于bbox的损失计算结果是对预测框和实际真实框之间的平方误差损失之和,但是引入高斯模型之后,要对原bbox目标框位置损失函数进行重新设计,通过负对数似然损失进行计算。而置信度损失依然采用二元交叉熵损失,公式(10)为J-MSF高斯损失函数表达式:

式中:

$L_{conf}\left( {o,c} \right)$ 为置信度损失;$L_{conf}\left( {l,g} \right)$ 为高斯定位损失。公式(11)进行表示置信度损失,其中,${o_i} \in \left[ {0,1} \right]$ 表示预测目标边界框与真实目标边界框的IOU,c为预测值。公式(12)中l为预测位置坐标信息,g为目标真实值信息。 -

首先,通过目标检测评价标准定量分析JAnet对检测弱小目标的性能影响,利用多尺度融合模块及特定损失函数检测弱小目标的灵敏性,进行消融验证分析,提出检测红外弱小目标的算法被记为J-MSF算法。其次,用弱小目标数据集验证算法的性能,与YOLO系列目前衍生算法以及主流算法进行对比定性分析。

-

弱小目标图像的局部信噪比可以评价弱小目标检测的难易程度,目标的大小可以通过所占像素的大小进行判断,信噪比的数值可以判断目标信息的强弱。

描述图像中的弱小目标的信噪比称为局部信噪比[16](Local Signal to Noise Ratio),描述为公式(13):

式中:

$ {F}_{r} $ 为目标区域的均值;$ {F}_{B} $ 为背景区域的均值;$ {\delta }_{B} $ 为背景区域的标准差。一般背景区域大小为目标区域大小的3倍。以下所有实验在地/空背景下红外图像弱小飞机目标检测跟踪数据集[11]下进行研究,进而对深度学习模型性能进行标准判断。此数据集一共由22段数据组成,30条航迹、16177帧图像、16944个目标,图中目标均为空中固定翼无人机(燃油动力),飞机长度为2.0 m,翼展长度为2.6 m,飞机速度为空速30 km/h。所拍摄的图像飞行的航路近端到远端的范围为500~5000 m,高度的范围为50~500 m。数据集中第2段、第4段为双目标,其余为近远不同的单目标和不同背景下的数据段。图像像素大小均为256×256。图5为检测测试集目标占像素大小分布图,表2为测试集的信噪比分布表。

SNR region 3.26-3 3-2 2-1 1-0 0-(−1.97) −3-(−20) Data4 0 5 209 379 204 2 Data8 2 39 108 94 101 55 Data12 5 84 407 424 341 238 Data16 5 247 214 15 1 12 Data20 0 12 155 197 29 8 Total 12 387 1093 1109 676 315 Table 2. SNR data distribution table of test set

-

在检测过程中,红外弱小目标的检测算法召回率(检出率)是一个重要指标,P-R曲线是根据不同置信度的召回率值对应的准确率来描述模型性能的指标。目标召回率(检出率)R和检测的准确率P可分别表示为:

式中:

$ {X}_{TP} $ 表示正确检测出来的目标数;$ {X}_{FN} $ 表示没有被检测出来的目标数;$ {X}_{FP} $ 表示被错误检出的目标数。 -

所有算法模型均采用4∶1的比例进行训练集和测试集的划分,即Data4、Data8、Data12、Data16、Data20作为测试集数据,其余作为训练集数据。

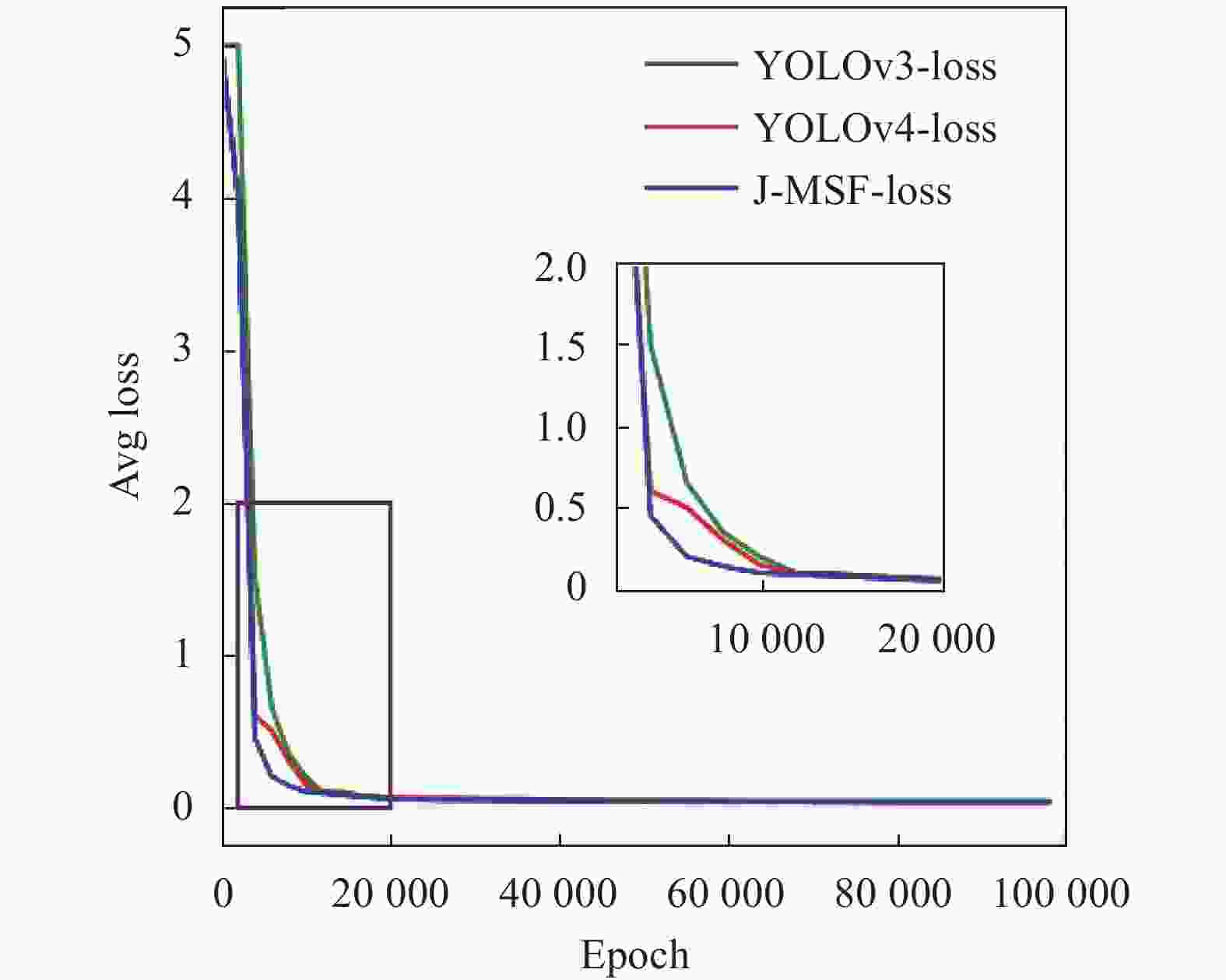

所以训练均使用的超参数如下:训练学习率以Step策略衰减的方式进行设置,即开始系数为0.0001,当训练迭代次数为40000次和45000次是分别将学习率减少为0.00001和0.000001。训练损失曲线如图6所示。实验条件为:在Ubuntu16.04系统,采用的深度学习框架是Darknet框架;GPU采用的是NVIDIA GeForce GTX 1080 Ti,内存为11 GB。

-

针对第1章所提的地/空背景下红外图像弱小飞机目标检测跟踪数据集[11]中Data4、Data8、Data12、Data16、Data20作为测试集,测试集共3592个目标,和相同的训练参数进行测试,在定性对比实验中,与当前YOLO系列算法及衍生算法检测输出结果进行对比。在定量对比实验过程中,通过J-MSF和YOLO系列算法进行对比,对召回率(检出率)、AP (AP50) 值、P-R曲线综合评估模型的检测性能。最后,与目前主流算法进行对比实验。

-

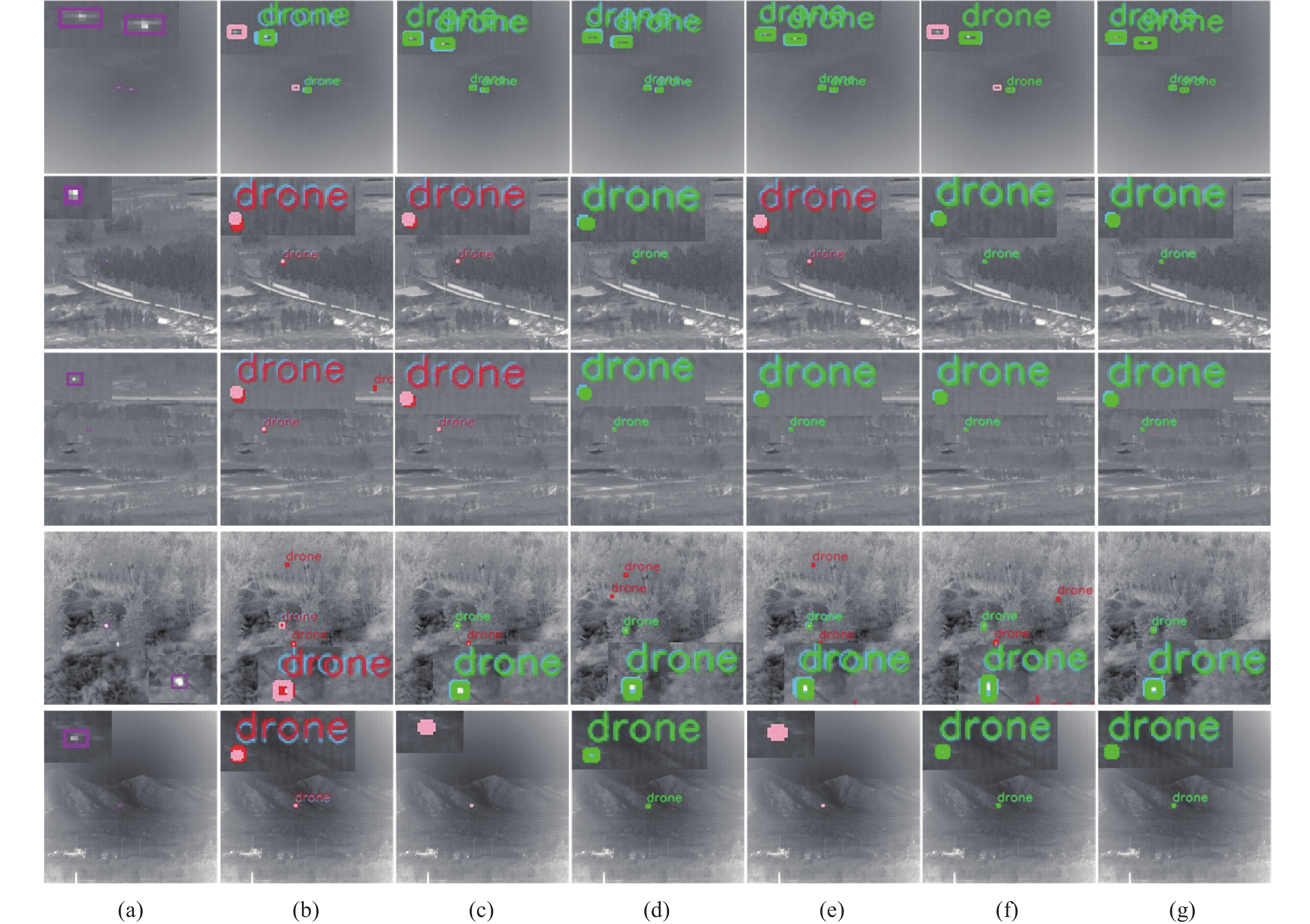

为验证所提算法在实际任务中的有效性,抽取测试集每个序列目标检测较为困难的实际背景图像进行测试,评估算法检测结果并进行可视化分析。可视化检测结果展示如图7所示。粉色标记为未检出的真实目标,红色标记为在检测错误的目标,绿色标记为检出目标,所提算法J-MSF都可以进行正确检出。

-

为检验所提出的JAnet网络结构对弱小目标的提取能力,在采用相同网络框架YOLOv3上进行验证,即只更换主干提取网络进行实验。Darknet-53-JA将网络ResNet更换为JAnet结构,J-MSF为最终设计提取弱小目标的主干网络。如表3所示,多通道的JAnet对检出率有显著提升,验证多通道的网络结构可以缓解弱小目标信息的丢失。

Model $\mathop X\nolimits_{FN} $ R AP Darknet-53 458 87.2% 86.38% Darknet-53-JA 343 90.0% 88.43% J-MSF 217 94.0% 93.13% Table 3. Contrast experiment of JAnet network

通过消融实验来验证算法模型的性能以及各个模块对所提数据集的检测能力,即对检测性能和检测速度的影响。表3中的代表的含义如下: (1) Darknet-53:YOLOv3使用的主干提取框架。(2) J-MSF:提出的红外弱小目标的主干提取网络。(3) Loss:YOLO系列算法采用的损失函数称为D,J-MSF算法改进的高斯损失函数称为M。(4) Fusion:针对检测红外弱小目标采用的新的特征融合策略。消融实验是通过加减关键模块来分析各模块对算法性能的影响,文中针对检测弱小目标设计的主干提取框架、融合策略、特定损失等组件进行消除实验。J-MSF的backbone和Darknet-53作对比,随着组件的添加,算法的性能逐步提升。如表4所示,采用多通道JAnet网络结构的检出率和整体AP值均有显著提升。同时,所提的多尺度融合策略对弱小目标检测性能也都有所提升。提出的优化高斯损失函数可以有效提高检出率,但由于噪声的影响,随着检出目标的增多,准确率出现一定程度的下降。最后,与YOLOv3相比,检出率提升9.07个百分点,AP值提升9.91。且同时加入JAnet结构、融合策略和特定损失模块带来的提升,要比各个模块带来的涨点都高,这说明各组件间存在促进互补关系。

Darknet53 J-MSF Loss Fusion Precision R AP FPS √ - D - 86% 87.20% 86.38% 66.3 √ - D √ 92% 92.20% 92.74% 57.5 √ - M - 89% 94.04% 93.88% 71.9 √ - M √ 82% 95.00% 93.47% 71.6 - √ D - 90% 94.00% 93.13% 59.0 - √ D √ 90% 94.10% 93.46% 73.4 - √ M - 86% 95.85% 94.80% 66.8 - √ M √ 88% 96.27% 96.29% 67.6 Table 4. Ablation study

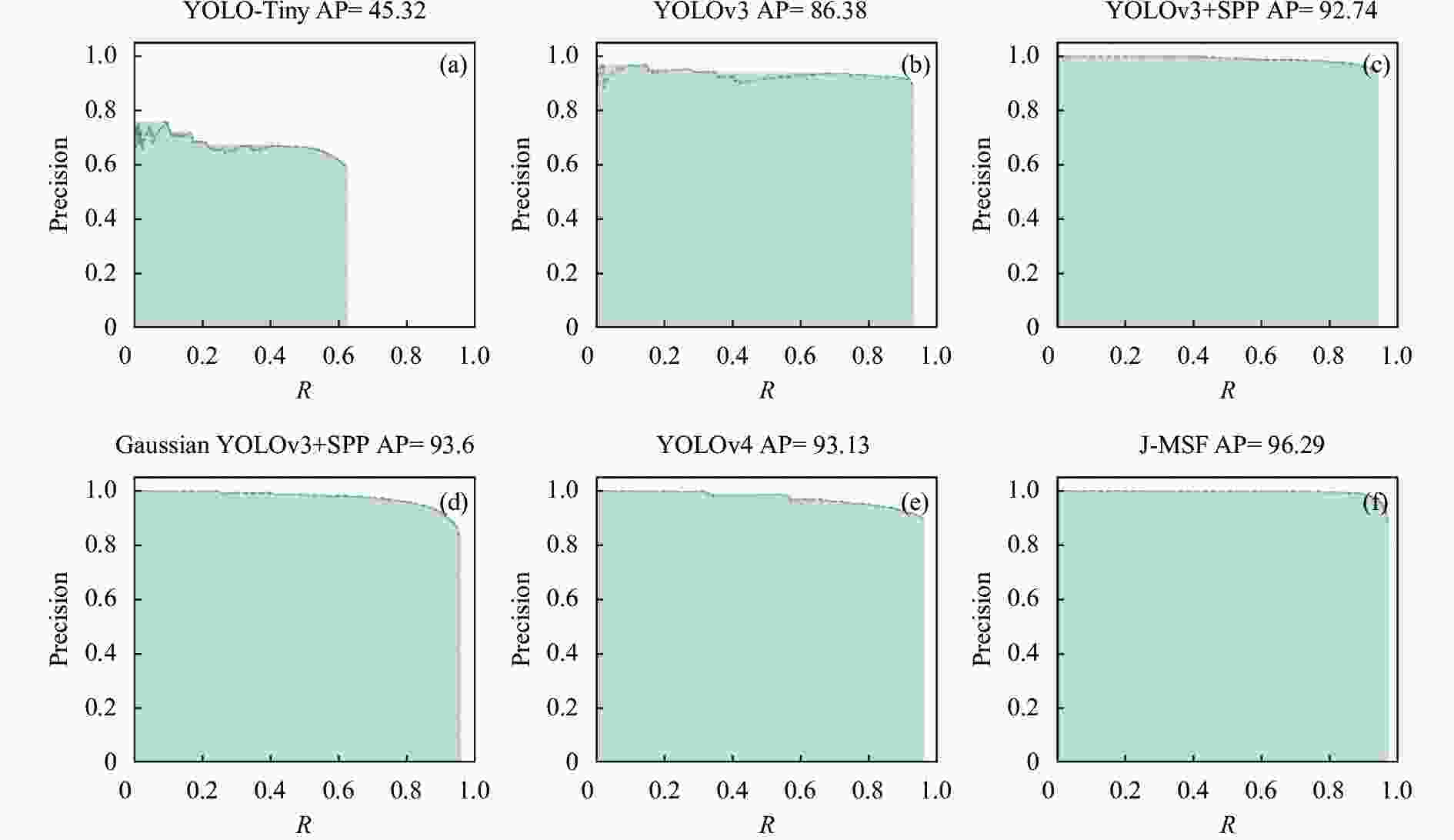

还与基于红外弱小目标检测YOLO系列衍生算法进行了对比实验,它们分别是YOLO-tiny、YOLOv3+SPP[17]、Gaussian YOLOv3+SPP,还有YOLOv3和YOLOv4。图8为它们的P-R曲线,可以看出所提算法J-MSF有显著的提升。从表5可以看出,J-MSF漏检总数优于其他算法,验证了算法的优越性。

Detection algorithm $\mathop X\nolimits_{TP} $ $\mathop X\nolimits_{FP} $ $\mathop X\nolimits_{FN} $ Precision R AP YOLO-Tiny 2389 1355 1203 59% 64% 45.32% YOLOv3 3309 435 283 88% 92% 86.38% YOLOv3+SPP[17] 3318 283 274 92% 92% 92.74% Gaussian YOLOv3[18]+SPP 3407 758 185 78% 95% 93.60% YOLOv4 3397 446 195 88% 95% 93.13% J-MSF 3443 451 149 88% 96% 96.29% Table 5. Results of infrared target detection by YOLO serial model

-

对不同主流的目标检测网络通过相同的数据训练得到的模型进行评价[19],主要比较不同目标检测算法对红外无人机目标的检测识别能力,并验证文中算法的检测性能。对比算法包含在实验中,分别采用AP50、帧率(FPS)评价指标进行检测准确度和检测速度的定量分析。

如表6所示,所提算法与主流目标检测算法对比,从目标检测的精度指标来看,所提算法的AP值有了较大的提高。图9为主流算法测试结果对比图,在检测效果和检测实时性方面,文中算法检测速度与目标检测算法SSD300相比,虽未达到高度实时性,但与YOLO系列算法相比,依然占优势,其主要原因是JAnet结构相比于ResNet降低了网络参数量,提升算法的运行效率。

Table 6. Comparison of mainstream algorithms

-

文中对红外弱小目标检测问题进行研究,提出一种多通道多尺度特征融合算法J-MSF,对红外弱小目标检测。通过提出的 JAnet网络结构,搭建主干提取网络,并将底层特征与输出特征进行融合,同时提出算法采用改进高斯损失函数,利用DSPP策略整合融合特征,进而提高弱小目标的检出率。提出算法主要有如下研究成果:

(1) 针对红外弱小目标的图像特点,提出JAnet结构来设计更适合红外弱小目标特征提取的主干网络提取框架。

(2) 设计适用于检测弱小目标的多尺度特征融合策略,采用DSPP (Down Spatial Pyramid Pooling)对融合特征等量进行整合。

(3) 设计损失优化函数,对检出目标位置损失采用高斯进行优化,进一步提高对弱小目标的检出率,并对损失函数进行剪枝。在检测感受野中,增强弱小目标特征的曝光尺度。

通过公开数据集进行算法有效性的验证,即对弱小目标的检测能力有着明显的提升。但是红外图像成像等因素的影响对弱小目标的识别难度依然很大,通过网络改进难以实现,下一步工作是针对干扰去除进而实现更精准识别进行研究。

DownLoad:

DownLoad: